O uso de sistemas automatizados de tomada de decisão pelos governos reflete questões sistêmicas de injustiça e desigualdade

Software e tecnologia podem processar grandes quantidades de dados instantaneamente, tornando-os altamente atraentes para uso governamental. Crédito:Shutterstock

Em 2019, o ex-relator especial da ONU Philip Alston disse estar preocupado que estivéssemos “tropeçando como zumbis em uma distopia de bem-estar digital”. Ele estava pesquisando como agências governamentais em todo o mundo estavam se voltando para sistemas automatizados de tomada de decisão (ADS) para cortar custos, aumentar a eficiência e direcionar recursos. ADS são sistemas técnicos projetados para ajudar ou substituir a tomada de decisão humana usando algoritmos.

Alston estava preocupado por um bom motivo. Pesquisas mostram que a ADS pode ser usada de forma discriminatória, exacerbando a desigualdade, infringindo direitos, classificando as pessoas em diferentes grupos sociais, limitando erroneamente o acesso a serviços e intensificando a vigilância.

Por exemplo, famílias foram à falência e forçadas a crises depois de serem falsamente acusadas de fraude de benefícios.

Pesquisadores identificaram como os sistemas de reconhecimento facial e as ferramentas de avaliação de risco são mais propensos a identificar erroneamente pessoas com tons de pele mais escuros e mulheres. Esses sistemas já levaram a prisões injustas e decisões de sentença mal informadas.

Muitas vezes, as pessoas só descobrem que foram afetadas por um aplicativo de ADS quando uma de duas coisas acontece:depois que as coisas dão errado, como foi o caso do escândalo A-levels no Reino Unido; ou quando as controvérsias são tornadas públicas, como foi o caso do uso da tecnologia de reconhecimento facial no Canadá e nos Estados Unidos.

Problemas automatizados Maior transparência, responsabilidade, prestação de contas e envolvimento público no projeto e uso de ADS são importantes para proteger os direitos e a privacidade das pessoas. Há três razões principais para isso:

- esses sistemas podem causar muitos danos;

- eles estão sendo introduzidos mais rapidamente do que as proteções necessárias podem ser implementadas e;

- há falta de oportunidade para os afetados tomarem decisões democráticas sobre se devem ser usados e, em caso afirmativo, como devem ser usados.

Nosso mais recente projeto de pesquisa,

Automatizando serviços públicos:aprendendo com sistemas cancelados , fornece descobertas destinadas a ajudar a prevenir danos e contribuir para um debate e ação significativos. O relatório fornece a primeira visão abrangente dos sistemas sendo cancelados nas democracias ocidentais.

Pesquisar os fatores e as razões que levam ao cancelamento de sistemas ADS nos ajuda a entender melhor seus limites. Em nosso relatório, identificamos 61 ADS que foram cancelados na Austrália, Canadá, Europa, Nova Zelândia e EUA. Apresentamos um relato detalhado dos sistemas cancelados nas áreas de detecção de fraude, bem-estar infantil e policiamento. Nossas descobertas demonstram a importância de uma consideração cuidadosa e preocupação com a equidade.

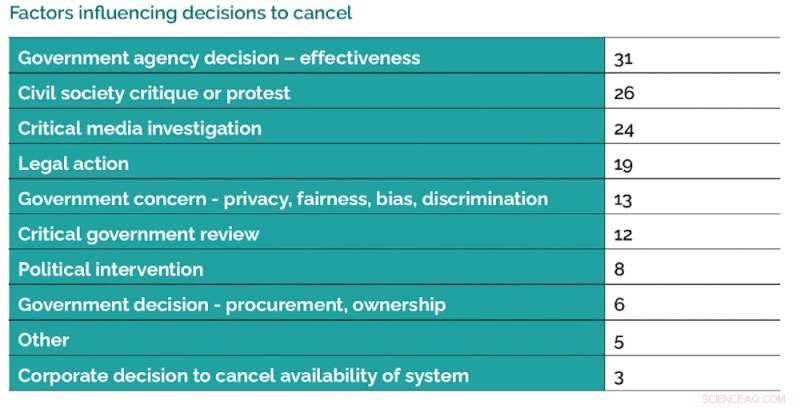

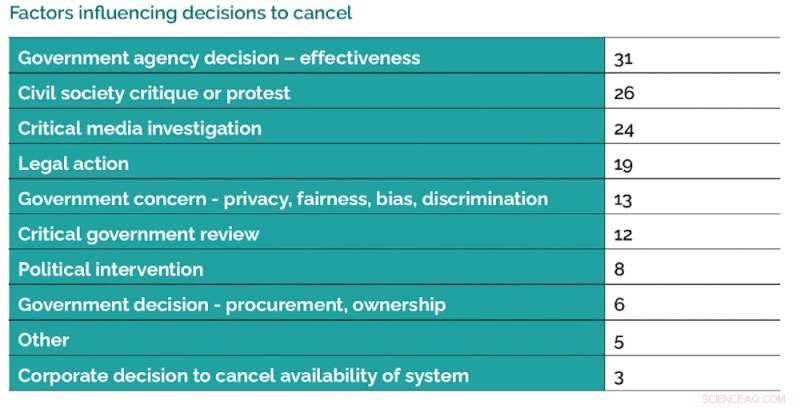

Há uma série de fatores que influenciam as decisões de cancelar os usos dos sistemas ADS. Crédito:Data Justice Lab, Autor fornecido

Motivos do cancelamento Há uma série de fatores que influenciam as decisões de cancelar os usos de ADS. Uma de nossas descobertas mais importantes é a frequência com que os sistemas são cancelados porque não são tão eficazes quanto o esperado. Outra descoberta importante é o papel significativo desempenhado pela mobilização e pesquisa comunitária, reportagem investigativa e ação legal.

Nossas descobertas demonstram que existem entendimentos, visões e políticas concorrentes em torno do uso de ADS.

Esperamos que nossas recomendações levem a uma maior participação cívica e melhor supervisão, responsabilização e prevenção de danos.

No relatório, destacamos os apelos generalizados para que os governos estabeleçam registros de ADS com recursos como um primeiro passo básico para uma maior transparência. Alguns países, como o Reino Unido, declararam planos para fazê-lo, enquanto outros países como o Canadá ainda precisam avançar nessa direção.

Nossos achados demonstram que o uso de ADS pode levar a uma maior desigualdade e injustiça sistêmica. Isso reforça a necessidade de estar atento a como o uso de ADS pode criar sistemas diferenciais de vantagem e desvantagem.

Responsabilidade e transparência ADS precisa ser desenvolvido com cuidado e responsabilidade, envolvendo significativamente as comunidades afetadas. Pode haver consequências prejudiciais quando as agências governamentais não envolvem o público em discussões sobre o uso apropriado de ADS antes da implementação.

Esse envolvimento deve incluir a opção de os membros da comunidade decidirem as áreas em que não desejam que o ADS seja usado. Exemplos de boas práticas governamentais podem incluir reservar um tempo para garantir que análises de especialistas independentes e avaliações de impacto com foco na igualdade e nos direitos humanos sejam realizadas.

Os governos podem adotar várias abordagens diferentes para implementar sistemas ADS de maneira mais responsável. Crédito:Data Justice Lab, Autor fornecido

Recomendamos fortalecer a responsabilidade daqueles que desejam implementar o ADS, exigindo comprovação de precisão, eficácia e segurança, bem como análises de legalidade. No mínimo, as pessoas devem ser capazes de descobrir se um ADS usou seus dados e, se necessário, ter acesso a recursos para contestar e corrigir avaliações erradas.

Há uma série de casos listados em nosso relatório em que a parceria de agências governamentais com empresas privadas para fornecer serviços de ADS apresentou problemas. Em um caso, uma agência do governo decidiu não usar um sistema de fiança porque a natureza proprietária do sistema significava que réus e funcionários não seriam capazes de entender por que uma decisão foi tomada, tornando impossível uma contestação efetiva.

As agências governamentais precisam ter os recursos e habilidades para examinar minuciosamente como adquirem os sistemas ADS.

Uma política de cuidado Todas essas recomendações apontam para a importância de uma política de cuidado. Isso exige que aqueles que desejam implementar ADS apreciem as complexidades das pessoas, comunidades e seus direitos.

Perguntas-chave precisam ser feitas sobre como os usos de ADS levam a pontos cegos devido à maneira como aumentam o distanciamento entre os administradores e as pessoas que devem servir por meio de sistemas de pontuação e classificação que simplificam demais, inferem culpa, segmentam erroneamente e estereotipam as pessoas por meio de categorizações e quantificações.

A boa prática, em termos de política de cuidado, envolve dedicar tempo para considerar cuidadosamente os possíveis impactos da ADS antes da implementação e responder às críticas, garantir supervisão e revisão contínuas e buscar uma revisão independente e da comunidade.

+ Explorar mais Reconhecimento facial, câmeras e outras ferramentas usadas pela polícia levantam questões sobre responsabilidade

Este artigo é republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.