Crédito:Marat Marihal / Shutterstock

Desde que as empresas começaram a desenvolver carros autônomos, as pessoas perguntam como os designers abordarão a questão moral de quem um carro autônomo deve matar se um acidente fatal for inevitável. Pesquisas recentes sugerem que essa pergunta pode ser ainda mais difícil para os fabricantes de automóveis responderem do que se pensava, porque as preferências morais das pessoas variam muito entre os países.

Os pesquisadores, baseado na Harvard University e MIT, desenvolveu um jogo online simulando situações em que um acidente de carro fatal era inevitável. Eles pediram a cerca de 40 milhões de pessoas de mais de 200 países para escolher entre vários resultados de acidentes, como matar pedestres em vez de passageiros do carro.

Os resultados revelaram três grupos culturais onde havia diferenças significativas nas preferências éticas que as pessoas tinham. Por exemplo, no cluster do Sul (que incluiu a maior parte da América Latina e algumas ex-colônias francesas), havia uma forte preferência por poupar as mulheres aos homens. O cluster oriental (que incluía muitos países islâmicos, bem como a China, Japão e Coréia) tiveram uma preferência menor por poupar pessoas mais jovens do que pessoas mais velhas.

Os pesquisadores concluíram dizendo que essa informação deve influenciar os desenvolvedores de carros autônomos. Mas é realmente esse o caso? Embora este artigo destaque uma descoberta interessante sobre as variações globais nas preferências morais, também destaca um mal-entendido persistente sobre IA, e o que pode realmente fazer. Dada a atual tecnologia de IA usada em carros autônomos, a ideia de que um veículo poderia tomar uma decisão moral é realmente impossível.

A fantasia da 'máquina moral'

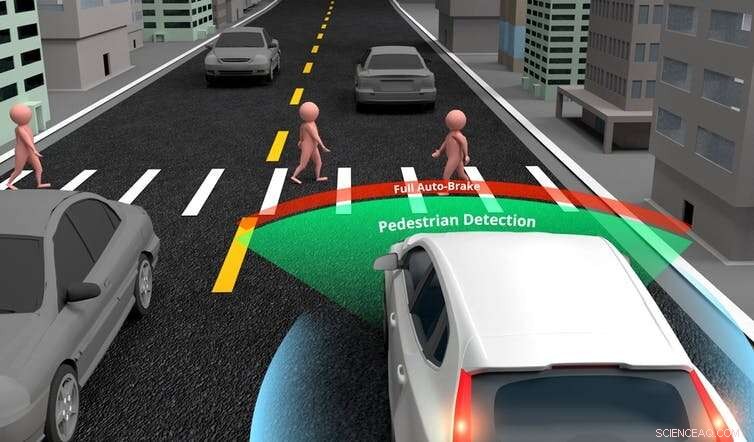

Os carros autônomos são treinados para tomar decisões sobre onde dirigir ou quando frear, usando IA específica (ou fraca) (inteligência artificial que se concentra em completar uma tarefa limitada). Eles são projetados com uma variedade de sensores, câmeras e lasers de medição de distância (lidar), que fornecem informações a um computador central. O computador então usa a IA para analisar essas entradas e tomar uma decisão.

Embora a tecnologia atualmente seja relativamente simples, os carros acabarão superando os humanos nessas tarefas básicas de direção. Contudo, não é realista pensar que os carros que dirigem sozinhos também devam ser capazes de tomar uma decisão ética que mesmo o mais moral dos seres humanos não teria tempo de tomar em um cenário de acidente. Um carro precisaria ser programado com IA geral se fosse esperado que fizesse isso.

A IA específica permite que os carros autônomos façam julgamentos básicos sobre os objetos ao seu redor. Crédito:Akarat Phasura / Shutterstock

A IA geral é o equivalente ao que nos torna humanos. É a capacidade de conversar, Aproveite a música, achar as coisas engraçadas ou fazer julgamentos morais. Produzir IA geral é atualmente impossível devido à complexidade do pensamento e das emoções humanas. Se exigirmos veículos autônomos morais, não chegaremos lá por várias décadas, se alguma vez.

Outro problema com a nova pesquisa foi que muitas das situações que os participantes foram solicitados a julgar eram irrealistas. Em um cenário que ecoa o famoso "problema do bonde", participantes foram questionados sobre quem o carro deveria matar se seus freios falhassem:seus três passageiros (um homem adulto, uma mulher adulta e um menino) ou três pedestres idosos (dois homens e uma mulher).

As pessoas podem considerar cuidadosamente esses tipos de problemas ao responder a um questionário. Mas na maioria dos acidentes da vida real, um motorista não teria tempo para fazer tais julgamentos na fração de segundo antes de acontecer. Isso significa que a comparação é inválida. E dada a atual tecnologia de IA de carros autônomos, esses veículos também não serão capazes de fazer esses julgamentos.

Os carros autônomos atuais têm habilidades de detecção sofisticadas e podem distinguir os pedestres de outros objetos, como postes de luz ou sinais de trânsito. Contudo, os autores da pesquisa sugerem que os carros autônomos podem, será e talvez deva ser capaz de fazer distinções mais avançadas. Por exemplo, eles poderiam reconhecer pessoas consideradas mais desejáveis para a sociedade, como médicos ou atletas, e escolha salvá-los em um cenário de falha.

A realidade é que projetar carros para fazer julgamentos tão avançados envolveria a produção de IA geral, o que atualmente é impossível. Há também a questão de saber se isso é mesmo desejável. Se for possível programar um carro para decidir qual vida deve ser salva, não é algo que eu deva permitir. Não devemos permitir as preferências identificadas na pesquisa, por maior que seja o tamanho da amostra, para determinar o valor de uma vida.

Em sua forma mais básica, carros autônomos estão sendo projetados para evitar acidentes, se possível, e minimizar a velocidade do impacto se não puderem. Embora, como humanos, eles não são capazes de tomar uma decisão moral antes de um acidente inevitável. Mas os carros autônomos serão mais seguros do que os motoristas humanos, como eles estão mais atentos, pode reagir mais rápido e usará ao máximo os recursos do sistema de frenagem em um cenário de acidente.

Atualmente, o maior desafio ético que os projetistas de carros autônomos enfrentam é determinar quando há evidências suficientes de comportamento seguro a partir de simulações e testes controlados na estrada para introduzir os carros autônomos na estrada. Mas isso não significa que eles sejam "morais", ou será em breve. Dizer isso é confundir a IA específica de fazer tarefas de direção com a IA geral, que provavelmente não existirá em nossa vida.

Em última análise, carros autônomos serão mais seguros do que humanos. Eles vão conseguir isso por meio do design e evitando acidentes sempre que possível, e reduzindo os danos onde não. Contudo, os carros não serão capazes de tomar decisões morais que mesmo nós não poderíamos. Essa noção continua sendo uma fantasia rebuscada, e não devemos ter esperança. Em vez de, vamos nos concentrar na segurança:algo em que poderemos ter confiança justificada.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.