É mais provável que o YouTube recomende vídeos de fraude eleitoral para usuários já céticos sobre a legitimidade das eleições de 2020

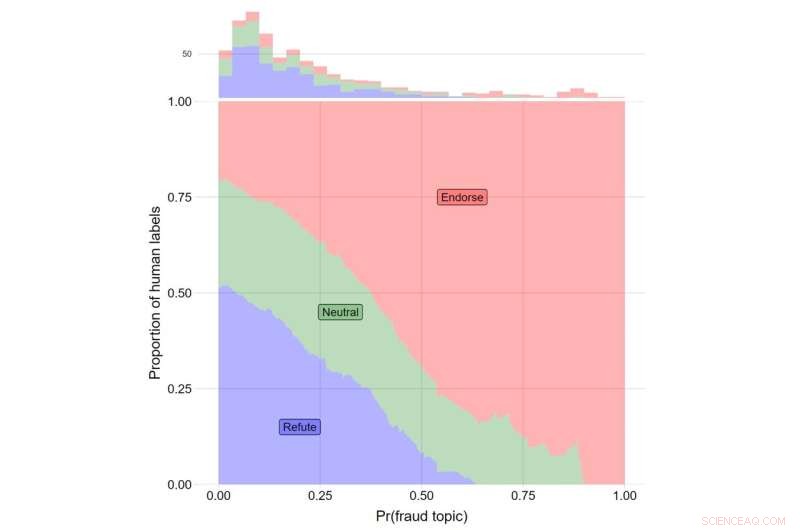

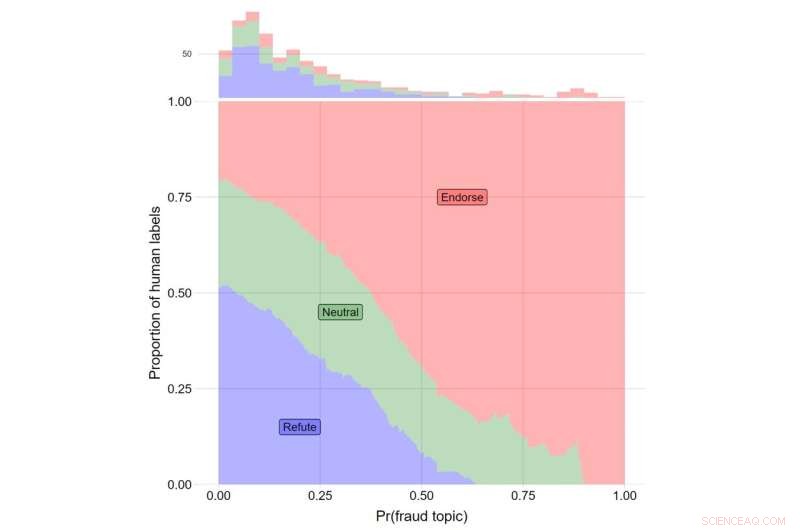

O eixo y indica a parcela de rótulos humanos para vídeos que refutam as afirmações de Trump (em azul), aqueles que relatam as afirmações de Trump de forma neutra (verde) e aqueles que endossam as afirmações de Trump (vermelho). O eixo x indica o valor θ para o tópico #108. O número total de vídeos que se enquadram em cada categoria é indicado com o histograma na parte superior do gráfico. Crédito:Jornal de Confiança e Segurança Online (2022). https://doi.org/10.54501/jots.v1i3.60

O YouTube era mais propenso a recomendar vídeos sobre fraude eleitoral para usuários que já estavam céticos sobre a legitimidade das eleições presidenciais de 2020 nos EUA, mostra um novo estudo que examina o impacto dos algoritmos do site.

Os resultados da pesquisa, publicados no

Journal of Online Trust and Safety , mostrou que os mais céticos em relação à legitimidade da eleição foram exibidos três vezes mais vídeos relacionados a fraude eleitoral do que os participantes menos céticos – aproximadamente 8 recomendações adicionais de aproximadamente 400 vídeos sugeridos para cada participante do estudo.

Embora a prevalência geral desses tipos de vídeos tenha sido baixa, as descobertas expõem as consequências de um sistema de recomendação que fornece aos usuários o conteúdo que eles desejam. Para aqueles mais preocupados com possíveis fraudes eleitorais, mostrar conteúdo relacionado forneceu um mecanismo pelo qual desinformação, desinformação e conspirações podem chegar aos mais propensos a acreditar neles, observam os autores do estudo. É importante ressaltar que esses padrões refletem a influência independente do algoritmo sobre o que os usuários reais são mostrados ao usar a plataforma.

“Nossas descobertas revelam as consequências prejudiciais dos algoritmos de recomendação e lançam dúvidas sobre a visão de que os ambientes de informação online são determinados exclusivamente pela escolha do usuário”, diz James Bisbee, que liderou o estudo como pesquisador de pós-doutorado no Centro de Mídias Sociais e Política da Universidade de Nova York. (CSMaP).

Quase dois anos após a eleição presidencial de 2020, um grande número de americanos, principalmente republicanos, não acredita na legitimidade do resultado.

“Aproximadamente 70% dos republicanos não veem Biden como o vencedor legítimo”, apesar de “múltiplas recontagens e auditorias que confirmaram a vitória de Joe Biden”, escreveu o PolitiFact do Instituto Poynter no início deste ano.

Embora seja sabido que as plataformas de mídia social, como o YouTube, direcionam o conteúdo aos usuários com base em suas preferências de pesquisa, as consequências dessa dinâmica podem não ser totalmente percebidas.

No estudo do CSMaP, os pesquisadores amostraram mais de 300 americanos com contas do YouTube em novembro e dezembro de 2020. Os participantes foram questionados sobre o quanto estavam preocupados com vários aspectos da fraude eleitoral, incluindo cédulas fraudulentas sendo contadas, cédulas válidas sendo descartadas, governos estrangeiros interferindo e cidadãos não americanos votando, entre outras questões.

Esses participantes foram solicitados a instalar uma extensão do navegador que registraria a lista de recomendações que lhes foram mostradas. Os sujeitos foram então instruídos a clicar em um vídeo do YouTube atribuído aleatoriamente (o vídeo "seed") e, em seguida, clicar em uma das recomendações que foram mostradas de acordo com uma "regra de travessia" atribuída aleatoriamente. Por exemplo, os usuários atribuídos à "segunda regra de travessia" seriam obrigados a sempre clicar no segundo vídeo da lista de recomendações exibida, independentemente de seu conteúdo. Ao restringir o comportamento do usuário dessa maneira, os pesquisadores conseguiram isolar a influência do algoritmo de recomendação sobre quais usuários reais estavam sendo sugeridos em tempo real.

Os sujeitos então seguiram por uma sequência de vídeos recomendados pelo YouTube, permitindo que os pesquisadores observassem o que o algoritmo do YouTube sugeria a seus usuários. Bisbee and his colleagues then compared the number of videos about election fraud in the 2020 U.S. presidential election that were recommended to participants who were more skeptical about the legitimacy of the election to those recommended to participants who were less skeptical. These results showed that election skeptics were recommended an average of eight additional videos about possible fraud in the 2020 US election, relative to non-skeptical participants (12 vs. 4).

"Many believe that automated recommendation algorithms have little influence on online 'echo chambers' in which users only see content that reaffirms their preexisting views," observes Bisbee, now an assistant professor at Vanderbilt University.

"Our study, however, suggests that YouTube's recommendation algorithm was able to determine which users were more likely to be concerned about fraud in the 2020 U.S. presidential election and then suggested up to three times as many videos about election fraud to these users compared to those less concerned about election fraud. This highlights the need for further investigation into how opaque recommendation algorithms operate on an issue-by-issue basis."

+ Explorar mais YouTube to remove misleading videos about the outcome of the U.S. presidential election