Os pesquisadores criam o maior, simulação multifísica de terremoto mais longa até hoje

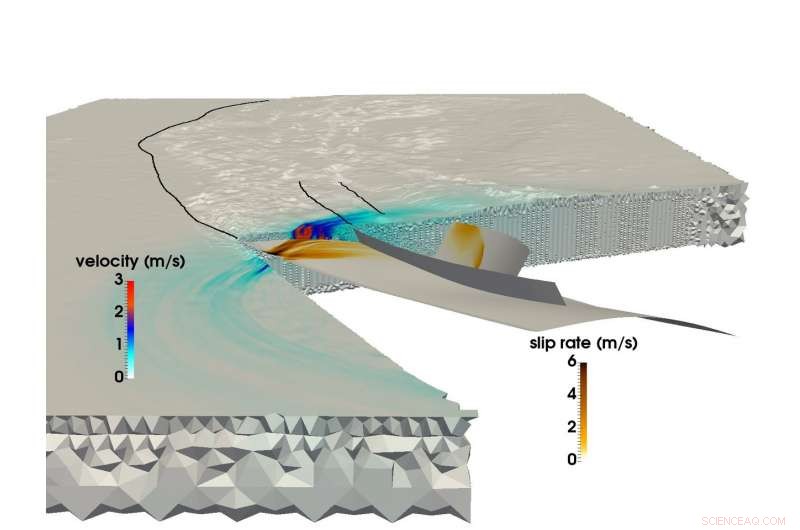

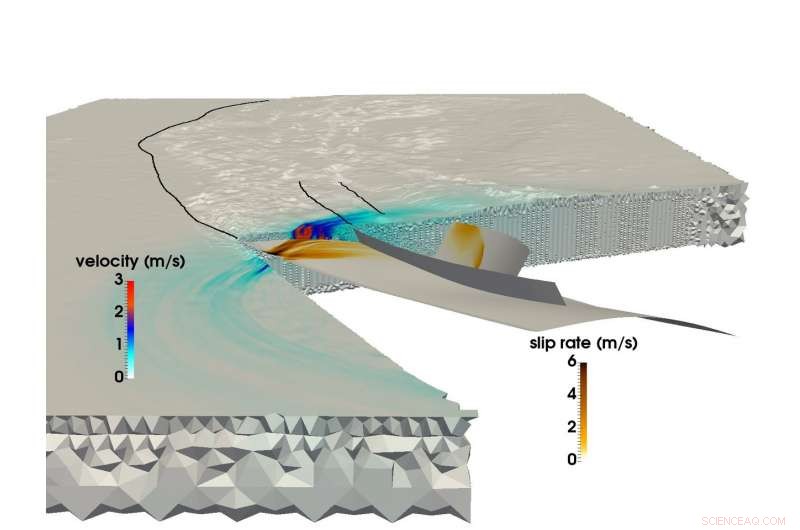

p Usando o supercomputador SuperMUC da LRZ, uma equipe de pesquisa conjunta da Universidade Técnica de Munique e da Ludwigs-Maximilians-Uni Munich foi capaz de criar a maior simulação multifísica de um terremoto e tsunami. Esta imagem mostra a propagação da ruptura e o campo de ondas sísmicas resultante durante o terremoto Sumatra-Andaman de 2004. Crédito:C. Uphoff, S.Rettenberger, M. Bader, Universidade Técnica de Munique. E. Madden, T. Ulrich, S. Wollherr, A. Gabriel, Ludwigs-Maximilians-Universität.

p Usando o supercomputador SuperMUC da LRZ, uma equipe de pesquisa conjunta da Universidade Técnica de Munique e da Ludwigs-Maximilians-Uni Munich foi capaz de criar a maior simulação multifísica de um terremoto e tsunami. Esta imagem mostra a propagação da ruptura e o campo de ondas sísmicas resultante durante o terremoto Sumatra-Andaman de 2004. Crédito:C. Uphoff, S.Rettenberger, M. Bader, Universidade Técnica de Munique. E. Madden, T. Ulrich, S. Wollherr, A. Gabriel, Ludwigs-Maximilians-Universität.

p Pouco antes das 8h00 hora local de 26 de dezembro, 2004, pessoas no sudeste da Ásia estavam começando seus dias quando o terceiro terremoto mais forte registrado na história atingiu um 1, Rasgo de 500 quilômetros no fundo do oceano na costa da ilha indonésia de Sumatra. p O terremoto durou entre 8 e 10 minutos (um dos mais longos já registrados), e elevou o fundo do oceano vários metros, criando um tsunami com ondas de 30 metros que devastou comunidades inteiras. O evento causou quase 200, 000 mortes em 15 países, e liberou tanta energia acima e abaixo do solo quanto vários séculos de uso de energia nos Estados Unidos.

p O Terremoto Sumatra-Andaman, como é chamado, foi tão surpreendente quanto violento. Apesar dos grandes avanços no monitoramento de terremotos e sistemas de alerta nos últimos 50 anos, os cientistas da Terra foram incapazes de predizê-lo porque existem relativamente poucos dados sobre esses eventos sismológicos de grande escala. Os pesquisadores têm uma grande quantidade de informações relacionadas ao semirregular, terremotos de intensidade baixa a média, mas desastres como o Sumatra-Andaman - eventos que acontecem apenas a cada duas centenas de anos - são raros demais para criar conjuntos de dados confiáveis.

p Para entender melhor esses eventos, e, com sorte, fornecer melhores métodos de previsão e mitigação, uma equipe de pesquisadores da Ludwig-Maximilians-Universität Munich (LMU) e da Technical University of Munich (TUM) está usando recursos de supercomputação no Leibniz Supercomputing Center (LRZ) para entender melhor esses raros, fenômenos sísmicos extremamente perigosos.

p "Nossa motivação geral é entender melhor todo o processo de porque alguns terremotos e tsunamis resultantes são muito maiores do que outros, "disse o professor da TUM, Dr. Michael Bader." Às vezes, vemos tsunamis relativamente pequenos quando os terremotos são grandes, ou tsunamis surpreendentemente grandes ligados a terremotos relativamente pequenos. A simulação é uma das ferramentas para obter uma visão desses eventos. "

p A equipe se empenha em simulações "acopladas" de terremotos e tsunamis subsequentes. Recentemente, concluiu sua maior simulação de terremoto até então. Usando o supercomputador SuperMUC em LRZ, a equipe foi capaz de simular 1, 500 quilômetros de mecânica de fratura não linear - a fonte do terremoto - acoplada a ondas sísmicas que viajaram até a Índia e a Tailândia ao longo de pouco mais de 8 minutos do terremoto Sumatra-Andaman. Por meio de várias inovações computacionais internas, a equipe obteve uma melhoria de 13 vezes no tempo para solução. Em reconhecimento a esta conquista, o projeto foi indicado para o prêmio de melhor artigo na SC17, uma das principais conferências de supercomputação do mundo, realizada este ano de 12 a 17 de novembro em Denver, Colorado.

p

Terremotos megathrust, simulações em grande escala

p Terremotos acontecem quando a rocha abaixo da superfície da Terra se quebra repentinamente, frequentemente como resultado do movimento lento das placas tectônicas.

p Um indicador aproximado da capacidade de um terremoto oceânico de desencadear um grande tsunami é se as placas estão se chocando umas contra as outras ou colidindo de frente. Se duas ou mais placas colidirem, uma placa freqüentemente forçará a outra abaixo dela. As regiões onde esse processo ocorre são chamadas de zonas de subducção e podem hospedar muito grandes, falhas de mergulho superficial - chamadas de "megatrostas". A liberação de energia através dessas enormes zonas de fraqueza tende a criar tsunamis violentos, conforme o fundo do oceano sobe uma quantidade significativa, deslocando temporariamente grandes quantidades de água.

p Até recentemente, no entanto, os pesquisadores que faziam geofísica computacional tiveram grandes dificuldades em simular terremotos de subducção no nível necessário de detalhe e precisão. Simulações de terremotos em grande escala são geralmente difíceis, mas os eventos de subducção são ainda mais complexos.

p "Modelar terremotos é um problema multiescala no espaço e no tempo, "disse a Dra. Alice Gabriel, o pesquisador principal do lado LMU da equipe. "A realidade é complexa, o que significa que incorporar a complexidade observada de fontes de terremotos invariavelmente envolve o uso de métodos numéricos, software de simulação altamente eficiente, e, claro, computação de alto desempenho (HPC). Somente explorando o HPC podemos criar modelos que podem resolver a liberação dinâmica de tensões e rupturas que acontecem com um terremoto, ao mesmo tempo em que simula o deslocamento do fundo do mar ao longo de milhares de quilômetros. "

p Quando os pesquisadores simulam um terremoto, eles usam uma grade computacional para dividir a simulação em muitos pedaços pequenos. Eles então calculam equações específicas para vários aspectos da simulação, como agitação sísmica gerada ou deslocamento do fundo do oceano, entre outros, ao longo de "etapas do tempo, "ou instantâneos de simulação ao longo do tempo que ajudam a colocá-lo em movimento, muito parecido com um flip book.

p Quanto melhor a grade, quanto mais precisa a simulação, mas quanto mais exigente computacionalmente ele se torna. Além disso, quanto mais complexa for a geometria do terremoto, quanto mais complexa a grade se torna, complicando ainda mais o cálculo. Para simular terremotos de subducção, os cientistas da computação precisam criar uma grande grade que também possa representar com precisão os ângulos muito rasos em que as duas placas continentais se encontram. Isso requer que as células da grade ao redor da área de subducção sejam extremamente pequenas, e muitas vezes de forma esguia.

p Ao contrário dos terremotos continentais, que foram melhor documentados por meio de computação e observação, eventos de subducção muitas vezes acontecem nas profundezas do oceano, o que significa que é muito mais difícil restringir uma simulação por observações detalhadas e oscilantes do solo, dados confiáveis de observação direta e experimentos de laboratório.

p Além disso, computar um acoplado, a simulação de terremoto-tsunami em grande escala requer o uso de dados de uma ampla variedade de fontes. Os pesquisadores devem levar em consideração a forma do fundo do mar, a forma e a força do limite da placa rompido pelo terremoto e o comportamento material da crosta terrestre em cada nível, entre outros aspectos. A equipe passou os últimos anos desenvolvendo métodos para integrar com mais eficiência essas fontes de dados díspares em um modelo consistente.

p Para reduzir o enorme tempo de computação, a equipe explorou um método chamado "revisão de horário local". Em áreas onde as simulações requerem muito mais detalhes espaciais, os pesquisadores também devem "desacelerar" a simulação realizando mais etapas de tempo nessas áreas. Outras seções que exigem menos detalhes podem executar muito maiores - e, portanto, muito menos etapas de tempo.

p Se a equipe tivesse que executar toda a simulação em um pequeno intervalo de tempo uniforme, teria exigido cerca de 3 milhões de iterações individuais. Contudo, apenas algumas células da grade computacional exigiam esse tamanho de intervalo de tempo. As partes principais podem ser calculadas com intervalos de tempo muito maiores, alguns requerem apenas 3.000 passos de tempo. Isso reduziu a demanda computacional significativamente e levou a grande parte da aceleração de 13 vezes da equipe. Esse avanço também fez com que a simulação da equipe fosse a maior, mais longa simulação de primeiros princípios de um terremoto desse tipo.

p

Movimento para a frente

p Devido à sua estreita colaboração com a equipe LRZ, a equipe teve a oportunidade de usar toda a máquina SuperMUC para suas simulações. Bader indicou que essas execuções em escala extremamente grande são inestimáveis para a equipe obter insights mais profundos em sua pesquisa. "Há uma grande diferença se você rodar em um quarto da máquina ou em uma máquina completa, já que o último fator de 4 muitas vezes revela os gargalos críticos, " ele disse.

p A capacidade da equipe de aproveitar ao máximo os recursos de supercomputação da geração atual a deixa entusiasmada com o futuro. Não é necessariamente importante que as máquinas da próxima geração ofereçam a oportunidade para os pesquisadores do LMU-TUM executarem simulações "maiores" - as simulações atuais podem simular com eficácia uma área geográfica grande o suficiente. Em vez, a equipe está entusiasmada com a oportunidade de modificar os dados de entrada e executar muito mais iterações durante um determinado período de tempo de computação.

p "Temos feito uma simulação individual, tentando adivinhar com precisão a configuração inicial, como as tensões e forças iniciais, mas tudo isso ainda é incerto, "Bader disse." Então, gostaríamos de executar nossa simulação com muitas configurações diferentes para ver como pequenas mudanças no sistema de falhas ou outros fatores afetariam o estudo. Estes seriam estudos de parâmetros maiores, que é outra camada de desempenho que um computador precisa fornecer. "

p Gabriel também mencionou que as máquinas da próxima geração serão capazes de simular urgentes, cenários em tempo real que podem ajudar a prever os perigos relacionados a prováveis regiões de tremores secundários. A equipe está animada para ver as arquiteturas de próxima geração no LRZ e nos outros centros do Gauss Center for Supercomputing, o High-Performance Computing Center Stuttgart e o Jülich Supercomputing Center.

p Na opinião de Bader, o trabalho recente da equipe não apenas representa sua simulação em maior escala até o momento, mas também a colaboração cada vez mais forte entre os cientistas de domínio e cientistas computacionais do grupo. "Este artigo tem um forte componente de sismologia e um forte componente de HPC, "disse ele." Este é realmente um artigo 50-50 para nós. Nossa colaboração está indo bem, e é porque não se trata de obter o nosso ou o deles. Ambos os grupos lucram, e este é um trabalho conjunto muito bom. "