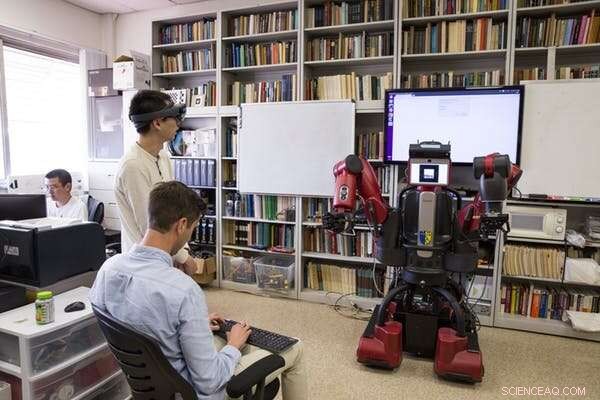

Um robô e um humano interagindo. Crédito:Tommy Ton, tontommy.com, CC BY-ND

A inteligência artificial está entrando em nossas vidas de muitas maneiras - em nossos smartphones, em nossas casas, em nossos carros. Esses sistemas podem ajudar as pessoas a fazerem compromissos, conduzir e até diagnosticar doenças. Mas, como os sistemas de IA continuam a cumprir papéis importantes e colaborativos na vida das pessoas, uma pergunta natural é:posso confiar neles? Como posso saber se eles farão o que espero?

Explainable AI (XAI) é um ramo da pesquisa de IA que examina como os agentes artificiais podem se tornar mais transparentes e confiáveis para seus usuários humanos. A confiabilidade é essencial para que robôs e pessoas trabalhem juntos. O XAI busca desenvolver sistemas de IA que os seres humanos considerem confiáveis - ao mesmo tempo que tem um bom desempenho para cumprir as tarefas projetadas.

No Center for Vision, Conhecimento, Aprendendo, e Autonomia na UCLA, nós e nossos colegas estamos interessados em quais fatores tornam as máquinas mais confiáveis, e quão bem diferentes algoritmos de aprendizagem permitem a confiança. Nosso laboratório usa um tipo de representação de conhecimento - um modelo do mundo que uma IA usa para interpretar seus arredores e tomar decisões - que pode ser mais facilmente compreendido por humanos. Isso naturalmente ajuda na explicação e na transparência, melhorando assim a confiança dos usuários humanos.

Em nossa última pesquisa, experimentamos diferentes maneiras de um robô explicar suas ações a um observador humano. Interessantemente, as formas de explicação que fomentavam a confiança mais humana não correspondiam aos algoritmos de aprendizagem que produziam o melhor desempenho nas tarefas. Isso sugere que o desempenho e a explicação não são inerentemente dependentes um do outro - otimizar apenas para um pode não levar ao melhor resultado para o outro. Essa divergência exige designs de robôs que levem em consideração tanto o bom desempenho da tarefa quanto explicações confiáveis.

Robôs de ensino

Ao realizar este estudo, nosso grupo estava interessado em duas coisas. Qual é a melhor maneira de um robô aprender a executar uma tarefa específica? Então, como as pessoas respondem à explicação do robô sobre suas ações?

Ensinamos um robô a aprender por meio de demonstrações humanas como abrir um frasco de remédio com uma trava de segurança. Uma pessoa usava uma luva tátil que registrava as poses e forças da mão humana ao abrir a garrafa. Essa informação ajudou o robô a aprender o que o humano fazia de duas maneiras:simbólica e tátil. Simbólico se refere a representações significativas de suas ações:por exemplo, a palavra "agarrar". Háptica refere-se aos sentimentos associados às posturas e movimentos do seu corpo:por exemplo, a sensação de seus dedos se fechando.

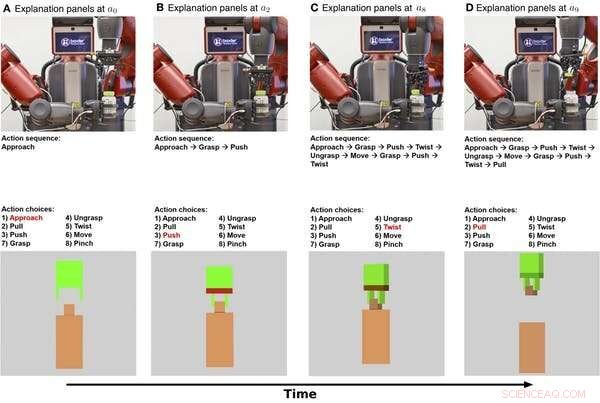

Explicações simbólicas e táteis de um robô abrindo um frasco de remédio mostradas ao longo do tempo. A linha superior é a imagem de um vídeo do robô realizando a tarefa. A linha do meio mostra uma explicação simbólica da tarefa. A linha inferior mostra uma explicação tátil. Crédito:Edmonds et al., Sci. Robô. 4, eaay4663 (2019)

Primeiro, o robô aprendeu um modelo simbólico que codifica a sequência de etapas necessárias para completar a tarefa de abrir a garrafa. Segundo, o robô aprendeu um modelo háptico que permite ao robô "imaginar" a si mesmo no papel de um demonstrador humano e prever que ação uma pessoa tomaria ao encontrar forças e poses específicas.

Acontece que o robô foi capaz de atingir seu melhor desempenho ao combinar os componentes simbólicos e táteis. O robô se saiu melhor usando o conhecimento das etapas para realizar a tarefa e a detecção em tempo real de sua garra do que usando qualquer um deles sozinho.

Ganhando confiança humana

Agora que o robô sabe o que fazer, como pode explicar seu comportamento a uma pessoa? E até que ponto essa explicação promove a confiança humana?

Para explicar suas ações, o robô pode se basear em seu processo de decisão interno, bem como em seu comportamento. O modelo simbólico fornece descrições passo a passo das ações do robô, e o modelo háptico fornece uma noção do que o agarrador do robô está "sentindo".

Em nosso experimento, adicionamos uma explicação adicional para humanos:um texto escrito que forneceu um resumo depois que o robô terminou de tentar abrir o frasco de remédio. Queríamos ver se as descrições resumidas seriam tão eficazes quanto a explicação simbólica passo a passo para ganhar a confiança humana.

Pedimos a 150 participantes humanos, dividido em quatro grupos, observar o robô tentando abrir o frasco do remédio. O robô deu a cada grupo uma explicação diferente da tarefa:simbólica, passo a passo, háptica - posições e movimentos dos braços, resumo do texto, ou simbólico e háptico juntos. Um grupo de linha de base observou apenas um vídeo do robô tentando abrir a garrafa, sem fornecer quaisquer explicações adicionais.

Descobrimos que fornecer as explicações simbólicas e táteis gerou mais confiança, com o componente simbólico contribuindo mais. Interessantemente, a explicação na forma de um resumo de texto não gerou mais confiança do que simplesmente observar o robô realizar a tarefa, indicando que os humanos preferem robôs para dar explicações passo a passo do que estão fazendo.

Pesquisadores da UCLA testam um robô depois que ele aprendeu a abrir um frasco de remédio observando manifestantes humanos. Crédito:UCLA Samueli School of Engineering, CC BY-ND

Projetando para desempenho e confiança

O resultado mais interessante dessa pesquisa é que o que faz os robôs funcionarem bem não é o mesmo que faz as pessoas considerá-los confiáveis. O robô precisava dos componentes simbólicos e táteis para fazer o melhor trabalho. Mas foi a explicação simbólica que mais fez as pessoas confiarem no robô.

Essa divergência destaca objetivos importantes para pesquisas futuras em IA e robótica:focar na busca pelo desempenho da tarefa e pela explicabilidade. Focar apenas no desempenho da tarefa pode não levar a um robô que se explica bem. Nosso laboratório usa um modelo híbrido para fornecer explicações de alto desempenho e confiáveis.

Desempenho e explicação não se complementam naturalmente, então, ambos os objetivos precisam ser uma prioridade desde o início ao construir sistemas de IA. Este trabalho representa um passo importante no estudo sistemático de como as relações homem-máquina se desenvolvem, Mas muito mais precisa ser feito. Um passo desafiador para pesquisas futuras será mudar de "Eu confio no robô para fazer X" para "Eu confio no robô".

Para que os robôs ganhem um lugar na vida diária das pessoas, os humanos precisam confiar em suas contrapartes robóticas. Compreender como os robôs podem fornecer explicações que promovam a confiança humana é um passo importante para permitir que humanos e robôs trabalhem juntos.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.