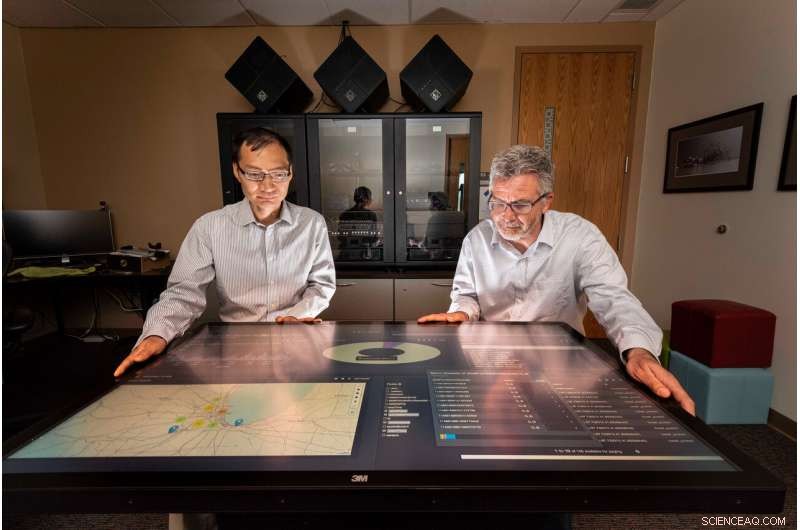

Sandia National Laboratories, os cientistas da computação Tian Ma, deixou, e Rudy Garcia, liderou um projeto para fornecer informações acionáveis a partir de dados de streaming quase em tempo real. Crédito:Randy Montoya

Mídia social, máquinas fotográficas, sensores e muito mais geram grandes quantidades de dados que podem sobrecarregar os analistas que procuram algo significativo, informações acionáveis para fornecer aos tomadores de decisão, como líderes políticos e comandantes de campo, respostas às ameaças à segurança.

Os pesquisadores do Sandia National Laboratories estão trabalhando para diminuir esse fardo, desenvolvendo a ciência para reunir insights de dados quase em tempo real.

"A quantidade de dados produzidos por sensores e mídias sociais está crescendo - todos os dias há cerca de 2,5 quintilhões (ou 2,5 bilhões de bilhões) de bytes de dados gerados, "disse Tian Ma, um cientista da computação Sandia e co-líder do projeto. "Cerca de 90% de todos os dados foram gerados nos últimos dois anos - há mais dados do que pessoas para analisar. As comunidades de inteligência estão basicamente sobrecarregadas, e o problema é que você acaba com uma grande quantidade de dados em discos que podem ser esquecidos. "

Os pesquisadores Sandia trabalharam com alunos da Universidade de Illinois Urbana-Champaign, um parceiro da Academic Alliance, para desenvolver algoritmos analíticos e de tomada de decisão para fontes de dados de streaming e integrá-los em uma estrutura de processamento de dados distribuídos quase em tempo real usando ferramentas de big data e recursos de computação no Sandia. A estrutura obtém dados díspares de várias fontes e gera informações úteis que podem ser acionadas quase em tempo real.

Para testar a estrutura, os pesquisadores e os alunos usaram dados de tráfego de Chicago, como imagens, sensores integrados, tweets e streaming de texto para medir com sucesso o congestionamento de tráfego e sugerir rotas de direção mais rápidas para um viajante de Chicago. A equipe de pesquisa selecionou o exemplo de tráfego de Chicago porque os dados introduzidos têm características semelhantes aos dados normalmente observados para fins de segurança nacional, disse Rudy Garcia, um cientista da computação Sandia e co-líder do projeto.

Afogando-se em dados

"Criamos dados sem nem mesmo pensar nisso, "disse Laura Patrizi, um cientista da computação Sandia e membro da equipe de pesquisa, durante uma palestra no Simpósio GEOINT 2019 da United States Geospatial Intelligence Foundation. "Quando andamos por aí com o telefone no bolso ou tuímos sobre o trânsito horrível, nosso telefone está rastreando nossa localização e pode anexar uma geolocalização ao nosso tweet. "

Para aproveitar essa avalanche de dados, analistas normalmente usam ferramentas de big data e algoritmos de aprendizado de máquina para encontrar e destacar informações significativas, mas o processo é executado em dados registrados, Ma disse.

"Queríamos ver o que pode ser analisado com dados em tempo real de várias fontes de dados, não o que pode ser aprendido com a mineração de dados históricos, "Ma disse." Inteligência acionável é o próximo nível de análise de dados onde a análise é colocada em uso para a tomada de decisões quase em tempo real. O sucesso desta pesquisa terá um forte impacto em muitas aplicações críticas de segurança nacional. "

Construindo uma estrutura de processamento de dados

A equipe empilhou tecnologias distribuídas em uma série de pipelines de processamento de dados que ingerem, curar e indexar os dados. Os cientistas que discutiram os dados especificaram como os pipelines deveriam adquirir e limpar os dados.

"Cada tipo de dados que ingerimos tem seu próprio esquema e formato de dados, "Garcia disse." Para que os dados sejam úteis, ele deve ser curado primeiro para que possa ser facilmente descoberto para um evento. "

Hortonworks Data Platform, rodando nos computadores de Sandia, foi usado como a infraestrutura de software para o processamento de dados e pipelines analíticos. Dentro da Hortonworks, a equipe desenvolveu e integrou topologias Apache Storm para cada pipeline de dados. Os dados selecionados foram então armazenados no Apache Solr, um mecanismo de pesquisa empresarial e banco de dados. PyTorch e Lucidwork's Banana foram usados para detecção de objetos de veículos e visualização de dados.

Encontrar os dados certos

"Trazer grandes quantidades de dados é difícil, mas é ainda mais desafiador encontrar as informações que você realmente procura, "Disse Garcia." Por exemplo, durante o projeto, veríamos tweets que diziam algo como "O controle de tráfego aéreo nos manteve no solo durante a última hora em Midway." O tráfego está no tweet, mas não é relevante para o tráfego da autoestrada. "

Para determinar o nível de congestionamento de tráfego em uma rodovia de Chicago, idealmente, a ferramenta poderia usar uma variedade de tipos de dados, incluindo uma câmera de tráfego mostrando o fluxo em ambas as direções, tweets geolocalização sobre acidentes, sensores rodoviários medindo a velocidade média, imagens de satélite das áreas e sinais de trânsito, estimando os tempos de viagem atuais entre os marcos miliários, disse Forest Danford, um cientista da computação Sandia e membro da equipe de pesquisa.

"Contudo, também obtemos muitos dados ruins, como uma imagem de câmera da web difícil de ler, e é raro terminarmos com muitos tipos de dados diferentes que estão fortemente co-localizados no tempo e no espaço, "Danford disse." Precisávamos de um mecanismo para aprender sobre os mais de 90 milhões de eventos (relacionados ao tráfego de Chicago) que observamos ser capazes de tomar decisões com base em informações incompletas ou imperfeitas. "

A equipe adicionou um classificador de congestionamento de tráfego treinando sistemas de computador combinados modelados no cérebro humano em recursos extraídos de imagens e tweets rotulados, e outros eventos que corresponderam aos dados no tempo e no espaço. O classificador treinado foi capaz de gerar previsões sobre o congestionamento de tráfego com base em dados operacionais em qualquer ponto de tempo e local, Danford disse.

Os professores Minh Do e Ramavarapu Sreenivas e seus alunos na UIUC trabalharam no reconhecimento de imagens e objetos em tempo real com imagens de câmeras da web e desenvolveram processos robustos de planejamento de rotas com base em várias fontes de dados.

"O desenvolvimento de uma ciência convincente para a inteligência acionável exige que lutemos com a dinâmica baseada em informações, "Sreenivas disse." O Santo Graal aqui é resolver o problema de especificação. Precisamos saber o que queremos antes de construir algo que nos dê o que queremos. Isso é muito mais difícil do que parece, e este projeto é o primeiro passo para entender exatamente o que gostaríamos de ter. "

Seguindo em frente, a equipe Sandia está transferindo a arquitetura, análises e lições aprendidas em Chicago para outros projetos governamentais e continuará a investigar ferramentas analíticas, fazer melhorias no modelo de reconhecimento de objeto do Labs e trabalhar para gerar algo significativo, inteligência acionável.

"Estamos tentando tornar os dados detectáveis, acessível e utilizável, "Disse Garcia." E se pudermos fazer isso por meio dessas arquiteturas de big data, então acho que estamos ajudando. "