Um novo método para resolver uma série de problemas de otimização global desenvolvido

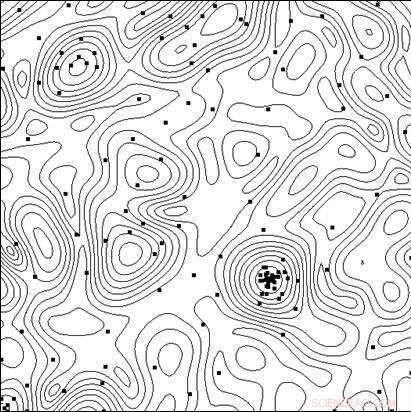

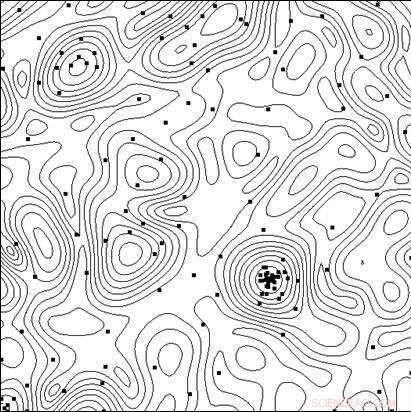

p As linhas do nível da função objetivo e os pontos dos testes realizados pelo algoritmo no processo de encontrar o mínimo. Crédito:Universidade Lobachevsky

p As linhas do nível da função objetivo e os pontos dos testes realizados pelo algoritmo no processo de encontrar o mínimo. Crédito:Universidade Lobachevsky

p Para criar sistemas técnicos e processos tecnológicos altamente eficazes, além do uso de novos princípios, novos materiais, novos efeitos físicos e outras soluções que determinam a estrutura geral do objeto que está sendo criado, os pesquisadores têm que escolher a melhor combinação dos parâmetros do objeto (dimensões geométricas, características elétricas, etc.), uma vez que quaisquer mudanças nos parâmetros com uma estrutura de objeto geral fixa podem impactar significativamente os indicadores de eficácia. p Em design auxiliado por computador, o teste de opções pode ser realizado analisando seu modelo matemático para diferentes valores de parâmetro. À medida que os modelos se tornam cada vez mais complexos, surge a necessidade de uma escolha direcionada de opções na busca pela solução ótima (mais eficaz).

p Uma equipe de cientistas da Universidade Estadual Lobachevsky de Nizhny Novgorod (UNN), liderada pelo Professor Roman Strongin, tem estudado as escolhas direcionadas na busca pela solução ideal. Envolve a análise de um subconjunto das opções possíveis com o objetivo de excluir casos obviamente não promissores e concentrar a pesquisa no subconjunto que contém a melhor opção.

p "Quando os modelos matemáticos dos processos que ocorrem em um objeto se tornam mais complicados, as características de eficiência não possuirão a propriedade de monotonicidade, é por isso que os métodos de pesquisa local são insuficientes para avaliar a melhor opção, "diz o professor Roman Strongin.

p Os procedimentos de busca global que são usados em tais problemas (também chamados de problemas de otimização multi-extremal) garantem que a busca seja direcionada, levando em consideração a natureza limitada da mudança nas características do objeto quando as mudanças em seus parâmetros são limitadas. A formulação matemática resultante pode assumir a forma da condição de Lipschitz, a condição uniforme de Hölder, etc.

p Problemas de otimização multi-extremal oferecem um escopo estreito de oportunidades de pesquisa analítica, e eles se tornam computacionalmente caros ao buscar soluções numéricas, uma vez que os custos computacionais crescem exponencialmente com a dimensão crescente do problema.

p De acordo com Konstantin Barkalov, Professor Associado do Departamento de Tecnologias de Software e Supercomputadores da UNN, o uso de modernos sistemas de computação paralela expande o escopo dos métodos de otimização global. Contudo, ao mesmo tempo, apresenta o desafio de paralelizar efetivamente o processo de busca.

p "É por isso que os principais esforços nesta área devem ser concentrados no desenvolvimento de métodos paralelos eficientes para resolver numericamente problemas de otimização multi-extremal e na criação de software apropriado para sistemas de computação modernos com base em tais métodos, "diz Barkalov.

p Usualmente, os métodos de otimização global (sequencial e paralelo) têm como objetivo resolver um único problema de otimização. Para resolver uma série de problemas q, os problemas da série são resolvidos sequencialmente, um após o outro. Portanto, a estimativa ótima no i-ésimo problema da série permanece indefinida até que todos os problemas anteriores da série (com os índices 1, 2, . . . , eu ? 1) foram completamente resolvidos. No caso de recursos computacionais limitados, as estimativas ótimas nos problemas i + 1, . . . , q não será obtido se os recursos de computação forem exauridos durante a solução do i-ésimo problema.

p Situações em que uma série de problemas q precisam ser resolvidos não são extraordinárias. Por exemplo, uma série de problemas escalares surge quando se busca um conjunto de Pareto na solução de problemas de otimização multi-objetivos. Nesse caso, a solução de um único problema escalar corresponde a um dos pontos ótimos de Pareto de um problema multiobjetivo. Uma série de problemas de otimização também surge ao usar métodos de redução de dimensão para resolver problemas de otimização multidimensional. Finalmente, uma série de problemas de teste também pode ser obtida com a ajuda de um gerador de problema de teste específico.

p Os cientistas acreditam que, ao resolver um conjunto de problemas, é necessário ter estimativas iniciais de soluções para todos os problemas de uma vez, para que a qualquer momento seja possível avaliar a oportunidade de continuar a busca. Nesse caso, é desejável ter as estimativas ótimas para todos os problemas com a mesma precisão.

p Executando muitos processos independentes em um sistema de computação paralela, cada um dos processos resolvendo um problema de uma série, tem uma série de desvantagens. Primeiro, ocorrerá um desequilíbrio da carga de trabalho entre os processadores. Se resolver o i-ésimo problema requer consideravelmente menos iterações do método do que resolver o j-ésimo problema, o processador encarregado de lidar com o i-ésimo problema permaneceria ocioso após a conclusão da tarefa. Segundo, as estimativas dos ótimos serão obtidas com precisão diferente em problemas diferentes. Problemas mais simples serão resolvidos com maior precisão, enquanto a precisão será menor para problemas mais complexos.

p O objetivo da pesquisa realizada na Universidade Lobachevsky era desenvolver um novo método para resolver uma série de problemas de otimização global que garantisse:(i) um carregamento uniforme de todos os núcleos / processadores empregados; (ii) uma convergência uniforme para as soluções de todos os problemas da série.

p Na parte teórica de seu artigo, Os cientistas da UNN também provaram o teorema da convergência uniforme do novo algoritmo. A parte experimental do trabalho consistiu em resolver uma série de várias centenas de problemas de teste de diferentes dimensões, e os resultados demonstraram de forma convincente a presença de convergência uniforme.

p Além disso, os cientistas da UNN consideram problemas de otimização global intensivos em computação, para a resolução dos quais os sistemas de supercomputação com desempenho exaflops podem ser necessários. Para superar essa complexidade computacional, os pesquisadores propõem esquemas computacionais paralelos generalizados, que pode envolver vários algoritmos paralelos eficientes de otimização global. Os esquemas propostos incluem métodos de decomposição multinível de computações paralelas para garantir a eficiência computacional de sistemas de supercomputação com multiprocessadores de memória compartilhada e distribuída usando milhares de processadores para atender aos desafios de otimização global.