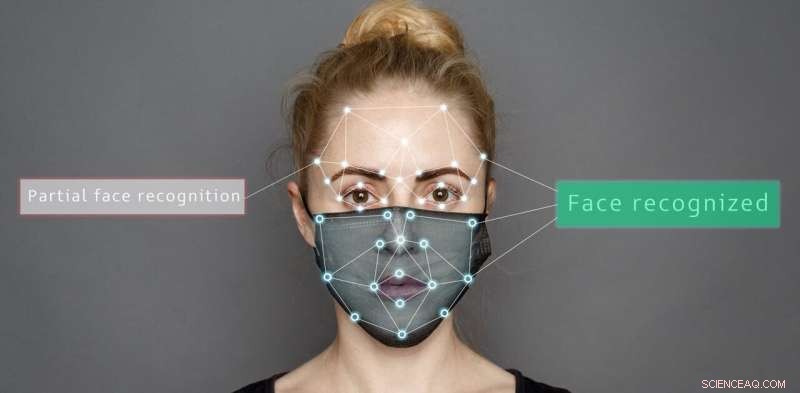

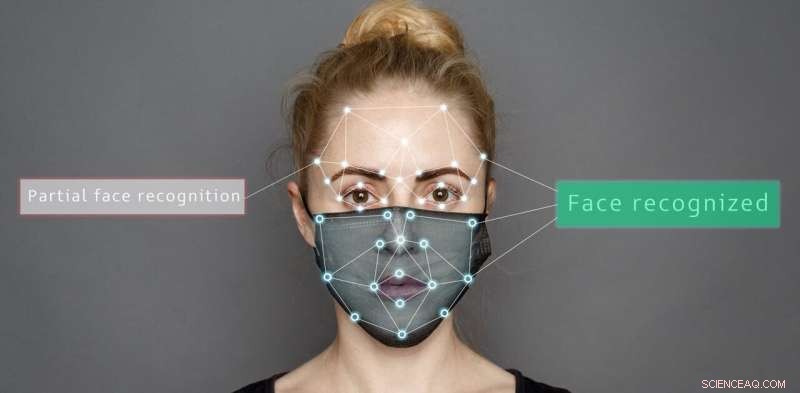

Quando os rostos estão parcialmente cobertos, nem as pessoas nem os algoritmos são bons em ler emoções

Crédito:Shutterstock/Sergey Tinyakov

Sistemas artificiais, como robôs de atendimento domiciliar ou tecnologia de assistência ao motorista, estão se tornando mais comuns, e é oportuno investigar se pessoas ou algoritmos são melhores na leitura de emoções, principalmente devido ao desafio adicional trazido pelas coberturas faciais.

Em nosso estudo recente, comparamos como máscaras faciais ou óculos de sol afetam nossa capacidade de determinar emoções diferentes em comparação com a precisão de sistemas artificiais.

Apresentamos imagens de expressões faciais emocionais e adicionamos dois tipos diferentes de máscaras – a máscara completa usada pelos trabalhadores da linha de frente e uma máscara lançada recentemente com uma janela transparente para permitir a leitura labial.

Nossas descobertas mostram que algoritmos e pessoas lutam quando os rostos são parcialmente obscurecidos. Mas os sistemas artificiais são mais propensos a interpretar mal as emoções de maneiras incomuns.

Os sistemas artificiais tiveram um desempenho significativamente melhor do que as pessoas no reconhecimento de emoções quando o rosto não estava coberto – 98,48% em comparação com 82,72% para sete tipos diferentes de emoção.

Mas dependendo do tipo de cobertura, a precisão tanto para pessoas quanto para sistemas artificiais variava. Por exemplo, óculos escuros obscureceram o medo das pessoas, enquanto máscaras parciais ajudaram tanto as pessoas quanto os sistemas artificiais a identificar a felicidade corretamente.

É importante ressaltar que as pessoas classificaram as expressões desconhecidas principalmente como neutras, mas os sistemas artificiais eram menos sistemáticos. Muitas vezes, eles selecionavam incorretamente a raiva para imagens obscurecidas com uma máscara completa e raiva, felicidade, neutralidade ou surpresa para expressões parcialmente mascaradas.

O estudo usou máscaras totais e parciais e óculos de sol para obscurecer partes do rosto. Autor fornecido

Decodificando expressões faciais Nossa capacidade de reconhecer emoções usa o sistema visual do cérebro para interpretar o que vemos. Temos até uma área do cérebro especializada em reconhecimento facial, conhecida como área de rosto fusiforme, que ajuda a interpretar as informações reveladas pelos rostos das pessoas.

Juntamente com o contexto de uma situação particular (interação social, fala e movimento corporal) e nossa compreensão de comportamentos passados e simpatia por nossos próprios sentimentos, podemos decodificar como as pessoas se sentem.

Um sistema de unidades de ação facial foi proposto para decodificar emoções com base em pistas faciais. Inclui unidades como "o levantador da bochecha" e "o puxador do canto do lábio", que são considerados parte de uma expressão de felicidade.

Em contraste, os sistemas artificiais analisam pixels de imagens de um rosto ao categorizar emoções. Eles passam valores de intensidade de pixel através de uma rede de filtros que imitam o sistema visual humano.

A descoberta de que os sistemas artificiais classificam erroneamente as emoções de rostos parcialmente obscurecidos é importante. Isso pode levar a comportamentos inesperados de robôs interagindo com pessoas usando máscaras faciais.

Imagine se eles classificarem erroneamente uma emoção negativa, como raiva ou tristeza, como uma expressão emocional positiva. Os sistemas artificiais tentariam interagir com uma pessoa agindo sobre a interpretação equivocada que ela está feliz. Isso pode ter efeitos prejudiciais para a segurança desses sistemas artificiais e humanos que interagem.

Você consegue ler a emoção dos pesquisadores em seus rostos cobertos? Tanto os sistemas artificiais quanto as pessoas ficam comprometidos na categorização das emoções quando os rostos são obscurecidos. Autor fornecido

Riscos de usar algoritmos para ler emoções Nossa pesquisa reitera que os algoritmos são suscetíveis a vieses em seu julgamento. Por exemplo, o desempenho de sistemas artificiais é muito afetado quando se trata de categorizar emoções a partir de imagens naturais. Mesmo apenas o ângulo ou a sombra do sol podem influenciar os resultados.

Os algoritmos também podem ser racialmente tendenciosos. Como constataram estudos anteriores, mesmo uma pequena mudança na cor da imagem, que nada tem a ver com expressões emocionais, pode levar a uma queda no desempenho de algoritmos usados em sistemas artificiais.

Como se isso não bastasse, mesmo pequenas perturbações visuais, imperceptíveis ao olho humano, podem fazer com que esses sistemas identifiquem erroneamente uma entrada como outra coisa.

Alguns desses problemas de classificação incorreta podem ser resolvidos. Por exemplo, os algoritmos podem ser projetados para considerar características relacionadas à emoção, como o formato da boca, em vez de coletar informações da cor e intensidade dos pixels.

Outra maneira de resolver isso é alterando as características dos dados de treinamento – superamostrando os dados de treinamento para que os algoritmos imitem melhor o comportamento humano e cometam erros menos extremos quando classificam incorretamente uma expressão.

Mas, no geral, o desempenho desses sistemas cai ao interpretar imagens em situações do mundo real quando os rostos estão parcialmente cobertos.

Embora os robôs possam reivindicar uma precisão maior do que a humana no reconhecimento de emoções para imagens estáticas de rostos completamente visíveis, em situações do mundo real que vivenciamos todos os dias, seu desempenho ainda não é humano.