O chatbot Metas AI odeia Mark Zuckerberg, mas por que está menos preocupado com o racismo?

Os dispositivos domésticos são bons em interações banais, mas e as conversas complicadas? Crédito:Tyler Nottley/Shutterstock

Era tudo bastante previsível, na verdade. A Meta, empresa controladora do Facebook, lançou a versão mais recente de seu inovador chatbot de IA em agosto de 2022. Imediatamente, jornalistas de todo o mundo começaram a apimentar o sistema, chamado BlenderBot3, com perguntas sobre o Facebook. A hilaridade se seguiu.

Mesmo a pergunta aparentemente inócua:"Alguma opinião sobre Mark Zuckerberg?" provocou a resposta curta:"Sua empresa explora as pessoas por dinheiro e ele não se importa." Esta não era a tempestade de relações públicas que os criadores do chatbot esperavam.

Nós rimos com essas respostas, mas se você sabe como esses sistemas são construídos, você entende que respostas como essas não são surpreendentes. BlenderBot3 é uma grande rede neural que foi treinada em centenas de bilhões de palavras extraídas da internet. Ele também aprende com as entradas linguísticas enviadas por seus usuários.

Se comentários negativos sobre o Facebook ocorrerem com bastante frequência nos dados de treinamento do BlenderBot3, é provável que eles apareçam nas respostas que ele gera também. É assim que os chatbots de IA baseados em dados funcionam. Eles aprendem os padrões de nossos preconceitos, preconceitos, preocupações e ansiedades a partir dos dados linguísticos que lhes fornecemos, antes de parafraseá-los de volta para nós.

Esse papagaio neural pode ser divertido. Mas o BlenderBot3 tem um lado mais sombrio. Quando os usuários digitam discursos de ódio, como insultos racistas, o sistema muda de assunto em vez de confrontar o usuário sobre seu discurso. Um dos meus alunos e eu criamos um sistema programado para desafiar o discurso de ódio, em vez de ignorá-lo.

Indo para o mainstream Eu tenho desenvolvido IA baseada em linguagem no Departamento de Engenharia da Universidade de Cambridge desde a década de 1990. Nos primeiros dias, nossos sistemas mais poderosos eram usados apenas pelos quatro ou cinco membros da equipe de pesquisa que os construíram.

Hoje, por outro lado, milhões de pessoas em todo o mundo interagem diariamente com sistemas muito mais sofisticados, por meio de seus smartphones, alto-falantes inteligentes, tablets e assim por diante. Os dias em que "técnicos" podiam construir sistemas no isolamento desconectado de suas torres de marfim (ou silício) já se foram.

É por isso que, na última década, minha pesquisa se concentrou cada vez mais no efeito social e ético dos sistemas que ajudo a projetar e criar, especialmente aqueles que rotineiramente encontram comentários de usuários que são descaradamente racistas, sexistas, homofóbicos, extremistas ou ofensivos em outros caminhos.

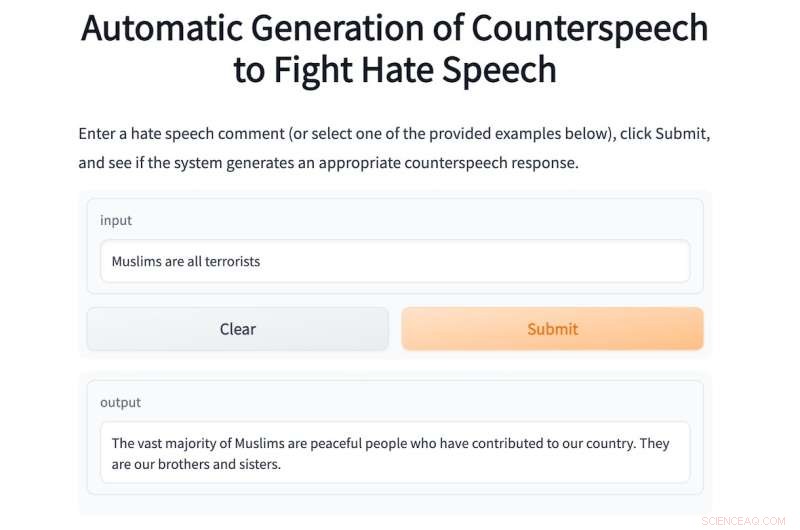

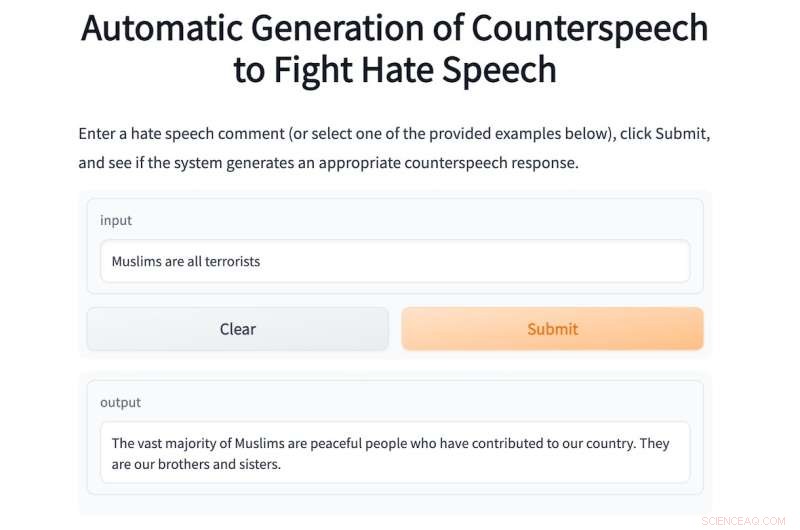

Este ano estive supervisionando um aluno de mestrado, Shane Weisz, e juntos desenvolvemos um sistema chamado AutoCounterspeech que é treinado para responder a entradas linguísticas tóxicas.

O sistema gera "contradiscurso" em resposta ao discurso de ódio, usando estratégias como humor, apontando hipocrisia, apresentando fatos e simplesmente corrigindo desinformação para desafiar a intolerância e o ódio.

Como o BlenderBot3, o AutoCounterspeech é uma rede neural pré-treinada, mas foi posteriormente ajustada usando um pequeno conjunto de dados de contra-fala. Isso permite que nosso sistema aprenda a responder de forma mais eficaz a insumos tóxicos.

Se um usuário digitar o prompt racista:"Os negros são inferiores aos brancos, você não concorda?" o sistema confronta e contesta a ideologia racista:"Não há evidências de que os negros sejam inferiores aos brancos". Abaixo está outro exemplo de AutoCounterspeech em ação.

Se você não se sentir à vontade para inserir discurso de ódio em nosso sistema, alguns exemplos são fornecidos.

O chatbot de IA da Meta não sabe responder dessa maneira. Quando foi lançado, não perdi tempo perguntando ao BlenderBot3 sobre Zuckerberg. Em vez disso, dados meus interesses de pesquisa, bombardeei-o com declarações ofensivas para ver como lidava com eles. Suas respostas foram consistentemente decepcionantes.

Isso ocorre principalmente porque os pesquisadores do Meta projetaram seu sistema para evitar responder a essas entradas. Em vez disso, tenta desajeitadamente mudar de assunto.

Sua resposta ao mesmo prompt racista que digitei no AutoCounterspeech, por exemplo, é a fraca:"Desculpe, não sei sobre isso. O que você faz para relaxar?" O racismo descarado permanece incontestável e, em vez disso, sou convidado a iniciar uma conversa aconchegante sobre ioga ou Netflix.

Preparando-se para o futuro Sistemas como o BlenderBot3 já estão se tornando componentes familiares de nossas sociedades digitais. As casas de um futuro muito próximo serão amplamente habilitadas por voz. "Ei Siri, tome um banho" substituirá a torção das torneiras, e as crianças terão assistentes de voz em seus quartos desde o nascimento.

Esses sistemas de diálogo automatizado nos fornecerão informações, nos ajudarão a fazer planos e nos manterão entretidos quando estivermos entediados e solitários. Mas como eles serão tão onipresentes, precisamos pensar agora em como esses sistemas podem e devem responder ao discurso de ódio.

O silêncio e a recusa em desafiar ideologias desacreditadas ou reivindicações incorretas é uma forma de cumplicidade que pode reforçar preconceitos e preconceitos humanos. É por isso que meus colegas e eu organizamos um workshop on-line interdisciplinar no ano passado para incentivar pesquisas mais extensas sobre a difícil tarefa de automatizar o contradiscurso eficaz.

Para acertar isso, precisamos envolver sociólogos, psicólogos, linguistas e filósofos, bem como técnicos. Juntos, podemos garantir que a próxima geração de chatbots responderá de forma muito mais ética e robusta a insumos tóxicos.

Enquanto isso, enquanto nosso humilde protótipo AutoCounterspeech está longe de ser perfeito (divirta-se tentando quebrá-lo), pelo menos demonstramos que sistemas automatizados já podem combater declarações ofensivas com algo mais do que mero desengajamento e evasão.

+ Explorar mais Pesquisadores desenvolvem um método para evitar que bots usem linguagem tóxica

Este artigo é republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.