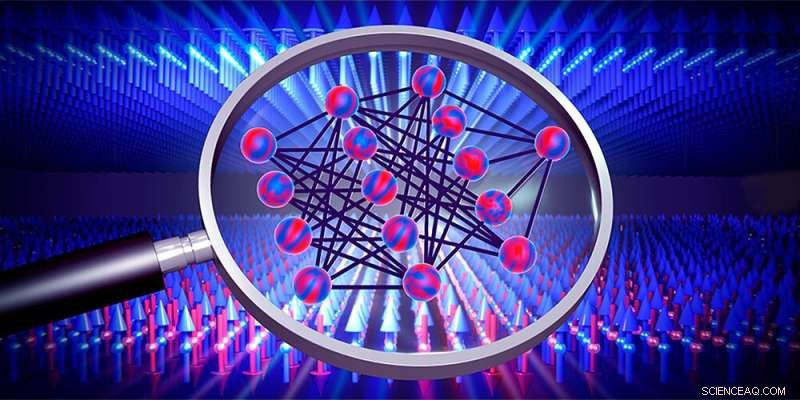

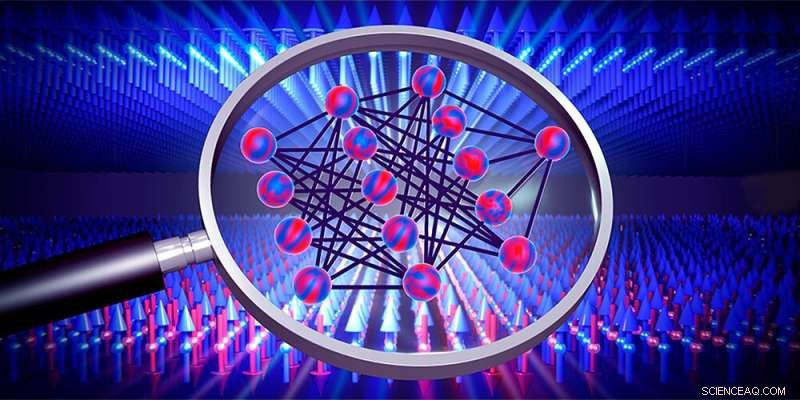

Redes neurais (centro) podem ser usadas para investigar transições de fase, por exemplo, de materiais magnéticos (setas). Crédito:Departamento de Física, Universidade de Basileia

As redes neurais são algoritmos de aprendizado que aproximam a solução de uma tarefa treinando com os dados disponíveis. No entanto, geralmente não está claro como exatamente eles conseguem isso. Dois jovens físicos da Basileia agora derivaram expressões matemáticas que permitem calcular a solução ótima sem treinar uma rede. Seus resultados não apenas fornecem informações sobre como esses algoritmos de aprendizado funcionam, mas também podem ajudar a detectar transições de fase desconhecidas em sistemas físicos no futuro.

As redes neurais são baseadas no princípio de funcionamento do cérebro. Esses algoritmos de computador aprendem a resolver problemas por meio de treinamento repetido e podem, por exemplo, distinguir objetos ou processar a linguagem falada.

Há vários anos, os físicos vêm tentando usar redes neurais para detectar transições de fase também. As transições de fase são familiares para nós da experiência cotidiana, por exemplo, quando a água congela em gelo, mas também ocorrem de forma mais complexa entre diferentes fases de materiais magnéticos ou sistemas quânticos, onde muitas vezes são difíceis de detectar.

Julian Arnold e Frank Schäfer, dois Ph.D. estudantes do grupo de pesquisa do Prof. Dr. Christoph Bruder na Universidade de Basel, agora derivam expressões matemáticas com as quais tais transições de fase podem ser descobertas mais rapidamente do que antes. Eles publicaram recentemente seus resultados na

Physical Review X .

Pular o treinamento economiza tempo Uma rede neural aprende variando sistematicamente os parâmetros em muitas rodadas de treinamento, a fim de fazer com que as previsões calculadas pela rede correspondam aos dados de treinamento alimentados cada vez mais de perto. Esses dados de treinamento podem ser os pixels de imagens ou, de fato, os resultados de medições em um sistema físico exibindo transições de fase sobre as quais se gostaria de aprender alguma coisa.

"As redes neurais já se tornaram muito boas em detectar transições de fase", diz Arnold, "mas como exatamente elas fazem isso geralmente permanece completamente obscuro". Para mudar essa situação e iluminar a "caixa preta" de uma rede neural, Arnold e Schäfer analisaram o caso especial de redes com um número infinito de parâmetros que, em princípio, também passam por infinitas rodadas de treinamento.

Geralmente, sabe-se há muito tempo que as previsões de tais redes sempre tendem a uma determinada solução ótima. Arnold e Schäfer tomaram isso como um ponto de partida para derivar fórmulas matemáticas que permitem calcular diretamente essa solução ótima sem realmente ter que treinar a rede. "Esse atalho reduz enormemente o tempo de computação", explica Arnold:"O tempo necessário para calcular nossa solução é tão longo quanto uma única rodada de treinamento de uma pequena rede".

Insight sobre a rede Além de economizar tempo, o método desenvolvido pelos físicos da Basileia também tem a vantagem de que as equações derivadas dão alguma visão sobre o funcionamento das redes neurais e, portanto, dos sistemas físicos sob investigação.

Até agora, Arnold e Schäfer testaram seu método em dados gerados por computador. Em breve, eles também querem aplicar o método a dados de medição reais. No futuro, isso poderá permitir detectar transições de fase ainda desconhecidas, por exemplo, em simuladores quânticos ou em novos materiais.

+ Explorar mais Novo método para comparar redes neurais expõe como funciona a inteligência artificial