Ilustração de agentes jogando Capture the Flag, mostrando uma variedade de comportamentos. Crédito:DeepMind

Desde os primeiros dias do xadrez e paciência virtuais, os videogames têm sido um campo de jogo para o desenvolvimento da inteligência artificial (IA). Cada vitória da máquina contra o humano ajudou a tornar os algoritmos mais inteligentes e eficientes. Mas, para resolver problemas do mundo real, como automatizar tarefas complexas, incluindo direção e negociação, esses algoritmos devem navegar em ambientes mais complexos do que jogos de tabuleiro, e aprender a trabalhar em equipe. Ensinar IA como trabalhar e interagir com outros jogadores para ter sucesso tinha sido uma tarefa intransponível - até agora.

Em um novo estudo, os pesquisadores detalharam uma maneira de treinar algoritmos de IA para atingir níveis humanos de desempenho em um jogo multiplayer 3-D popular - uma versão modificada do Quake III Arena no modo Capture the Flag.

Mesmo que a tarefa deste jogo seja simples - duas equipes opostas competem para capturar as bandeiras uma da outra navegando em um mapa - vencer exige uma tomada de decisão complexa e uma capacidade de prever e responder às ações dos outros jogadores.

Esta é a primeira vez que uma IA alcançou habilidades humanas em um videogame em primeira pessoa. Então, como os pesquisadores fizeram isso?

A curva de aprendizagem do robô

Em 2019, vários marcos na pesquisa de IA foram alcançados em outros jogos de estratégia multiplayer. Cinco "bots - jogadores controlados por uma IA - derrotaram uma equipe profissional de e-sports em um jogo de DOTA 2. Jogadores humanos profissionais também foram derrotados por uma IA em um jogo de StarCraft II. Em todos os casos, uma forma de aprendizagem por reforço foi aplicada, em que o algoritmo aprende por tentativa e erro e pela interação com seu ambiente.

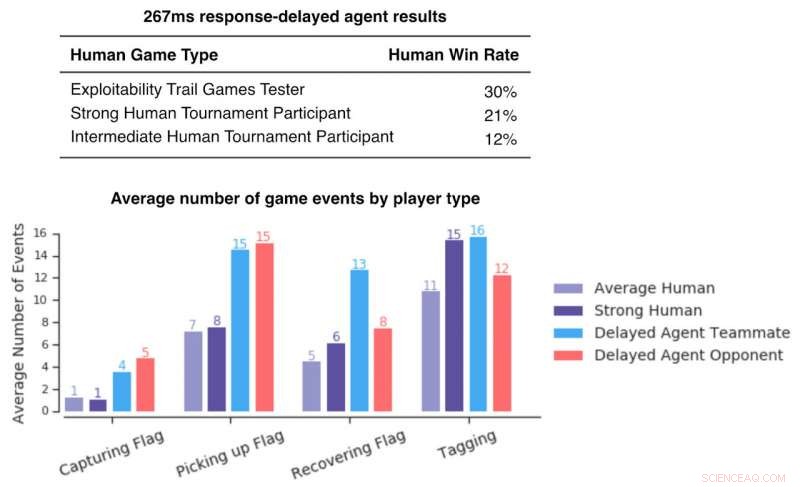

Figura mostrando as taxas de vitória de jogadores humanos contra agentes com resposta retardada. Estes são baixos, indicando que mesmo com atrasos de reação comparáveis aos humanos, os agentes superam os jogadores humanos. Crédito:DeepMind

Gif mostrando os resultados mais recentes de agentes jogando em dois mapas completos da Arena Quake III com modos de jogo diferentes. Crédito:DeepMind

Os cinco bots que derrotaram os humanos no DOTA 2 não aprenderam com os humanos jogando - eles foram treinados exclusivamente jogando partidas contra seus próprios clones. A melhoria que lhes permitiu derrotar jogadores profissionais veio do escalonamento de algoritmos existentes. Devido à velocidade do computador, a IA pode jogar em poucos segundos um jogo que leva minutos ou mesmo horas para os humanos jogarem. Isso permitiu que os pesquisadores treinassem sua IA com 45, 000 anos de jogo em dez meses em tempo real.

O bot Capture the Flag do estudo recente também começou a aprender do zero. Mas em vez de jogar contra seu clone idêntico, uma coorte de 30 bots foi criada e treinada em paralelo com seu próprio sinal de recompensa interno. Cada bot dentro dessa população iria jogar junto e aprender uns com os outros. Como David Silver - um dos cientistas pesquisadores envolvidos - observa, A IA está começando a "remover as restrições do conhecimento humano ... e a criar o próprio conhecimento".

A velocidade de aprendizado para humanos ainda é muito mais rápida do que os algoritmos de aprendizado de reforço profundo mais avançados. Ambos os bots da OpenAI e AlphaStar da DeepMind (o bot jogando StarCraft II) devoraram milhares de anos de jogabilidade antes de serem capazes de atingir um nível humano de desempenho. Estima-se que esse treinamento custe vários milhões de dólares. No entanto, uma IA autodidata capaz de derrotar os humanos em seu próprio jogo é uma descoberta emocionante que pode mudar a forma como vemos as máquinas.

O futuro dos humanos e das máquinas

A IA é frequentemente retratada substituindo ou complementando as capacidades humanas, mas raramente como um membro da equipe de pleno direito, realizando a mesma tarefa que os seres humanos. Como esses experimentos de videogame envolvem colaboração máquina-homem, eles oferecem um vislumbre do futuro.

Jogadores humanos de Capture the Flag classificaram os bots como mais colaborativos do que outros humanos, mas os jogadores do DOTA 2 tiveram uma reação mista aos seus companheiros de equipe de IA. Alguns estavam bastante entusiasmados, dizendo que se sentiram apoiados e que aprenderam jogando ao lado deles. Sheever, um jogador profissional DOTA 2, falou sobre sua experiência de parceria com bots:"Na verdade foi bom; [o companheiro de equipe de IA] deu sua vida por mim em algum momento. Ele tentou me ajudar, pensando "Tenho certeza de que ela sabe o que está fazendo" e, obviamente, eu não sabia. Mas, você sabe, ele acreditou em mim. Eu não entendo muito isso com companheiros de equipe [humanos]. "

Outros estavam menos entusiasmados, mas como a comunicação é um pilar de qualquer relacionamento, melhorar a comunicação homem-máquina será crucial no futuro. Os pesquisadores já adaptaram alguns recursos para tornar os bots mais "amigáveis aos humanos, "como fazer bots esperar artificialmente antes de escolher seu personagem durante o draft da equipe antes do jogo, para evitar pressionar os humanos.

Mas a IA deve aprender conosco ou continuar a se ensinar? A autoaprendizagem sem imitar os humanos poderia ensinar mais eficiência e criatividade à IA, mas isso poderia criar algoritmos mais apropriados para tarefas que não envolvem colaboração humana, como robôs de armazenamento.

Por outro lado, pode-se argumentar que ter uma máquina treinada por humanos seria mais intuitivo - humanos usando tal IA poderiam entender por que uma máquina fez o que fez. À medida que a IA fica mais inteligente, nós todos teremos mais surpresas.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.