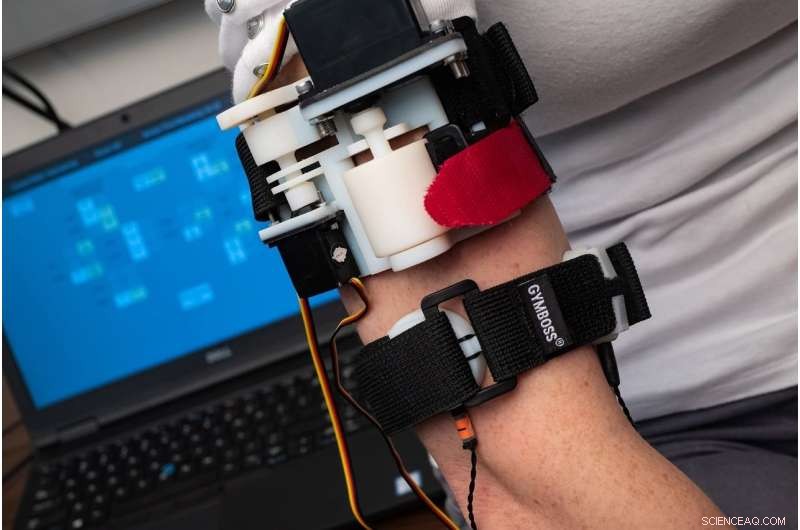

Um novo estudo realizado por pesquisadores do Laboratório de Mecatrônica e Interfaces Tácticas da Rice University descobriu que os usuários precisam de menos de duas horas de treinamento para aprender a "sentir" a maioria das palavras que são transmitidas por uma braçadeira háptica que se comunica com sinais compostos de compressão, alongamento e vibração. Crédito:Jeff Fitlow / Rice University

Imagine o pânico. Os alarmes de incêndio soam. A fumaça enche a sala, e você fica apenas com o sentido do tato, sentindo desesperadamente ao longo das paredes enquanto tenta encontrar a porta.

Agora imagine a tecnologia guiando você pelo sentido do tato. Seu smartwatch, alertado pelos mesmos alarmes, começa a "falar" através de sua pele, dando instruções com vibrações codificadas, aperta e puxa com significados tão claros quanto palavras faladas.

Esse cenário pode se concretizar no futuro graças à tecnologia em desenvolvimento no laboratório da engenheira mecânica da Rice, Marcia O'Malley, que passou mais de 15 anos estudando como as pessoas podem usar a sensação tátil para interagir com a tecnologia - sejam robôs, membros protéticos ou software de reabilitação de AVC.

"A pele cobre todo o nosso corpo e tem muitos tipos de receptores nela, e vemos que, como um canal de informação subutilizado, "disse O'Malley, diretor da Rice Robotics Initiative e do Rice's Mechatronics and Haptic Interfaces Laboratory (MAHI).

Situações de emergência como o cenário de incêndio descrito acima são apenas um exemplo. O'Malley disse que existem muitas "outras situações em que você pode não querer olhar para uma tela, ou você já tem muitas coisas exibidas visualmente. Por exemplo, um cirurgião ou piloto pode achar muito útil ter outro canal de comunicação. "

Nathan Dunkelberger, estudante de pós-graduação da Rice University, trabalhando no laboratório do MAHI. Crédito:Jeff Fitlow / Rice University

Com novo financiamento da National Science Foundation, O'Malley e o colaborador da Universidade de Stanford, Allison Okamura, em breve começarão a projetar e testar soft, dispositivos vestíveis que permitem comunicações diretas com base no toque de robôs próximos. O financiamento, que é possibilitado pela National Robotics Initiative, é voltado para o desenvolvimento de novas formas de comunicação que contornem a confusão visual e o ruído para se comunicar de forma rápida e clara.

"Alguns armazéns e fábricas já têm mais robôs do que trabalhadores humanos, e tecnologias como carros autônomos e dispositivos fisicamente auxiliares tornarão as interações entre humanos e robôs muito mais comuns no futuro próximo, "disse O'Malley, Stanley C. Moore, professor de Engenharia Mecânica de Rice e professor de ciência da computação e engenharia elétrica e da computação.

Suave, dispositivos vestíveis podem fazer parte de um uniforme, como uma manga, luva, pulseira ou cinto. Ao fornecer uma série de dicas táteis, como um aperto forte ou suave, ou um estiramento da pele em uma determinada direção e local, O'Malley disse que pode ser possível construir um "vocabulário" significativo de sensações que carregam significados específicos.

"Eu posso ver a seta de um carro, mas só se eu estiver olhando para ele, "O'Malley disse." Queremos tecnologia que permita às pessoas sentir os robôs ao seu redor e entender claramente o que esses robôs estão prestes a fazer e onde estão prestes a estar. Idealmente, se fizermos isso corretamente, as dicas serão fáceis de aprender e intuitivas. "

Os alunos de pós-graduação da Rice University Jenny Sullivan (à esquerda) e Nathan Dunkelberger demonstram a braçadeira háptica MISSIVE no Laboratório de Mecatrônica e Interfaces Táticas. Crédito:Jeff Fitlow / Rice University

Por exemplo, em um estudo apresentado este mês no Simpósio Internacional de Computadores Vestíveis (ISWC) em Cingapura, O estudante de pós-graduação do MAHI Nathan Dunkelberger mostrou que os usuários precisavam de menos de duas horas de treinamento para aprender a "sentir" a maioria das palavras transmitidas por uma braçadeira háptica. A "interface multissensorial de alongamento desenvolvida pela MAHI, elementos vibrotáteis integrados e de compressão, "ou MISSIVE, consiste em duas bandas que se ajustam ao braço. Um deles pode apertar suavemente, como um medidor de pressão arterial, e também pode esticar levemente ou puxar a pele em uma direção. A segunda banda tem motores vibrotáteis - os mesmos alarmes vibratórios usados na maioria dos celulares - na frente, de volta, lados esquerdo e direito do braço.

Usando essas dicas em combinação, MAHI criou um vocabulário de 23 dos sons vocais mais comuns para falantes de inglês. Esses sons, que são chamados de fonemas, são usados em combinação para formar palavras. Por exemplo, as palavras "ouch" e "chow" contêm os mesmos dois fonemas, "ow" e "ch, "em ordem diferente. O'Malley disse que se comunicar com os fonemas é mais rápido do que soletrar as palavras letra por letra, e os sujeitos não precisam saber como uma palavra é escrita, apenas como é pronunciado.

Dunkelberger disse que os falantes de inglês usam 39 fonemas, mas para o estudo de prova de conceito, ele e seus colegas do MAHI usaram 23 dos mais comuns. Em testes, os sujeitos receberam treinamento limitado - apenas 1 hora, 40 minutos - que envolvia ouvir o fonema falado e também senti-lo exibido por MISSIVE. Em testes posteriores, os sujeitos foram solicitados a identificar 150 palavras faladas consistindo de dois a seis fonemas cada. Aqueles testados acertaram 86% das palavras.

"O que isso mostra é que é possível, com uma quantidade limitada de treinamento, para ensinar às pessoas um pequeno vocabulário de palavras que elas possam lembrar com alta precisão, "O'Malley disse." E definitivamente há coisas que podemos otimizar. Poderíamos tornar as pistas mais evidentes. Poderíamos refinar o protocolo de treinamento. Esta foi a nossa abordagem de protótipo, e funcionou muito bem. "

No projeto NSF, ela disse que a equipe não se concentrará em transmitir palavras, mas transmitindo informações não verbais.

"Existem muitas aplicações potenciais para sistemas de feedback tátil vestíveis para permitir a comunicação entre os indivíduos, entre indivíduos e robôs ou entre indivíduos e agentes virtuais como o Google Maps, "O'Malley disse." Imagine um smartwatch que pode transmitir toda uma linguagem de dicas diretamente para você, e em particular, para que você não precise olhar para a tela. "