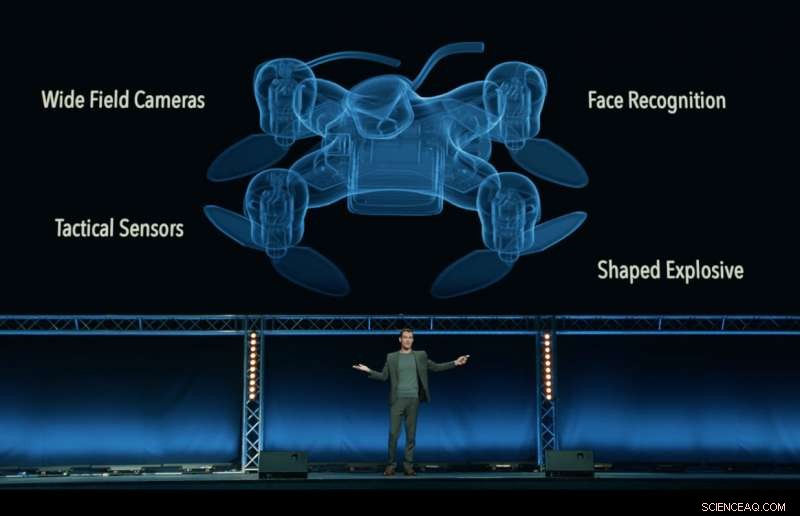

Ainda do vídeo 'Slaughterbots', produzido pelo Future of Life Institute, que mostra um futuro distópico fictício de drones assassinos enxameando o mundo. Crédito:Instituto Futuro da Vida

Quem é quem dos CEOs, engenheiros e cientistas da indústria de tecnologia, incluindo Google DeepMind, a Fundação XPRIZE e Elon Musk - assinaram uma promessa de "nem participar nem apoiar o desenvolvimento, fabricar, troca, ou uso de armas autônomas letais ".

Lançado em Estocolmo na Conferência Conjunta Internacional de Inteligência Artificial de 2018 (IJCAI), a maior reunião de pesquisa de IA do mundo com mais de 5, 000 participantes, a promessa foi assinada por 150 empresas e mais de 2, 400 pessoas de 90 países trabalhando em inteligência artificial (IA) e robótica.

Signatários corporativos incluem Google DeepMind, University College London, a Fundação XPRIZE, ClearPath Robotics / OTTO Motors, a European Association for AI, e a Sociedade Sueca de IA. Indivíduos incluem chefe de pesquisa do Google.ai Jeff Dean, Stuart Russell, pioneiro da IA, Yoshua Bengio, Anca Dragan e Toby Walsh, e o deputado trabalhista britânico Alex Sobel.

O penhor, organizado pelo Future of Life Institute, desafia os governos, academia e indústria para seguir seu exemplo, dizendo:"Nós, o abaixo assinado, apelar aos governos e líderes governamentais para criar um futuro com fortes normas internacionais, regulamentos e leis contra armas autônomas letais. ... Pedimos que as empresas e organizações de tecnologia, assim como líderes, formuladores de políticas, e outros indivíduos, junte-se a nós nesta promessa. "

Max Tegmark, professor de física do Massachusetts Institute of Technology e presidente do Future of Life Institute, anunciou a promessa.

"Estou animado para ver os líderes de IA mudando da conversa para a ação, implementar uma política que os políticos não conseguiram colocar em prática, "Tegmark disse." AI tem um enorme potencial para ajudar o mundo - se estigmatizarmos e prevenirmos seu abuso. As armas de IA que decidem autonomamente matar pessoas são tão nojentas e desestabilizadoras quanto as armas biológicas, e deve ser tratada da mesma maneira. "

Os sistemas de armas autônomas letais (LAWS) - também chamados de "robôs assassinos" - são armas que podem identificar, alvo, e matar uma pessoa, sem um humano 'in-the-loop'. Isso é, ninguém toma a decisão final de autorizar a força letal:a decisão e a autorização sobre se alguém vai morrer ou não é deixada para o sistema autônomo de armas. Isso não inclui os drones de hoje, que estão sob controle humano; nem sistemas autônomos que meramente se defendem contra outras armas.

A promessa começa com a declaração:"A inteligência artificial está posicionada para desempenhar um papel cada vez maior nos sistemas militares. Há uma oportunidade e uma necessidade urgentes para os cidadãos, formuladores de políticas, e líderes para distinguir entre usos aceitáveis e inaceitáveis de IA. "

Outro organizador importante da promessa, Toby Walsh, um professor de inteligência artificial na University of New South Wales em Sydney, aponta as espinhosas questões éticas que cercam as LEIS:"Não podemos entregar a decisão sobre quem vive e quem morre às máquinas. Eles não têm a ética para fazê-lo. Encorajo você e suas organizações a se comprometerem a garantir que a guerra não tornar-se mais terrível desta forma. "

Ryan Gariepy, Fundador e CTO da Clearpath Robotics e OTTO Motors, um forte oponente de armas autônomas letais, ecoou o apelo:"Clearpath continua a acreditar que a proliferação de sistemas de armas autônomas letais permanece um perigo claro e presente para os cidadãos de todos os países do mundo. Nenhuma nação estará segura, não importa o quão poderoso seja.

"As preocupações da Clearpath são compartilhadas por uma ampla variedade de outras empresas e desenvolvedores de sistemas autônomos importantes, e esperamos que os governos em todo o mundo decidam investir seu tempo e esforço em sistemas autônomos que tornam suas populações mais saudáveis, mais seguro, e mais produtivo em vez de sistemas cujo único uso é a implantação de força letal, " ele adicionou.

Toby Walsh, professor de inteligência artificial na Universidade de New South Wales, na Austrália, em Sydney, com um robô Baxter. Crédito:Grant Turner / UNSW

Além das questões éticas preocupantes que cercam as armas autônomas letais, muitos defensores de uma proibição internacional das LEIS temem que sejam difíceis de controlar - mais fáceis de hackear, é mais provável que acabe no mercado negro, e mais fácil para terroristas e déspotas obterem - o que pode se tornar desestabilizador para todos os países. Tal cenário é representado no vídeo Slaughterbots lançado pela FLI.

Em dezembro de 2016, a Conferência de Revisão da Convenção sobre Armas Convencionais (CCW) das Nações Unidas iniciou a discussão formal sobre as LEIS. 26 países participantes da Conferência anunciaram até agora apoio a algum tipo de proibição, incluindo a China.

Essa proibição não é sem precedentes:armas biológicas e armas químicas também foram proibidas, não apenas por razões éticas e humanitárias, mas também pela ameaça desestabilizadora que representavam.

A próxima reunião da ONU sobre LEIS será realizada em agosto de 2018, e os signatários da promessa esperam que sua promessa incentive os legisladores a desenvolver um compromisso com um acordo internacional entre os países.

Como afirma a promessa:"Nós, o abaixo assinado, apelar aos governos e líderes governamentais para criar um futuro com fortes normas internacionais, regulamentos e leis contra armas autônomas letais. ... Pedimos que as empresas e organizações de tecnologia, assim como líderes, formuladores de políticas, e outros indivíduos, junte-se a nós nesta promessa. "

O texto completo da promessa

A inteligência artificial (IA) está posicionada para desempenhar um papel cada vez mais importante nos sistemas militares. Há uma oportunidade e necessidade urgentes para os cidadãos, formuladores de políticas, e líderes para distinguir entre usos aceitáveis e inaceitáveis de IA.

Nesta Luz, nós, os abaixo assinados, concordamos que a decisão de tirar uma vida humana nunca deve ser delegada a uma máquina. Há um componente moral nesta posição, que não devemos permitir que as máquinas tomem decisões vitais pelas quais os outros - ou ninguém - serão culpados.

Há também um argumento pragmático poderoso:armas autônomas letais, selecionar e engajar alvos sem intervenção humana, seria perigosamente desestabilizador para cada país e indivíduo. Milhares de pesquisadores de IA concordam que, ao eliminar o risco, atribuibilidade, e dificuldade de tirar vidas humanas, armas autônomas letais podem se tornar poderosos instrumentos de violência e opressão, especialmente quando vinculado a sistemas de vigilância e dados.

Além disso, as armas autônomas letais têm características bastante diferentes das nucleares, armas químicas e biológicas, e as ações unilaterais de um único grupo poderiam facilmente desencadear uma corrida armamentista que a comunidade internacional carece de ferramentas técnicas e sistemas de governança global para administrar. Estigmatizar e prevenir tal corrida armamentista deve ser uma alta prioridade para a segurança nacional e global.

Nós, o abaixo assinado, apelar aos governos e líderes governamentais para criar um futuro com fortes normas internacionais, regulamentos e leis contra armas autônomas letais. Estes atualmente ausentes, optamos por nos manter um alto padrão:não participaremos nem apoiaremos o desenvolvimento, fabricar, troca, ou uso de armas autônomas letais. Pedimos que as empresas e organizações de tecnologia, assim como líderes, formuladores de políticas, e outros indivíduos, junte-se a nós nesta promessa.