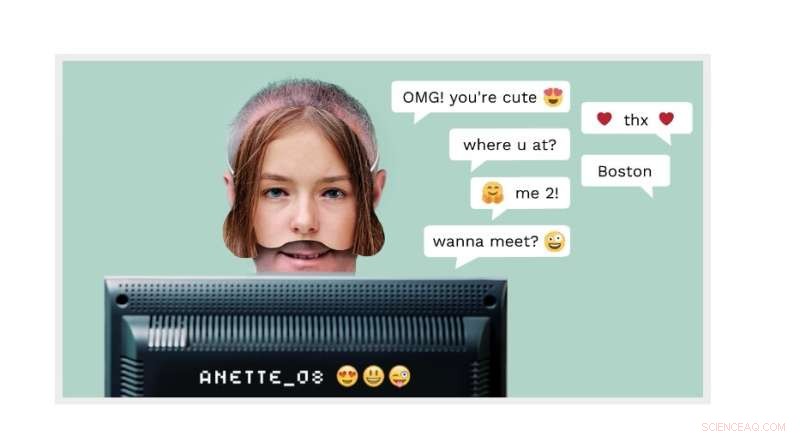

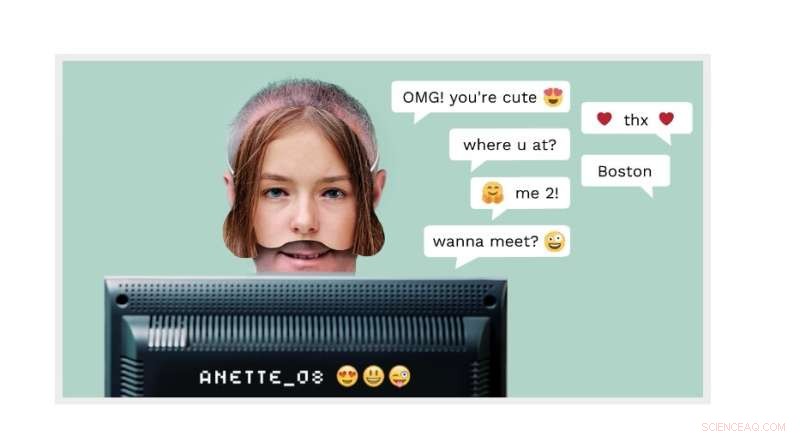

Cyber grooming:Um homem adulto pode fingir ser um menino de 14 anos online. Agora, a tecnologia de detecção NTNU em uso em um spin-off comercial chamado AiBA pode detectar o criminoso. Crédito:página inicial da AiBA

Milhões de crianças acessam salas de bate-papo todos os dias para conversar com outras crianças. Uma dessas "crianças" poderia muito bem ser um homem fingindo ser uma menina de 12 anos com intenções muito mais sinistras do que conversar sobre episódios de "My Little Pony".

O inventor e professor da NTNU Patrick Bours, da AiBA, está trabalhando para evitar exatamente esse tipo de comportamento predatório. O AiBA, um moderador digital de IA que Bours ajudou a fundar, pode oferecer uma ferramenta baseada em biometria comportamental e algoritmos que detectam abusadores sexuais em bate-papos online com crianças.

E agora, conforme relatado recentemente pelo Dagens Næringsliv, um jornal financeiro nacional, a empresa levantou capital de NOK 7,5. milhões, com investidores como Firda e Wiski Capital, duas empresas sediadas na Noruega.

Em seus esforços mais recentes, a empresa está trabalhando com 50 milhões de linhas de bate-papo para desenvolver uma ferramenta que encontrará conversas de alto risco em que os agressores tentam entrar em contato com crianças. O objetivo é identificar características distintivas no que os abusadores deixam para trás nas plataformas de jogos e nas mídias sociais.

"Estamos visando os principais produtores de jogos e esperamos colocar algumas centenas de jogos na plataforma", disse Hege Tokerud, cofundador e gerente geral, ao Dagens Næringsliv.

A preparação cibernética é um problema crescente Cyber grooming é quando adultos fazem amizade com crianças online, muitas vezes usando um perfil falso.

No entanto, "alguns predadores sexuais simplesmente aparecem e perguntam se a criança está interessada em conversar com uma pessoa mais velha, então não há necessidade de uma identidade falsa", disse Bours.

O objetivo do perpetrador é muitas vezes atrair as crianças para um canal privado para que as crianças possam enviar fotos de si mesmas, com e sem roupas, e talvez eventualmente marcar um encontro com o jovem.

Os perpetradores não se importam tanto em enviar fotos deles mesmos, disse Bours. "O exibicionismo é apenas uma pequena parte de sua motivação", disse ele. "Tirar fotos é muito mais interessante para eles, e não apenas fotos, mas fotos ao vivo por meio de uma webcam."

"Supervisionar todas essas conversas para evitar abusos é impossível para moderadores que monitoram o sistema manualmente. O que é necessário é uma automação que notifique os moderadores sobre conversas em andamento", diz Bours.

A AiBA desenvolveu um sistema usando vários algoritmos que oferece às grandes empresas de bate-papo uma ferramenta que pode discernir se adultos ou crianças estão conversando. É aí que entra a biometria comportamental.

Um homem adulto pode fingir ser um menino de 14 anos online. Mas a maneira como ele escreve – como seu ritmo de digitação ou sua escolha de palavras – pode revelar que ele é um homem adulto.

Chave de aprendizado de máquina A ferramenta AiBA usa métodos de aprendizado de máquina para analisar todos os chats e avaliar o risco com base em determinados critérios. O nível de risco pode subir e descer um pouco durante a conversa à medida que o sistema avalia cada mensagem. O símbolo de aviso vermelho acende o bate-papo se o nível de risco ficar muito alto, notificando o moderador que pode analisar a conversa e avaliá-la melhor.

Dessa forma, os algoritmos podem detectar conversas que devem ser verificadas enquanto estão em andamento, e não depois, quando o dano ou abuso já pode ter ocorrido. Os algoritmos servem assim como um sinal de alerta.

Frio e cínico Bours analisou muitas conversas de bate-papo de logs antigos para desenvolver o algoritmo.

"Analisando essas conversas, aprendemos como esses homens 'preparam' os destinatários com elogios, presentes e outras lisonjas, para que revelem cada vez mais. É frio, cínico e cuidadosamente planejado", diz. "Revisar chats também faz parte do processo de aprendizado, para que possamos melhorar a IA e fazê-la reagir melhor no futuro."

"O perigo desse tipo de contato terminar em agressão é alto, principalmente se o agressor enviar o destinatário para outras plataformas com vídeo, por exemplo. Em uma situação ao vivo, o algoritmo marcaria esse chat como aquele que precisa ser monitorado ."

Análise em tempo real "O objetivo é expor um agressor o mais rápido possível", diz Bours.

"Se esperarmos que toda a conversa termine e os tagarelas já tenham feito acordos, pode ser tarde demais. O monitor também pode dizer à criança no chat que está falando com um adulto e não com outra criança."

A AiBA tem colaborado com empresas de jogos para instalar o algoritmo e está trabalhando com uma plataforma dinamarquesa de jogos e bate-papo chamada MoviestarPlanet, voltada para crianças e com 100 milhões de jogadores.

Ao desenvolver os algoritmos, o pesquisador descobriu que os usuários escrevem de forma diferente em diferentes plataformas, como Snapchat e TikTok.

"Temos que levar essas distinções em consideração quando treinamos o algoritmo. O mesmo com a linguagem. O serviço tem que ser desenvolvido para todos os tipos de linguagem", diz Bours.

Observando padrões de bate-papo Mais recentemente, Bours e seus colegas analisaram os padrões de bate-papo para ver quais padrões se desviam do que seria considerado normal.

“Analisamos os padrões de bate-papo – em vez de textos – de 2,5 milhões de bate-papos e conseguimos encontrar vários casos de aliciamento que não teriam sido detectados de outra forma”, disse Bours.

"Esta pesquisa inicial analisou os dados em retrospecto, mas atualmente estamos investigando como podemos usar isso em um sistema que segue esses padrões de bate-papo diretamente e pode tomar decisões imediatas para denunciar um usuário a um moderador", disse ele.

+ Explorar mais Microsoft procura detectar predadores sexuais em bate-papos de videogame