Crédito:Ji Lin

Smartphones, câmeras de segurança, e alto-falantes são apenas alguns dos dispositivos que em breve estarão executando mais softwares de inteligência artificial para acelerar as tarefas de processamento de imagem e fala. Uma técnica de compressão conhecida como quantização está suavizando o caminho, tornando os modelos de aprendizado profundo menores para reduzir os custos de computação e energia. Mas modelos menores, acontece que, tornar mais fácil para invasores mal-intencionados induzir um sistema de IA a se comportar mal - uma preocupação, pois a tomada de decisões mais complexas é transferida para as máquinas.

Em um novo estudo, Pesquisadores do MIT e da IBM mostram o quão vulneráveis são os modelos de IA compactados a ataques adversários, e eles oferecem uma solução:adicionar uma restrição matemática durante o processo de quantização para reduzir as chances de um AI ser vítima de uma imagem ligeiramente modificada e classificar incorretamente o que vê.

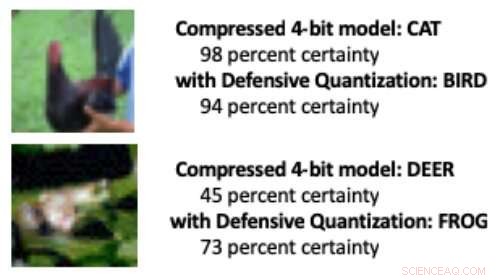

Quando um modelo de aprendizado profundo é reduzido dos 32 bits padrão para um comprimento de bit inferior, é mais provável que classifique incorretamente as imagens alteradas devido a um efeito de amplificação do erro:A imagem manipulada se torna mais distorcida com cada camada extra de processamento. No fim, é mais provável que o modelo confunda um pássaro com um gato, por exemplo, ou um sapo por um veado.

Modelos quantizados em 8 bits ou menos são mais suscetíveis a ataques adversários, os pesquisadores mostram, com a precisão caindo de 30-40 por cento já baixos para menos de 10 por cento conforme a largura dos bits diminui. Mas controlar a restrição de Lipschitz durante a quantização restaura alguma resiliência. Quando os pesquisadores adicionaram a restrição, eles viram pequenos ganhos de desempenho em um ataque, com os modelos menores, em alguns casos, superando o modelo de 32 bits.

Quando alguns pixels foram manipulados nas imagens acima para simular um ataque adversário, um modelo compactado padrão classificou erroneamente o frango como "gato" e o sapo como "veado". Mas quando os pesquisadores adicionaram uma restrição durante a compressão, o modelo classificou corretamente os animais, mesmo tendo um desempenho melhor do que um modelo de 32 bits de precisão total. Crédito:Massachusetts Institute of Technology

"Nossa técnica limita a amplificação de erros e pode até mesmo tornar os modelos de aprendizagem profunda compactados mais robustos do que os modelos de precisão total, "diz Song Han, professor assistente do Departamento de Engenharia Elétrica e Ciência da Computação do MIT e membro dos Laboratórios de Tecnologia de Microsistemas do MIT. "Com a quantização adequada, podemos limitar o erro. "

A equipe planeja melhorar ainda mais a técnica, treinando-a em conjuntos de dados maiores e aplicando-a a uma gama mais ampla de modelos. "Os modelos de aprendizagem profunda precisam ser rápidos e seguros à medida que se movem para um mundo de dispositivos conectados à Internet, "diz o co-autor do estudo Chuang Gan, pesquisador do MIT-IBM Watson AI Lab. "Nossa técnica de Quantização Defensiva ajuda em ambas as frentes."

Os pesquisadores, que incluem o estudante de pós-graduação do MIT Ji Lin, apresentar seus resultados na Conferência Internacional sobre Representações de Aprendizagem em maio.

Ao tornar os modelos de IA menores para que funcionem mais rápido e usem menos energia, Han está usando a própria IA para expandir os limites da tecnologia de compressão de modelos. Em trabalhos recentes relacionados, Han e seus colegas mostram como o aprendizado por reforço pode ser usado para encontrar automaticamente o menor comprimento de bit para cada camada em um modelo quantizado com base na rapidez com que o dispositivo que executa o modelo pode processar imagens. Esta abordagem de largura de bits flexível reduz a latência e o uso de energia em até 200 por cento em comparação com um Modelo de 8 bits, disse Han. Os pesquisadores apresentarão seus resultados na conferência Computer Vision and Pattern Recognition em junho.

Esta história foi republicada por cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisas do MIT, inovação e ensino.