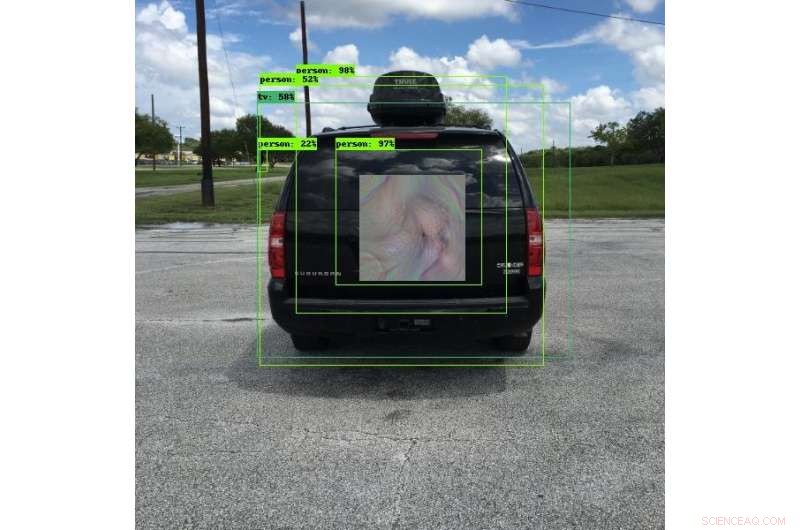

Muitos dos veículos de hoje usam sistemas de detecção de objetos para ajudar a evitar colisões. Os engenheiros do SwRI desenvolveram padrões únicos que podem enganar esses sistemas para ver algo diferente, ver os objetos em outro local ou não ver os objetos de forma alguma. Nessa foto, o sistema de detecção de objetos vê uma pessoa em vez de um veículo. Esta pesquisa permitirá que os engenheiros testem completamente os sistemas de detecção de objetos e melhorem a segurança dos algoritmos de aprendizado profundo que usam. Crédito:Southwest Research Institute

Novas técnicas adversárias desenvolvidas por engenheiros do Southwest Research Institute podem tornar os objetos "invisíveis" para sistemas de detecção de imagens que usam algoritmos de aprendizado profundo. Essas técnicas também podem induzir os sistemas a pensar que veem outro objeto ou podem alterar a localização dos objetos. A técnica reduz o risco de comprometimento em sistemas de processamento automatizado de imagens.

"Redes neurais de aprendizado profundo são altamente eficazes em muitas tarefas, "diz o engenheiro de pesquisa Abe Garza da SwRI Intelligent Systems Division." No entanto, o aprendizado profundo foi adotado tão rapidamente que as implicações de segurança desses algoritmos não foram totalmente consideradas. "

Os algoritmos de aprendizagem profunda se destacam no uso de formas e cores para reconhecer as diferenças entre humanos e animais ou carros e caminhões, por exemplo. Esses sistemas detectam objetos de forma confiável sob uma série de condições e, Como tal, são usados em inúmeras aplicações e indústrias, frequentemente para usos críticos de segurança. A indústria automotiva usa sistemas de detecção de objetos de aprendizagem profunda em rodovias para assistência na faixa, tecnologias de saída de faixa e prevenção de colisões. Esses veículos contam com câmeras para detectar objetos potencialmente perigosos ao seu redor. Embora os sistemas de processamento de imagem sejam vitais para proteger vidas e propriedades, os algoritmos podem ser enganados por partes com a intenção de causar danos.

Pesquisadores de segurança que trabalham com "aprendizado adversário" estão encontrando e documentando vulnerabilidades em algoritmos de aprendizado de máquina profundo e outros. Usando fundos de pesquisa internos do SwRI, Garza e o engenheiro de pesquisa sênior David Chambers desenvolveram o que parece ser futurístico, Padrões de estilo boêmio. Quando usado por uma pessoa ou montado em um veículo, os padrões enganam as câmeras de detecção de objetos fazendo-as pensar que os objetos não estão lá, que são outra coisa ou que estão em outro local. Partes maliciosas podem colocar esses padrões perto de estradas, potencialmente criando caos para veículos equipados com detectores de objetos.

O que parece um padrão colorido ao olho humano parece uma bicicleta para um sistema de detecção de objetos. Embora os algoritmos de aprendizado profundo usados nesses sistemas sejam confiáveis, eles podem ser enganados com imagens especiais. Os pesquisadores do SwRI estão desenvolvendo técnicas para mitigar o risco de comprometimento desses sistemas. Crédito:Southwest Research Institute

"Esses padrões fazem com que os algoritmos da câmera classifiquem ou localizem incorretamente os objetos, criando uma vulnerabilidade, "disse Garza." Chamamos esses padrões de 'percepção invariante' de exemplos adversários porque eles não precisam cobrir todo o objeto ou estar paralelos à câmera para enganar o algoritmo. Os algoritmos podem classificar incorretamente o objeto, desde que detectem alguma parte do padrão. "

Embora possam parecer exibições únicas e coloridas de arte ao olho humano, esses padrões são projetados de forma que os sistemas de câmeras de detecção de objetos os vejam de maneira muito específica. Um padrão disfarçado de anúncio na parte traseira de um ônibus parado pode fazer um sistema anti-colisão pensar que vê uma sacola de compras inofensiva em vez do ônibus. Se a câmera do veículo falhar em detectar o objeto verdadeiro, poderia continuar avançando e atingir o ônibus, causando uma colisão potencialmente séria.

"A primeira etapa para resolver essas explorações é testar os algoritmos de aprendizado profundo, "disse Garza. A equipe criou uma estrutura capaz de testar repetidamente esses ataques contra uma variedade de programas de detecção de aprendizagem profunda, o que será extremamente útil para testar soluções.

Os pesquisadores do SwRI continuam avaliando quanto, ou quão pouco, do padrão é necessário para classificar incorretamente ou alocar incorretamente um objeto. Trabalhando com clientes, esta pesquisa permitirá que a equipe teste sistemas de detecção de objetos e, em última análise, melhore a segurança dos algoritmos de aprendizado profundo.