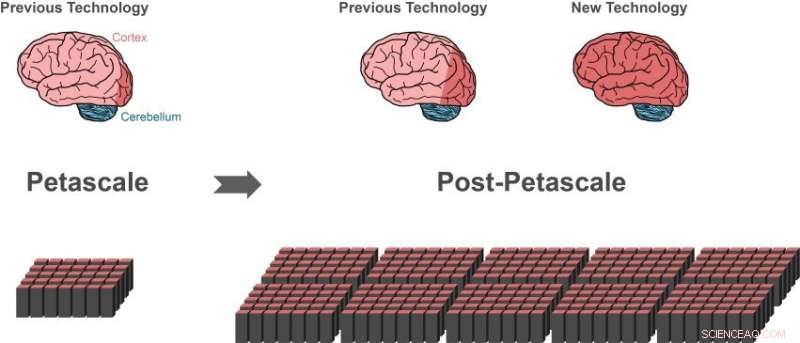

A tecnologia de simulação anterior pode representar cerca de 1 por cento das células nervosas (neurônios) em um cérebro humano (área vermelha escura do cérebro à esquerda) usando um supercomputador petascale (canto inferior esquerdo). Apenas um pequeno progresso (área vermelha escura do centro do cérebro) seria possível na próxima geração de supercomputadores que excederão o desempenho dos supercomputadores de ponta de hoje em 10 a 100 vezes. Partes maiores do cérebro humano podem ser representadas com a nova tecnologia, usando a mesma quantidade de memória do computador (canto inferior direito) .i 10 por cento do cérebro têm aproximadamente o tamanho de todo o córtex (área vermelha escura do cérebro à direita), o que é essencial para um processamento superior. Uma grande parte dos outros neurônios estão no cerebelo (azul). Crédito:Forschungszentrum Jülich

Um grupo internacional de pesquisadores deu um passo decisivo para criar a tecnologia para realizar simulações de redes em escala cerebral em futuros supercomputadores da classe exascale. A descoberta, publicado em Fronteiras em Neuroinformática , permite que partes maiores do cérebro humano sejam representadas, usando a mesma quantidade de memória do computador. Simultaneamente, o novo algoritmo acelera significativamente as simulações cerebrais em supercomputadores existentes.

O cérebro humano é um órgão de incrível complexidade, composto por 100 bilhões de células nervosas interconectadas. Contudo, mesmo com a ajuda dos supercomputadores mais poderosos disponíveis, atualmente é impossível simular a troca de sinais neuronais em redes desse tamanho.

"Desde 2014, nosso software pode simular cerca de um por cento dos neurônios do cérebro humano com todas as suas conexões, "diz Markus Diesmann, Diretor do Instituto Jülich de Neurociências e Medicina (INM-6). Para alcançar este feito impressionante, o software requer toda a memória principal dos supercomputadores petascale, como o computador K em Kobe e JUQUEEN em Jülich.

Diesmann trabalha há mais de 20 anos no software de simulação NEST - um software gratuito código de simulação de código aberto amplamente utilizado pela comunidade neurocientífica e um simulador central do European Human Brain Project, onde lidera projetos nas áreas de Neurociências Teóricas e na Plataforma de Análise e Computação de Alto Desempenho.

Com NEST, o comportamento de cada neurônio na rede é representado por um punhado de equações matemáticas. Computadores exascale do futuro, como o computador pós-K planejado em Kobe e JUWELS em Jülich, excederá o desempenho dos supercomputadores de ponta de hoje em 10 a 100 vezes. Pela primeira vez, os pesquisadores terão o poder do computador disponível para simular redes neuronais na escala do cérebro humano.

Aparentemente um beco sem saída

Embora a tecnologia de simulação atual tenha permitido aos pesquisadores começar a estudar grandes redes neuronais, também representou um beco sem saída no caminho para a tecnologia exascale. Os supercomputadores são compostos por cerca de 100, 000 pequenos computadores, chamados nós, cada um equipado com vários processadores que fazem os cálculos reais.

"Antes que uma simulação de rede neuronal possa ocorrer, neurônios e suas conexões precisam ser criados virtualmente, o que significa que eles precisam ser instanciados na memória dos nós. Durante a simulação, um neurônio não sabe em qual dos nós possui neurônios-alvo, Portanto, seus curtos pulsos elétricos precisam ser enviados a todos os nós. Cada nó verifica quais de todos esses pulsos elétricos são relevantes para os neurônios virtuais que existem neste nó, "explica Susanne Kunkel do KTH Royal Institute of Technology em Estocolmo.

O algoritmo atual para criação de rede é eficiente porque todos os nós constroem sua parte particular da rede ao mesmo tempo. No entanto, o envio de todos os pulsos elétricos para todos os nós não é adequado para simulações em sistemas exascale.

"Verificar a relevância de cada pulso elétrico de forma eficiente requer um bit de informação por processador para cada neurônio em toda a rede. Para uma rede de 1 bilhão de neurônios, uma grande parte da memória em cada nó é consumida por apenas este único bit de informação por neurônio, "acrescenta Markus Diesmann.

Este é o principal problema ao simular redes ainda maiores:a quantidade de memória do computador necessária por processador para os bits extras por neurônio aumenta com o tamanho da rede neuronal. Na escala do cérebro humano, isso exigiria que a memória disponível para cada processador fosse 100 vezes maior do que os supercomputadores de hoje. Esse, Contudo, é improvável que seja o caso na próxima geração de supercomputadores. O número de processadores por nó de computação aumentará, mas a memória por processador e o número de nós de computação permanecerão os mesmos.

Avanço por novo algoritmo

A descoberta publicada em Fronteiras em Neuroinformática é uma nova maneira de construir a rede neuronal no supercomputador. Devido aos algoritmos, a memória necessária em cada nó não aumenta mais com o tamanho da rede. No início da simulação, a nova tecnologia permite que os nós troquem informações sobre quem precisa enviar dados de atividade neuronal para quem. Assim que esse conhecimento estiver disponível, a troca de dados de atividade neuronal entre os nós pode ser organizada de modo que um nó receba apenas as informações de que necessita. Um bit adicional para cada neurônio na rede não é mais necessário.

Um efeito colateral benéfico

Ao testar suas novas ideias, os cientistas fizeram um insight adicional importante, relata Susanne Kunkel:"Ao analisar os novos algoritmos, percebemos que nossa nova tecnologia não permitiria apenas simulações em sistemas exascale, mas também tornaria as simulações mais rápidas nos supercomputadores disponíveis atualmente. "

Na verdade, como o consumo de memória agora está sob controle, a velocidade das simulações passa a ser o foco principal de novos desenvolvimentos tecnológicos. Por exemplo, uma grande simulação de 0,52 bilhões de neurônios conectados por 5,8 trilhões de sinapses rodando no supercomputador JUQUEEN em Jülich anteriormente exigia 28,5 minutos para computar um segundo de tempo biológico. Com a simulação de estruturas de dados aprimorada, o tempo é reduzido para 5,2 minutos.

"Com a nova tecnologia, podemos explorar o maior paralelismo dos microprocessadores modernos muito melhor do que antes, que se tornará ainda mais importante em computadores exascale, "comenta Jakob Jordan, autor principal do estudo, de Forschungszentrum Jülich.

"A combinação de hardware exascale e software apropriado traz investigações de aspectos fundamentais da função cerebral, como a plasticidade e o aprendizado se desdobrando ao longo de minutos de tempo biológico ao nosso alcance, "acrescenta Markus Diesmann.

Com um dos próximos lançamentos do software de simulação NEST, os pesquisadores disponibilizarão suas realizações gratuitamente para a comunidade como código aberto.

"Temos usado o NEST para simular a dinâmica complexa dos circuitos dos gânglios basais na saúde e na doença de Parkinson no computador K. Estamos ansiosos para saber as novidades sobre a nova geração do NEST, que nos permitirá executar simulações em escala de todo o cérebro no computador pós-K para esclarecer os mecanismos neurais de controle motor e funções mentais, "diz Kenji Doya do Instituto de Ciência e Tecnologia de Okinawa (OIST).

“O estudo é um exemplo maravilhoso da colaboração internacional no esforço de construção de computadores exascale. É importante que tenhamos aplicativos prontos que possam usar essas preciosas máquinas desde o primeiro dia em que estiverem disponíveis, "conclui Mitsuhisa Sato do RIKEN Advanced Institute for Computer Science em Kobe.