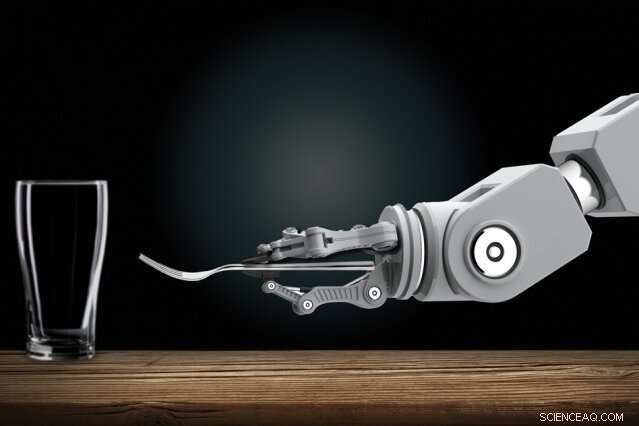

Os roboticistas estão desenvolvendo robôs automatizados que podem aprender novas tarefas apenas observando os humanos. Em casa, algum dia você poderá mostrar a um robô doméstico como fazer tarefas rotineiras. Crédito:Christine Daniloff, MIT

Treinar robôs interativos pode um dia ser uma tarefa fácil para todos, mesmo aqueles sem experiência em programação. Os roboticistas estão desenvolvendo robôs automatizados que podem aprender novas tarefas apenas observando os humanos. Em casa, você pode algum dia mostrar a um robô doméstico como fazer tarefas rotineiras. No local de trabalho, você pode treinar robôs como novos funcionários, mostrando-lhes como realizar muitas funções.

Fazendo progresso nessa visão, Os pesquisadores do MIT desenvolveram um sistema que permite que esses tipos de robôs aprendam tarefas complicadas que, de outra forma, os impediriam com muitas regras confusas. Uma dessas tarefas é preparar uma mesa de jantar sob certas condições.

Em seu núcleo, o sistema "Planejamento com especificações incertas" (PUnS) dos pesquisadores dá aos robôs a capacidade de planejamento semelhante à humana para avaliar simultaneamente muitos requisitos ambíguos - e potencialmente contraditórios - para atingir um objetivo final. Ao fazer isso, o sistema sempre escolhe a ação mais provável a ser tomada, baseado em uma "crença" sobre algumas especificações prováveis para a tarefa que ele deve realizar.

Em seu trabalho, os pesquisadores compilaram um conjunto de dados com informações sobre como oito objetos - uma caneca, copo, colher, garfo, faca, prato de jantar, Prato pequeno, e tigela - podem ser colocados em uma mesa em várias configurações. Um braço robótico observou pela primeira vez demonstrações humanas selecionadas aleatoriamente de pôr a mesa com os objetos. Então, os pesquisadores encarregaram o braço de definir automaticamente uma mesa em uma configuração específica, em experimentos do mundo real e em simulação, com base no que tinha visto.

Ter sucesso, o robô teve que pesar muitos pedidos de colocação possíveis, mesmo quando os itens foram removidos propositalmente, empilhado, ou escondido. Normalmente, tudo isso confundiria muito os robôs. Mas o robô dos pesquisadores não cometeu erros em vários experimentos do mundo real, e apenas um punhado de erros em dezenas de milhares de execuções de testes simulados.

"A visão é colocar a programação nas mãos de especialistas no domínio, quem pode programar robôs de maneiras intuitivas, em vez de descrever pedidos para um engenheiro adicionar ao seu código, "diz o primeiro autor Ankit Shah, um aluno de pós-graduação no Departamento de Aeronáutica e Astronáutica (AeroAstro) e no Grupo de Robótica Interativa, que enfatiza que seu trabalho é apenas uma etapa para cumprir essa visão. "Dessa maneira, os robôs não precisarão mais realizar tarefas pré-programadas. Os trabalhadores da fábrica podem ensinar um robô a realizar várias tarefas de montagem complexas. Robôs domésticos podem aprender como empilhar armários, Carregue a lavadora de louças, ou arrumar a mesa com as pessoas de casa. "

Juntando-se a Shah no trabalho estão a AeroAstro e o aluno de graduação do Interactive Robotics Group Shen Li e a líder do Interactive Robotics Group, Julie Shah, professor associado da AeroAstro e do Laboratório de Ciência da Computação e Inteligência Artificial.

Apostas de hedging de bots

Os robôs são bons planejadores em tarefas com especificações "claras, "que ajudam a descrever a tarefa que o robô precisa cumprir, considerando suas ações, ambiente, e objetivo final. Aprender a pôr a mesa observando as demonstrações, está cheio de especificações incertas. Os itens devem ser colocados em determinados locais, dependendo do menu e de onde os convidados estão sentados, e em certas ordens, dependendo da disponibilidade imediata de um item ou convenções sociais. As abordagens atuais de planejamento não são capazes de lidar com tais especificações incertas.

Uma abordagem popular de planejamento é o "aprendizado por reforço, "uma técnica de aprendizado de máquina de tentativa e erro que os recompensa e penaliza por ações enquanto trabalham para concluir uma tarefa. Mas, para tarefas com especificações incertas, é difícil definir recompensas e penalidades claras. Resumidamente, os robôs nunca aprendem totalmente o certo e o errado.

O sistema dos pesquisadores, chamado PUnS (para planejamento com especificações incertas), permite que um robô mantenha uma "crença" sobre uma gama de especificações possíveis. A própria crença pode então ser usada para distribuir recompensas e penalidades. "O robô está essencialmente protegendo suas apostas em termos do que é pretendido em uma tarefa, e realiza ações que satisfaçam sua crença, em vez de darmos uma especificação clara, "Ankit Shah diz.

O sistema é construído em "lógica temporal linear" (LTL), uma linguagem expressiva que permite o raciocínio robótico sobre os resultados atuais e futuros. Os pesquisadores definiram modelos em LTL que modelam várias condições baseadas no tempo, como o que deve acontecer agora, deve eventualmente acontecer, e deve acontecer até que algo mais ocorra. As observações do robô de 30 demonstrações humanas para colocar a mesa produziram uma distribuição de probabilidade em 25 fórmulas LTL diferentes. Cada fórmula codificou uma preferência ligeiramente diferente - ou especificação - para definir a tabela. Essa distribuição de probabilidade se torna sua crença.

"Cada fórmula codifica algo diferente, mas quando o robô considera várias combinações de todos os modelos, e tenta satisfazer tudo junto, acaba fazendo a coisa certa eventualmente, "Ankit Shah diz.

Seguindo critérios

Os pesquisadores também desenvolveram vários critérios que orientam o robô no sentido de satisfazer toda a crença sobre essas fórmulas candidatas. 1, por exemplo, satisfaz a fórmula mais provável, que descarta todo o resto, exceto o modelo com a maior probabilidade. Outros satisfazem o maior número de fórmulas exclusivas, sem considerar sua probabilidade geral, ou eles satisfazem várias fórmulas que representam a probabilidade total mais alta. Outro simplesmente minimiza o erro, portanto, o sistema ignora fórmulas com alta probabilidade de falha.

Os designers podem escolher qualquer um dos quatro critérios para predefinir antes de treinar e testar. Cada um tem sua própria compensação entre flexibilidade e aversão ao risco. A escolha dos critérios depende inteiramente da tarefa. Em situações críticas de segurança, por exemplo, a designer may choose to limit possibility of failure. But where consequences of failure are not as severe, designers can choose to give robots greater flexibility to try different approaches.

With the criteria in place, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, por exemplo, the robot would finish setting the rest of the table without the item. Então, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Próximo, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Esta história foi republicada por cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisas do MIT, inovação e ensino.