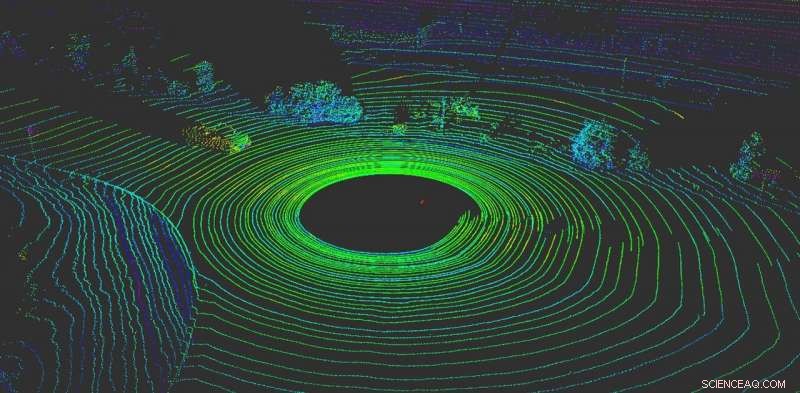

LiDAR ajuda um veículo autônomo a ‘visualizar’ o que está ao seu redor. Crédito:Yulong Can com dados do Baidu Apollo, CC BY-ND

Nada é mais importante para um veículo autônomo do que sentir o que está acontecendo ao seu redor. Como motoristas humanos, os veículos autônomos precisam ser capazes de tomar decisões instantâneas.

Hoje, a maioria dos veículos autônomos depende de vários sensores para perceber o mundo. A maioria dos sistemas usa uma combinação de câmeras, sensores de radar e sensores LiDAR (detecção e alcance de luz). A bordo, os computadores fundem esses dados para criar uma visão abrangente do que está acontecendo ao redor do carro. Sem esses dados, veículos autônomos não teriam esperança de navegar com segurança pelo mundo. Carros que usam sistemas de múltiplos sensores funcionam melhor e são mais seguros - cada sistema pode servir como um controle sobre os outros - mas nenhum sistema está imune a ataques.

Infelizmente, esses sistemas não são infalíveis. Os sistemas de percepção baseados em câmeras podem ser enganados simplesmente colocando adesivos nos sinais de trânsito para mudar completamente o seu significado.

Nosso trabalho, do Grupo de Pesquisa RobustNet da Universidade de Michigan, mostrou que o sistema de percepção baseado em LiDAR pode ser compreendido, também. Ao falsificar estrategicamente os sinais do sensor LiDAR, o ataque é capaz de enganar o sistema de percepção baseado em LiDAR do veículo, fazendo-o "ver" um obstáculo inexistente. Se isso acontecer, um veículo pode causar um acidente bloqueando o tráfego ou travando abruptamente.

Sinais LiDAR falsificados

Os sistemas de percepção baseados em LiDAR têm dois componentes:o sensor e o modelo de aprendizado de máquina que processa os dados do sensor. Um sensor LiDAR calcula a distância entre ele mesmo e seus arredores emitindo um sinal de luz e medindo quanto tempo leva para o sinal ricochetear em um objeto e retornar ao sensor. Essa duração desse vaivém também é conhecida como "tempo de vôo".

Uma unidade LiDAR envia dezenas de milhares de sinais de luz por segundo. Em seguida, seu modelo de aprendizado de máquina usa os pulsos retornados para pintar uma imagem do mundo ao redor do veículo. É semelhante a como um morcego usa a ecolocalização para saber onde estão os obstáculos à noite.

O problema é que esses pulsos podem ser falsificados. Para enganar o sensor, um invasor pode direcionar seu próprio sinal de luz para o sensor. Isso é tudo que você precisa para confundir o sensor.

Contudo, é mais difícil falsificar o sensor LiDAR para "ver" um "veículo" que não está lá. Ter sucesso, o atacante precisa cronometrar precisamente os sinais disparados contra a vítima LiDAR. Isso tem que acontecer no nível de nanossegundos, uma vez que os sinais viajam à velocidade da luz. Pequenas diferenças se destacam quando o LiDAR está calculando a distância usando o tempo de vôo medido.

Se um invasor conseguir enganar o sensor LiDAR, ele também precisa enganar o modelo de aprendizado de máquina. O trabalho realizado no laboratório de pesquisa OpenAI mostra que os modelos de aprendizado de máquina são vulneráveis a sinais ou entradas especialmente criados - conhecidos como exemplos adversários. Por exemplo, adesivos especialmente gerados em sinais de trânsito podem enganar a percepção baseada na câmera.

Descobrimos que um invasor poderia usar uma técnica semelhante para criar perturbações que funcionassem contra o LiDAR. Eles não seriam um adesivo visível, mas sinais falsificados especialmente criados para enganar o modelo de aprendizado de máquina e fazê-lo pensar que há obstáculos quando, na verdade, não há nenhum. O sensor LiDAR alimentará os sinais falsos do hacker para o modelo de aprendizado de máquina, que os reconhecerá como um obstáculo.

O exemplo adversário - o objeto falso - pode ser criado para atender às expectativas do modelo de aprendizado de máquina. Por exemplo, o invasor pode criar o sinal de um caminhão que não está se movendo. Então, para conduzir o ataque, eles podem configurá-lo em um cruzamento ou colocá-lo em um veículo que é conduzido na frente de um veículo autônomo.

Dois ataques possíveis

Para demonstrar o ataque projetado, escolhemos um sistema de direção autônomo usado por muitos fabricantes de automóveis:Baidu Apollo. Este produto tem mais de 100 parceiros e chegou a um acordo de produção em massa com vários fabricantes, incluindo Volvo e Ford.

Usando dados de sensores do mundo real coletados pela equipe Baidu Apollo, demonstramos dois ataques diferentes. Em primeiro, um "ataque de freio de emergência, "mostramos como um invasor pode parar repentinamente um veículo em movimento, induzindo-o a pensar que um obstáculo apareceu em seu caminho. Na segunda, um "ataque de congelamento AV, "usamos um obstáculo falsificado para enganar um veículo que havia sido parado em um semáforo vermelho para permanecer parado depois que o semáforo ficou verde.

Ao explorar as vulnerabilidades dos sistemas de percepção de direção autônomos, esperamos disparar um alarme para equipes que estão construindo tecnologias autônomas. A pesquisa sobre novos tipos de problemas de segurança nos sistemas de direção autônoma está apenas começando, e esperamos descobrir mais problemas possíveis antes que eles possam ser explorados na estrada por atores mal-intencionados.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.