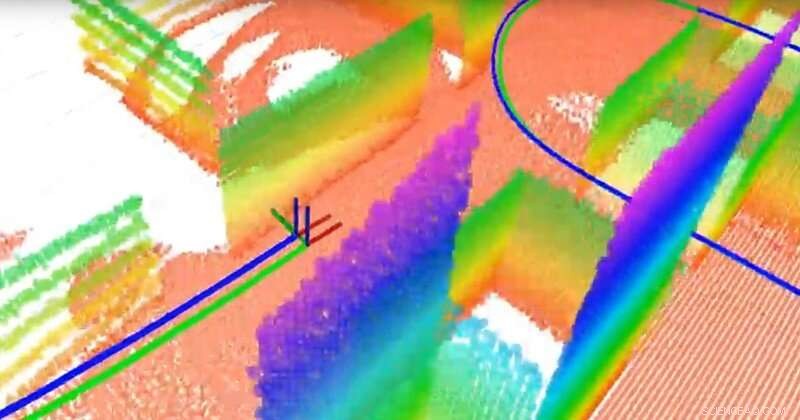

A equipe construiu um mapa baseado em planos 3-D usando um LiDAR 3-D e um sensor inercial. O LiDAR é como um radar, mas usa luz em vez de ondas de rádio. Os pontos com cores diferentes são os planos diferentes (que servem como marcos para a navegação), a linha verde é a trajetória verdadeira e a linha azul é a trajetória estimada calculada pelo algoritmo de localização e mapeamento simultâneo (SLAM) da equipe. Crédito:University of Delaware

Cientistas de todo o mundo estão correndo para desenvolver veículos autônomos, mas alguns componentes essenciais ainda precisam ser aperfeiçoados. Um é a localização - a capacidade do veículo de determinar seu lugar e movimento. Outra é o mapeamento - a capacidade dos veículos de modelar seus arredores para que possam transportar passageiros com segurança ao lugar certo.

A questão é:como você dá a um veículo um senso de direção? Embora os dispositivos de posicionamento global por satélite (GPS) possam ajudar, eles não estão disponíveis ou não são confiáveis em todos os contextos. Em vez de, muitos especialistas estão investigando localização e mapeamento simultâneos, ou SLAM, um problema notoriamente difícil no campo da robótica. Novos algoritmos desenvolvidos por Guoquan (Paul) Huang, um professor assistente de engenharia mecânica, engenharia elétrica e informática, e ciências da computação e da informação na Universidade de Delaware, estão trazendo a resposta mais perto da vista.

Huang usa sistemas de navegação visual inercial que combinam sensores inerciais, que contêm giroscópios para determinar a orientação e acelerômetros para determinar a aceleração, junto com câmeras. Usando dados relativamente baratos, componentes amplamente disponíveis, Huang mede e calcula o movimento e a localização.

Por exemplo, quando sua equipe conectou seu sistema a um laptop e o carregou pelo Laboratório Spencer da UD, casa do Departamento de Engenharia Mecânica, eles geraram dados suficientes para mapear o edifício enquanto rastreiam o movimento do próprio laptop. Em um veículo autônomo, sensores e câmeras semelhantes seriam acoplados a um robô no veículo.

A capacidade de um veículo autônomo de rastrear seu próprio movimento e o movimento dos objetos ao seu redor é crítica. "Precisamos localizar o veículo antes de controlá-lo automaticamente, "disse Huang." O veículo precisa saber sua localização para continuar. "

Depois, há a questão da segurança. “Em um cenário urbano, por exemplo, existem pedestres e outros veículos, então, idealmente, o veículo deve ser capaz de rastrear seu próprio movimento, bem como o movimento de objetos em movimento em seus arredores, "disse Huang.

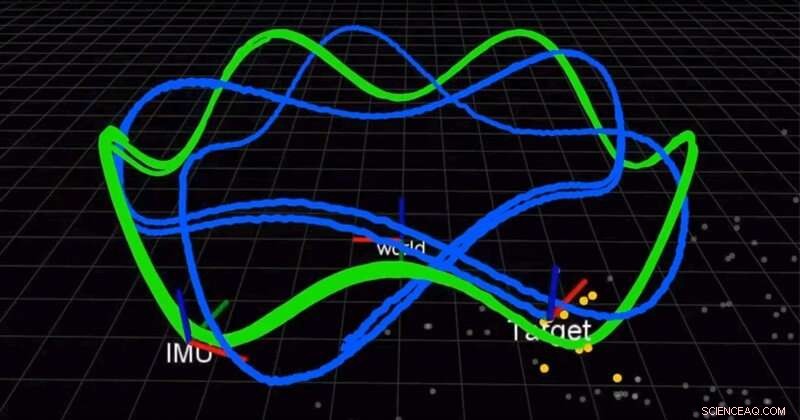

A equipe usa uma câmera e uma unidade de medição inercial (IMU) para localizar simultaneamente um robô e rastrear um alvo em movimento. A linha verde é a trajetória do robô e a linha azul é a trajetória do alvo. Crédito:University of Delaware

Em um artigo publicado no início deste ano no International Journal of Robotics Research (IJRR), Huang e sua equipe encontraram um melhor, solução mais precisa para combinar as medições inerciais. Até agora, cientistas usaram integração discreta, uma técnica de cálculo que aproxima a área sob uma curva, para aproximar a solução. Em vez de, O grupo de Huang encontrou uma solução e provou que era melhor do que os métodos existentes. Melhor ainda, eles estão compartilhando sua solução.

"Abrimos o código do nosso código. Está no GitHub, "disse Huang." Muitas pessoas têm usado nosso código em seus sistemas. "Em outro artigo recente do IJRR, Huang e sua equipe reformularam o problema SLAM como uma fórmula que calcula pequenos incrementos de movimento dos robôs equipados com os sensores visuais e inerciais. Muitos desses vídeos de pesquisa podem ser encontrados no canal do YouTube do Huang's Lab.

Essas descobertas podem ter aplicações além de veículos autônomos, de carros a drones aéreos, embarcações subaquáticas e muito mais. Os algoritmos de Huang também podem ser usados para desenvolver aplicativos de realidade aumentada e realidade virtual para dispositivos móveis, como smartphones, que já possuem câmeras e sensores inerciais a bordo.

“Esses sensores são muito comuns, então, a maioria dos dispositivos móveis, smartphones, até drones e veículos têm esses sensores, "disse Huang." Tentamos aproveitar os sensores baratos existentes e fornecer uma solução de localização, uma solução de rastreamento de movimento. "

Em 2018 e novamente em 2019, Huang recebeu um prêmio de pesquisa do corpo docente do Google Daydream (AR / VR) para apoiar este trabalho.

"As pessoas veem que os robôs serão a próxima grande novidade na vida real, então é por isso que a indústria impulsiona muito este campo de pesquisa, "disse Huang.