Um banner dizendo "O Estado Islâmico" é exibido na página do Facebook de um usuário que se identifica como Nawan Al-Farancsa. A página ainda estava no ar na terça-feira, 7 de maio, 2019, quando a captura de tela foi feita. O Facebook diz que possui sistemas robustos para remover conteúdo de grupos extremistas, mas a reclamação de um denunciante selado analisada pela AP diz que o conteúdo proibido permanece na web e é fácil de encontrar. (Facebook via AP)

O vídeo animado começa com uma foto das bandeiras negras da jihad. Segundos depois, ele mostra os destaques de um ano de postagens nas redes sociais:placas de versos anti-semitas, falam de retribuição e uma foto de dois homens carregando mais bandeiras da jihad enquanto queimam as estrelas e listras.

Não foi produzido por extremistas; foi criado pelo Facebook. Em uma ação inteligente de autopromoção, o gigante da mídia social pega um ano do conteúdo do usuário e gera automaticamente um vídeo comemorativo. Nesse caso, o usuário se autodenominou "Abdel-Rahim Moussa, o califado. "

"Obrigado por estar aqui, do Facebook, "o vídeo termina em uma bolha de desenho animado antes de mostrar o famoso" polegar para cima "da empresa.

O Facebook gosta de dar a impressão de que está ficando à frente dos extremistas retirando suas postagens, muitas vezes antes que os usuários os vejam. Mas a reclamação de um denunciante confidencial à Securities and Exchange Commission obtida pela The Associated Press alega que a empresa de mídia social exagerou seu sucesso. Pior ainda, isso mostra que a empresa está inadvertidamente fazendo uso de propaganda de grupos militantes para gerar automaticamente vídeos e páginas que poderiam ser usados para networking por extremistas.

De acordo com a reclamação, ao longo de um período de cinco meses no ano passado, pesquisadores monitoraram páginas de usuários que se afiliaram a grupos que o Departamento de Estado dos EUA designou como organizações terroristas. Naquele período, 38% das postagens com símbolos proeminentes de grupos extremistas foram removidos. Em sua própria revisão, a AP descobriu que a partir deste mês, muito do conteúdo banido citado no estudo - um vídeo de execução, imagens de cabeças decepadas, propaganda em homenagem a militantes martirizados - escapou da web algorítmica e permaneceu fácil de encontrar no Facebook.

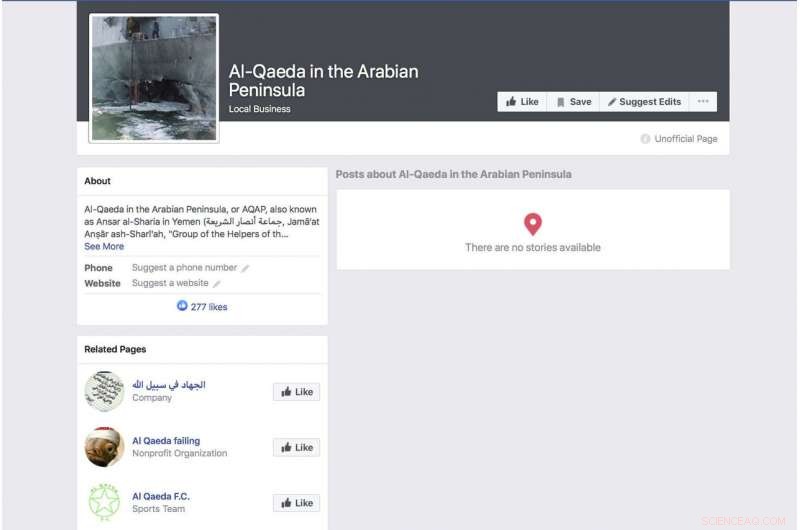

Uma página gerada automaticamente no Facebook para um grupo que se identifica como o grupo terrorista "Al-Qaeda na Península Arábica" exibe uma foto do navio de guerra USS Cole da Marinha dos EUA bombardeado. A página ainda estava ativa na terça-feira, 7 de maio, 2019, quando a captura de tela foi feita. O Facebook diz que possui sistemas robustos para remover conteúdo de grupos extremistas, mas a reclamação de um denunciante lacrado analisada pela AP diz que o conteúdo proibido permanece na web e é fácil de encontrar. (Facebook via AP)

A reclamação está chegando enquanto o Facebook tenta se manter à frente de uma crescente variedade de críticas sobre suas práticas de privacidade e sua capacidade de manter o discurso de ódio, assassinatos e suicídios transmitidos ao vivo fora de seu serviço. Diante das críticas, O CEO Mark Zuckerberg falou de seu orgulho na capacidade da empresa de eliminar postagens violentas automaticamente por meio da inteligência artificial. Durante uma teleconferência de resultados no mês passado, por exemplo, ele repetiu uma formulação cuidadosamente formulada que o Facebook vem empregando.

"Em áreas como o terrorismo, para conteúdo relacionado à Al Qaeda e ISIS, agora 99 por cento do conteúdo que removemos na categoria nossos sistemas sinalizam proativamente antes que alguém o veja, "disse ele. Em seguida, acrescentou:" Isso é o que realmente parece bom. "

Zuckerberg não ofereceu uma estimativa de quanto do total do material proibido está sendo removido.

A pesquisa por trás da reclamação da SEC visa apontar falhas gritantes na abordagem da empresa. Ano passado, pesquisadores começaram a monitorar usuários que se identificaram explicitamente como membros de grupos extremistas. Não foi difícil documentar. Algumas dessas pessoas até listam os grupos extremistas como seus empregadores. Um perfil anunciado pela bandeira negra de um grupo afiliado à Al Qaeda listava seu empregador, talvez jocosamente, como Facebook. O perfil que incluía o vídeo gerado automaticamente com a bandeira queimando também tinha um vídeo do líder da Al Qaeda, Ayman al-Zawahiri, pedindo aos grupos jihadistas que não lutassem entre si.

Embora o estudo esteja longe de ser abrangente, em parte porque o Facebook raramente disponibiliza muitos de seus dados publicamente, os pesquisadores envolvidos no projeto dizem que a facilidade de identificar esses perfis usando uma pesquisa básica de palavras-chave e o fato de que tão poucos deles foram removidos sugerem que as afirmações do Facebook de que seus sistemas captam a maior parte do conteúdo extremista não são precisas.

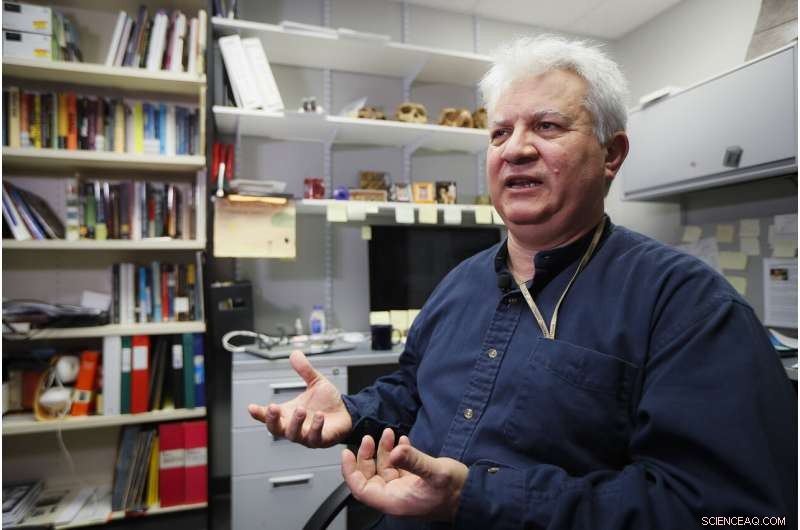

Amr Al Azm, professor de História e Antropologia do Oriente Médio na Shawnee State University, fala em seu escritório em 25 de abril, 2019, em Portsmouth, Ohio. O Facebook dá a impressão de que está interrompendo a grande maioria das postagens extremistas antes que os usuários as vejam. Mas a reclamação de um denunciante confidencial à Securities and Exchange Commission obtida pela The Associated Press alega que a empresa de mídia social exagerou seu sucesso. "Quero dizer, isso é apenas forçar a imaginação para além da incredulidade, " diz, Al Azm um dos pesquisadores envolvidos no projeto. "Se um pequeno grupo de pesquisadores pode encontrar centenas de páginas de conteúdo por meio de pesquisas simples, por que uma empresa gigante com todos os seus recursos não pode fazer isso? "(AP Photo / John Minchillo)

"Quero dizer, isso é apenas expandir a imaginação para além da incredulidade, "diz Amr Al Azm, um dos pesquisadores envolvidos no projeto. "Se um pequeno grupo de pesquisadores pode encontrar centenas de páginas de conteúdo por meio de pesquisas simples, por que uma empresa gigante não pode fazer isso? "

Al Azm, professor de história e antropologia na Shawnee State University em Ohio, também dirigiu um grupo na Síria que documenta o saque e o contrabando de antiguidades.

O Facebook admite que seus sistemas não são perfeitos, mas diz que está fazendo melhorias.

"Depois de fazer grandes investimentos, estamos detectando e removendo conteúdo de terrorismo com uma taxa de sucesso muito maior do que há dois anos, ", disse a empresa em um comunicado." Não afirmamos encontrar tudo e continuamos vigilantes em nossos esforços contra grupos terroristas em todo o mundo. "

Reagindo aos relatórios do AP, Rep. Bennie Thompson, D-Miss., o presidente do Comitê de Segurança Interna da Câmara expressou frustração com o fato de o Facebook ter feito tão pouco progresso no bloqueio de conteúdo, apesar das garantias que recebeu da empresa.

Uma página do Facebook para o usuário Ramadan Kareem, que, quando traduzido para o inglês, lista o usuário como trabalhando no "Estado Islâmico em Sham e Iraque". A página ainda estava no ar na terça-feira, 7 de maio, 2019, quando a captura de tela foi feita. O Facebook diz que possui sistemas robustos para remover conteúdo de grupos extremistas, mas a reclamação de um denunciante lacrado analisada pela AP diz que o conteúdo proibido permanece na web e é fácil de encontrar. (Facebook via AP)

"Este é mais um exemplo profundamente preocupante da incapacidade do Facebook de gerenciar suas próprias plataformas - e até que ponto ele precisa limpar sua atuação, "disse ele." O Facebook não deve apenas livrar suas plataformas de conteúdo terrorista e extremista, mas também precisa ser capaz de evitar que seja amplificado. "

Mas como uma indicação clara da facilidade com que os usuários podem escapar do Facebook, uma página de um usuário chamado "Nawan al-Farancsa" tem um cabeçalho cujas letras brancas contra um fundo preto dizem em inglês "O Estado Islâmico". O banner é pontuado com a foto de uma nuvem explosiva em forma de cogumelo subindo de uma cidade.

O perfil deveria ter chamado a atenção do Facebook - bem como de agências de contra-inteligência. Foi criado em junho de 2018, lista o usuário como vindo da Chechênia, outrora um ponto de acesso militante. Diz que ele morava em Heidelberg, Alemanha, e estudou em uma universidade na Indonésia. Alguns dos amigos do usuário também postaram conteúdo militante.

A página, ainda acordado nos últimos dias, aparentemente escapou dos sistemas do Facebook, por causa de uma evasão de moderação óbvia e de longa data que o Facebook deveria ser adepto de reconhecer:as letras não eram texto pesquisável, mas embutidas em um bloco gráfico. Mas a empresa diz que sua tecnologia verifica o áudio, vídeo e texto - incluindo quando está incorporado - para imagens que refletem violência, armas ou logotipos de grupos proibidos.

O gigante das redes sociais passou por dois anos difíceis a partir de 2016, quando o uso da mídia social pela Rússia para interferir nas eleições presidenciais dos EUA entrou em foco. Zuckerberg inicialmente minimizou o papel que o Facebook desempenhou na operação de influência da inteligência russa, mas a empresa mais tarde se desculpou.

Uma página do Facebook para um usuário traduzida para o inglês como "Luzes da amargura", que lista o usuário como um médico no Estado Islâmico. A página ainda estava ativa na terça-feira, 7 de maio, 2019, quando a captura de tela foi feita. O Facebook diz que possui sistemas robustos para remover conteúdo de grupos extremistas, mas a reclamação de um denunciante analisada pela AP diz que o conteúdo proibido permanece na web e é fácil de encontrar. (Facebook via AP)

O Facebook diz que agora emprega 30, 000 pessoas que trabalham em suas práticas de proteção e segurança, revisar material potencialmente prejudicial e qualquer outra coisa que possa não pertencer ao site. Ainda, a empresa está colocando muita fé na inteligência artificial e na capacidade de seus sistemas de eventualmente eliminar coisas ruins sem a ajuda de humanos. A nova pesquisa sugere que a meta está longe e alguns críticos alegam que a empresa não está fazendo um esforço sincero.

Quando o material não é removido, é tratado da mesma forma que qualquer outra coisa postada pelos 2,4 bilhões de usuários do Facebook - celebrado em vídeos animados, vinculados, categorizados e recomendados por algoritmos.

Mas não são apenas os algoritmos que são os culpados. Os pesquisadores descobriram que alguns extremistas estão usando o "Frame Studio" do Facebook para postar propaganda militante. A ferramenta permite que as pessoas decorem suas fotos de perfil dentro de quadros gráficos - para apoiar causas ou celebrar aniversários, por exemplo. O Facebook diz que essas imagens emolduradas devem ser aprovadas pela empresa antes de serem publicadas.

Hany Farid, um especialista forense digital da Universidade da Califórnia, Berkeley, que assessora o Projeto Contra-Extremismo, um grupo baseado em Nova York e Londres focado no combate a mensagens extremistas, diz que o sistema de inteligência artificial do Facebook está falhando. Ele diz que a empresa não está motivada para enfrentar o problema porque seria caro.

"Toda a infraestrutura é fundamentalmente falha, "disse ele." E há muito pouco apetite para consertar porque o que o Facebook e outras empresas de mídia social sabem é que, uma vez que eles começam a ser responsáveis pelo material em suas plataformas, isso abre uma lata de vermes. "

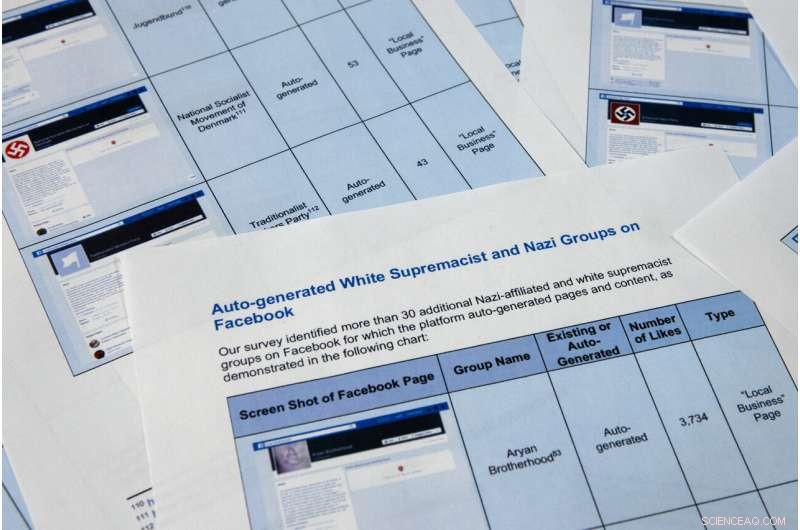

As páginas do relatório de um denunciante confidencial obtido pela The Associated Press são fotografadas na terça-feira, 7 de maio, 2019, em Washington. O Facebook gosta de dar a impressão de que está interrompendo a grande maioria das postagens extremistas antes que os usuários as vejam., mas a queixa do denunciante confidencial à Comissão de Valores Mobiliários alega que a empresa de mídia social exagerou seu sucesso. Pior ainda, mostra que a empresa está fazendo uso da propaganda de grupos militantes para gerar automaticamente vídeos e páginas que poderiam ser usados para networking por extremistas. (AP Photo / Jon Elswick)

As páginas do relatório de um denunciante confidencial obtido pela The Associated Press são fotografadas na terça-feira, 7 de maio, 2019, em Washington. O Facebook gosta de dar a impressão de que está interrompendo a grande maioria das postagens extremistas antes que os usuários as vejam., mas a reclamação do denunciante confidencial à Securities and Exchange Commission alega que a empresa de mídia social exagerou seu sucesso. Pior ainda, mostra que a empresa está fazendo uso da propaganda de grupos militantes para gerar automaticamente vídeos e páginas que poderiam ser usados para networking por extremistas. Os pesquisadores na reclamação da SEC identificaram mais de 30 páginas geradas automaticamente para grupos de supremacia branca, cujo conteúdo o Facebook proíbe. (AP Photo / Jon Elswick)

Neste 11 de abril, 2018, foto do arquivo, O CEO do Facebook, Mark Zuckerberg, testemunhou antes de uma audiência da House Energy and Commerce no Capitólio, em Washington. O Facebook dá a impressão de que está interrompendo a grande maioria das postagens extremistas antes que os usuários as vejam. Mas a reclamação de um denunciante confidencial à Securities and Exchange Commission obtida pela The Associated Press alega que a empresa de mídia social exagerou seu sucesso. (AP Photo / Andrew Harnik, Arquivo)

Outra função de geração automática do Facebook que deu errado retira informações de emprego das páginas do usuário para criar páginas de negócios. A função deve produzir páginas destinadas a ajudar a rede de empresas, mas em muitos casos eles estão servindo como um local de pouso de marca para grupos extremistas. A função permite que os usuários do Facebook curtam páginas de organizações extremistas, incluindo a Al Qaeda, o grupo do Estado Islâmico e o al-Shabab com base na Somália, efetivamente fornecendo uma lista de simpatizantes para os recrutadores.

At the top of an auto-generated page for al-Qaida in the Arabian Peninsula, the AP found a photo of the damaged hull of the USS Cole, which was bombed by al-Qaida in a 2000 attack off the coast of Yemen that killed 17 U.S. Navy sailors. It's the defining image in AQAP's own propaganda. The page includes the Wikipedia entry for the group and had been liked by 277 people when last viewed this week.

As part of the investigation for the complaint, Al Azm's researchers in Syria looked closely at the profiles of 63 accounts that liked the auto-generated page for Hay'at Tahrir al-Sham, a group that merged from militant groups in Syria, including the al-Qaida affiliated al-Nusra Front. The researchers were able to confirm that 31 of the profiles matched real people in Syria. Some of them turned out to be the same individuals Al Azm's team was monitoring in a separate project to document the financing of militant groups through antiquities smuggling.

Facebook also faces a challenge with U.S. hate groups. Em março, the company announced that it was expanding its prohibited content to also include white nationalist and white separatist content— previously it only took action with white supremacist content. It says that it has banned more than 200 white supremacist groups. But it's still easy to find symbols of supremacy and racial hatred.

The researchers in the SEC complaint identified over 30 auto-generated pages for white supremacist groups, whose content Facebook prohibits. They include "The American Nazi Party" and the "New Aryan Empire." A page created for the "Aryan Brotherhood Headquarters" marks the office on a map and asks whether users recommend it. One endorser posted a question:"How can a brother get in the house."

A Facebook page for an auto generated Facebook page for a local business, translated into English from Arabic, calling itself 'Islamic State in Sham and Iraq. The page was still live as of Tuesday, 7 de maio, 2019, when the screen grab was made. Facebook says it has robust systems in place to remove content from extremist groups, but a sealed whistleblower's complaint reviewed by the AP says banned content remains on the web and easy to find. (Facebook via AP)

Even supremacists flagged by law enforcement are slipping through the net. Following a sweep of arrests beginning in October, federal prosecutors in Arkansas indicted dozens of members of a drug trafficking ring linked to the New Aryan Empire. A legal document from February paints a brutal picture of the group, alleging murder, kidnapping and intimidation of witnesses that in one instance involved using a searing-hot knife to scar someone's face. It also alleges the group used Facebook to discuss New Aryan Empire business.

But many of the individuals named in the indictment have Facebook pages that were still up in recent days. They leave no doubt of the users' white supremacist affiliation, posting images of Hitler, swastikas and a numerical symbol of the New Aryan Empire slogan, "To The Dirt"—the members' pledge to remain loyal to the end. One of the group's indicted leaders, Jeffrey Knox, listed his job as "stomp down Honky." Facebook then auto-generated a "stomp down Honky" business page.

Social media companies have broad protection in U.S. law from liability stemming from the content that users post on their sites. But Facebook's role in generating videos and pages from extremist content raises questions about exposure. Legal analysts contacted by the AP differed on whether the discovery could open the company up to lawsuits.

At a minimum, the research behind the SEC complaint illustrates the company's limited approach to combatting online extremism. The U.S. State Department lists dozens of groups as "designated foreign terrorist organizations" but Facebook in its public statements says it focuses its efforts on two, the Islamic State group and al-Qaida. But even with those two targets, Facebook's algorithms often miss the names of affiliated groups. Al Azm says Facebook's method seems to be less effective with Arabic script.

Por exemplo, a search in Arabic for "Al-Qaida in the Arabian Peninsula" turns up not only posts, but an auto-generated business page. One user listed his occupation as "Former Sniper" at "Al-Qaida in the Arabian Peninsula" written in Arabic. Another user evaded Facebook's cull by reversing the order of the countries in the Arabic for ISIS or "Islamic State of Iraq and Syria."

Amr Al Azm, a professor of Middle East History and Anthropology at Shawnee State University, speaks at his office on April 25, 2019, in Portsmouth, Ohio. Facebook gives the impression that it's stopping the vast majority of extremist posts before users ever see them. But a confidential whistleblower's complaint to the Securities and Exchange Commission obtained by The Associated Press alleges the social media company has exaggerated its success. "I mean that's just stretching the imagination to beyond incredulity, " diz, Al Azm one of the researchers involved in the project. "If a small group of researchers can find hundreds of pages of content by simple searches, why can't a giant company with all its resources do it?" (AP Photo/John Minchillo)

John Kostyack, a lawyer with the National Whistleblower Center in Washington who represents the anonymous plaintiff behind the complaint, said the goal is to make Facebook take a more robust approach to counteracting extremist propaganda.

"Right now we're hearing stories of what happened in New Zealand and Sri Lanka—just heartbreaking massacres where the groups that came forward were clearly openly recruiting and networking on Facebook and other social media, " he said. "That's not going to stop unless we develop a public policy to deal with it, unless we create some kind of sense of corporate social responsibility."

Farid, the digital forensics expert, says that Facebook built its infrastructure without thinking through the dangers stemming from content and is now trying to retrofit solutions.

"The policy of this platform has been:'Move fast and break things.' I actually think that for once their motto was actually accurate, " he says. "The strategy was grow, grow, grow, profit, profit, profit and then go back and try to deal with whatever problems there are."

© 2019 Associated Press. Todos os direitos reservados.