Crédito:Geralt / Pixabay

Neurônios artificiais para máquinas profundamente inteligentes - esta é a nova revolução da inteligência artificial (IA), liderado por Geoffrey Hinton e sua equipe desde 2012. Naquele ano, Hinton, especialista em ciências cognitivas na Universidade de Toronto e pesquisador do Google Brain, demonstrou a notável eficácia de uma rede neural profunda (DNN) em uma tarefa de categorização de imagens.

Na esteira desses resultados notáveis, universidades - e corporações internacionais - investiram maciçamente no campo promissor e fascinante da IA. No entanto, apesar do desempenho impressionante de DNNs em uma variedade de campos (reconhecimento visual e vocal, tradução, imagens médicas, etc.), permanecem questões sobre os limites do aprendizado profundo para outros usos, como veículos antônimos.

Para entender os limites da IA em seu estado atual, precisamos entender de onde vêm os DNNs e, sobre tudo, em que áreas do cérebro humano são modelados - pouco se sabe sobre isso na engenharia industrial, e até mesmo em alguns centros de pesquisa. Desde o início desta nova revolução, o aprendizado profundo às vezes é usado como uma espécie de "varinha mágica", com escassa atenção aos seus antecedentes ou limitações. "Para uma inteligência artificial significativa", o título de um relatório recente do matemático francês Cédric Villani, é a evidência da profunda ambivalência em torno deste tópico.

De onde veio o aprendizado profundo?

O início das redes neurais artificiais data da década de 1940, com as descobertas pioneiras em neurociência e psicologia de Warren McCulloch e Walter H. Pitts (que forneceu o primeiro modelo matemático de um neurônio) e Donald Hebb (que descreveu os mecanismos de aprendizagem sináptica). Esses pesquisadores queriam entender como os neurônios, os blocos básicos de construção do cérebro, poderia gerar a psique.

Seu trabalho seminal levou à criação da primeira rede neuronal artificial, o Perceptron, projetado em 1958 pelo psicólogo americano Frank Rosenblatt. Naturalmente, a pesquisa inicial foi seguida por desenvolvimentos significativos baseados, por exemplo, nos estudos neurocientíficos de Alan L. Hodgkin e Andrew F. Huxley descrevendo a dinâmica temporal da integração neural, e na pesquisa em ciência da computação e matemática por Bernard Widrow e Ted Hoff, que sugeriu o uso de algoritmos de descida gradiente estocástico como uma forma mais eficaz de modificar as conexões sinápticas em redes neurais.

Essas otimizações matemáticas foram desenvolvidas na década de 1980 com pesquisas em ciências cognitivas por David Rumelhart, Geoffrey Hinton e James McClelland, membros do Grupo de Pesquisa em Processamento Distribuído Paralelo. Seu trabalho ajudou a otimizar a modificação de conexões sinápticas em camadas neuronais profundas e levou à criação do Multilayer Perceptron (MLP). DNNs, desenvolvido por pesquisadores como Geoffrey Hinton, Yann LeCun e Yoshua Bengio, são seus descendentes diretos.

Existe uma ligação entre o aprendizado profundo e o cérebro?

Embora os DNNs tenham sido originalmente desenvolvidos por meio de trabalho interdisciplinar e inspirados pela função cerebral, pode-se perguntar até que ponto esses algoritmos ainda constituem uma simulação do cérebro humano. Eles foram projetados para realizar tarefas como reconhecimento e categorização de imagens. Para fazer isso, Os DNNs usam várias camadas convolucionais e de agrupamento antes do reconhecimento da imagem.

Com relação às camadas convolucionais, o trabalho de David Hubel e Torsten Wiesel na década de 1960, e Leonie Jones e Derecke Palmer na década de 1980, demonstrar a utilidade deste método em simular a provável resposta dos neurônios no córtex visual primário. Vários estudos em ciências cognitivas, incluindo nosso próprio trabalho, usar este processo como um sistema inspirado neuro para simular a resposta de neurônios perceptivos no córtex visual primário, por exemplo.

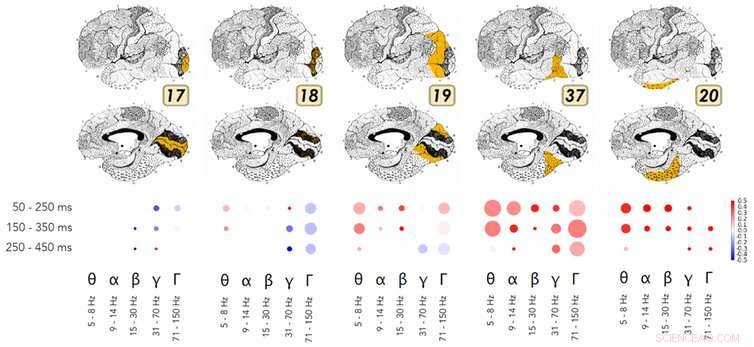

Um exemplo da pesquisa que demonstra as semelhanças na maneira como as redes neurais profundas e o fluxo ventral do córtex visual operam. Crédito:Kuzovkin, Vicente, Petton, Lachaux, Baciu, Kahane et Aru, 2018., Autor fornecido

Com relação ao pool, vários estudos nos campos da neurociência e da psicologia cognitiva nos últimos trinta anos demonstraram como o cérebro realiza esse processo de abstração no fluxo visual ventral. O trabalho de Rufin Vogels e Keiji Tanaka mostra como esse fluxo permite a identificação e categorização visual, independentemente das propriedades da superfície de uma imagem, como textura, cor, distância, ou a posição dos objetos na imagem. Essas áreas do cérebro são, portanto, sensíveis às mesmas informações que as camadas perceptivas aprendidas por um DNN durante o processo de agrupamento.

Ainda mais surpreendente, pesquisa de Rodrigo Quian Quiroga e seus colegas demonstra a existência de neurônios específicos para conceitos ou identidades (por exemplo, um neurônio "Jennifer Aniston", ou um neurônio "Torre de Pisa"). Estes disparam em resposta à exposição direta a um conceito, como ver o nome "Jennifer Aniston" impresso. O que é mais empolgante para o futuro da IA é que o trabalho do Sr. Quiroga demonstra que esta atividade neuronal está correlacionada com o consciente percepção de um estímulo no ambiente.

Para resumir, embora sejam simplificados e matematicamente otimizados em comparação com um cérebro biológico, Os DNNs reproduzem processos muito semelhantes como uma área muito específica do córtex (ou seja, córtex occipito-temporal). Usando ressonância magnética ou eletrodos implantados no cérebro, estudos recentes em neurociência cognitiva demonstram semelhanças no funcionamento de DNNs e essas áreas cerebrais específicas.

A IA é mais confiável quando inspirada pelo cérebro?

A pesquisa interdisciplinar básica sobre DNNs produziu resultados tangíveis impressionantes em uma ampla gama de áreas:reconhecimento visual e categorização, reconhecimento vocal, tradução, o jogo de go, composição musical, para citar apenas alguns exemplos. Infelizmente, pela falta de compreensão da ciência cognitiva que os sustenta, Os DNNs ainda são usados com muita frequência como uma espécie de varinha mágica para resolver todo e qualquer problema.

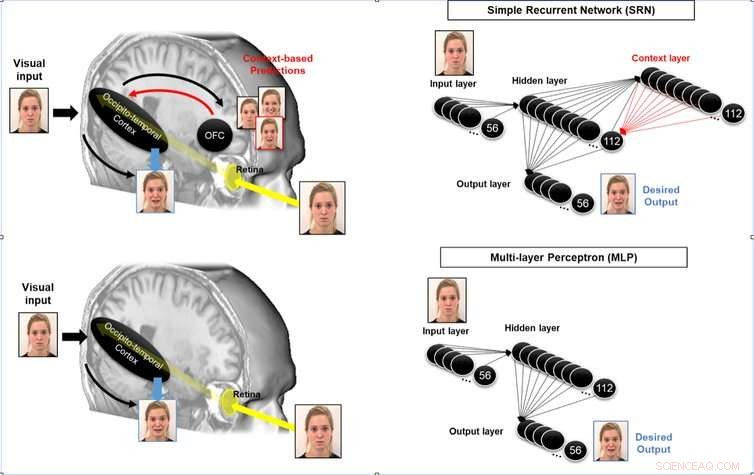

É possível melhorar a capacidade de antecipação de um sistema neuromórfico, simulando os loops recorrentes de áreas associativas para áreas perceptivas em funcionamento no cérebro humano. Crédito:Mermillod, Bourrier, David, Kauffmann, Chauvin, Guyader, Dutheil et Peyrin, 2018., Autor fornecido

Para tomar o exemplo dos carros sem motorista, Acoplar DNNs aos sistemas de controle do veículo seria altamente arriscado:seria o mesmo que pedir a um motorista de táxi que perdeu mais de 80% da função cerebral em um acidente (deixando apenas o fluxo ventral visual) para dirigir um carro. Exigir que esses sistemas façam mais do que aquilo para que foram originalmente projetados pode levar a acidentes catastróficos.

As áreas do cérebro humano envolvidas na antecipação (veja abaixo), a orientação espacial e as funções sensório-motoras necessárias para dirigir em um ambiente complexo são muito diferentes dos processos neurais em funcionamento no fluxo ventral visual. Localizada no córtex occipito-parietal, os processos neuronais envolvidos na compreensão e no planejamento são muito diferentes daqueles que ocorrem na corrente ventral visual! Esses são neurônios muito diferentes, sensível à distância, posição e velocidade - todos os parâmetros fundamentais para determinar como nos comportamos no ambiente.

O uso indiscriminado de DNNs (ou outros sistemas artificiais) sem referência ou comparação com a neuro-inspiração por trás das várias funções cognitivas não é apenas ineficaz, mas totalmente perigoso. Não afirmamos que a neuroinspiração seja a única forma eficaz de uma IA mais segura. Contudo, dado o passado tumultuado da IA, e levando em consideração a eficácia agora comprovada de sistemas neuro-inspirados como DNNs em comparação com métodos de engenharia anteriores (para reconhecimento visual, por exemplo), acreditamos que é essencial entender como o cérebro executa outras funções cognitivas (controle motor, integração multissensorial, etc.), a fim de comparar isso com as técnicas de engenharia atuais para executar essas funções, e produzir um mais seguro, IA mais eficiente.

A pesquisa de IA conduzida em colaboração mais próxima com as ciências cognitivas nos permitiria:

Este desafio requer pesquisas interdisciplinares envolvendo não apenas matemática e ciência da computação, mas também neurociência e psicologia cognitiva, bem como pesquisa em eletrônica e física para desenvolver as unidades do processador neural (NPU) que estão sendo projetadas atualmente. Temos a oportunidade de finalmente superar os limites das máquinas de Turing-Von Neumann que dominaram a eletrônica e a tecnologia da informação desde a Segunda Guerra Mundial.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.