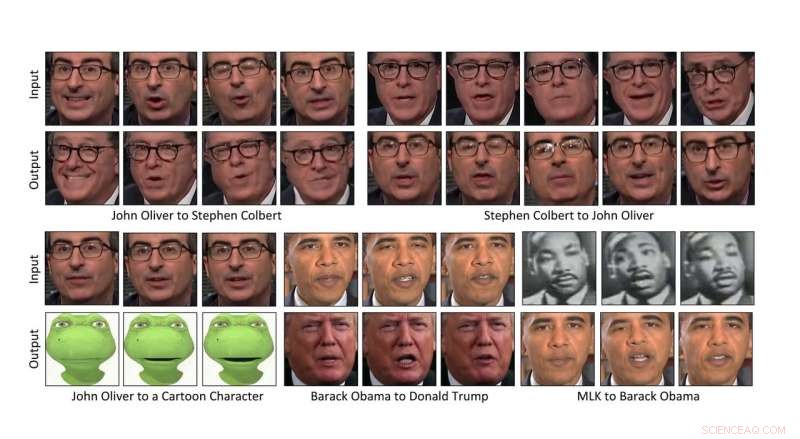

Pesquisadores da Carnegie Mellon University criaram uma maneira de transformar automaticamente o conteúdo de um vídeo no estilo de outro, tornando possível transferir as expressões faciais de uma pessoa para o vídeo de outra pessoa, ou mesmo um personagem de desenho animado. Crédito:Carnegie Mellon University

Pesquisadores da Carnegie Mellon University criaram uma maneira de transformar automaticamente o conteúdo de um vídeo no estilo de outro, tornando possível transferir as expressões faciais do comediante John Oliver para as de um personagem de desenho animado, ou para fazer um narciso florescer da mesma forma que um hibisco.

Como o método baseado em dados não requer intervenção humana, pode transformar rapidamente grandes quantidades de vídeo, tornando-se um benefício para a produção de filmes. Ele também pode ser usado para converter filmes em preto e branco em cores e para criar conteúdo para experiências de realidade virtual.

"Acho que há muitas histórias para serem contadas, "disse Aayush Bansal, um Ph.D. estudante do Instituto de Robótica da CMU. A produção de filmes foi sua principal motivação para ajudar a conceber o método, ele explicou, permitindo que os filmes sejam produzidos de forma mais rápida e barata. "É uma ferramenta para o artista que dá a eles um modelo inicial que eles podem melhorar, " ele adicionou.

A tecnologia também tem potencial para ser usada nas chamadas "falsificações profundas, "vídeos em que a imagem de uma pessoa é inserida sem permissão, fazendo parecer que a pessoa fez ou disse coisas que estão fora do personagem, Bansal reconhecido.

"Foi uma revelação para todos nós da área que tais falsificações seriam criadas e teriam um impacto tão grande, "ele disse." Encontrar maneiras de detectá-los será importante no futuro. "

Bansal apresentará o método hoje na ECCV 2018, a Conferência Europeia sobre Visão Computacional, em Munique. Seus co-autores incluem Deva Ramanan, Professor associado de robótica da CMU.

Transferir conteúdo de um vídeo para o estilo de outro depende da inteligência artificial. Em particular, uma classe de algoritmos chamados redes adversárias gerativas (GANs) tornaram mais fácil para os computadores entenderem como aplicar o estilo de uma imagem a outra, particularmente quando eles não foram cuidadosamente combinados.

Em um GAN, dois modelos são criados:um discriminador que aprende a detectar o que é consistente com o estilo de uma imagem ou vídeo, e um gerador que aprende a criar imagens ou vídeos que combinem com um determinado estilo. Quando os dois funcionam competitivamente - o gerador tentando enganar o discriminador e o discriminador avaliando a eficácia do gerador - o sistema eventualmente aprende como o conteúdo pode ser transformado em um determinado estilo.

Uma variante, chamado ciclo-GAN, completa o loop, muito parecido com traduzir a fala do inglês para o espanhol e depois do espanhol de volta para o inglês e então avaliar se a fala traduzida duas vezes ainda faz sentido. Usar o Cycle-GAN para analisar as características espaciais das imagens tem se mostrado eficaz na transformação de uma imagem no estilo de outra.

Esse método espacial ainda deixa a desejar para o vídeo, com artefatos indesejados e imperfeições surgindo no ciclo completo de traduções. Para mitigar o problema, os pesquisadores desenvolveram uma técnica, chamado Recycle-GAN, que incorpora não apenas espacial, mas informação temporal. Esta informação adicional, contabilizando as mudanças ao longo do tempo, restringe ainda mais o processo e produz melhores resultados.

Os pesquisadores mostraram que o Recycle-GAN pode ser usado para transformar o vídeo de Oliver no que parece ser o colega comediante Stephen Colbert e de volta ao Oliver. Ou o vídeo do rosto de John Oliver pode ser transformado em personagem de desenho animado. O Recycle-GAN permite não apenas as expressões faciais serem copiadas, mas também os movimentos e cadência da performance.

Os efeitos não se limitam a rostos, ou mesmo corpos. Os pesquisadores demonstraram que o vídeo de uma flor desabrochando pode ser usado para manipular a imagem de outros tipos de flores. Ou as nuvens que estão cruzando o céu rapidamente em um dia de vento podem ser reduzidas para dar a aparência de um tempo mais calmo.

Esses efeitos podem ser úteis no desenvolvimento de carros autônomos que podem navegar à noite ou com mau tempo, Bansal disse. A obtenção de vídeos de cenas noturnas ou de clima tempestuoso em que os objetos podem ser identificados e rotulados pode ser difícil, ele explicou. Recycle-GAN, por outro lado, pode transformar cenas diurnas facilmente obtidas e rotuladas em cenas noturnas ou tempestuosas, fornecendo imagens que podem ser usadas para treinar carros para operar nessas condições.