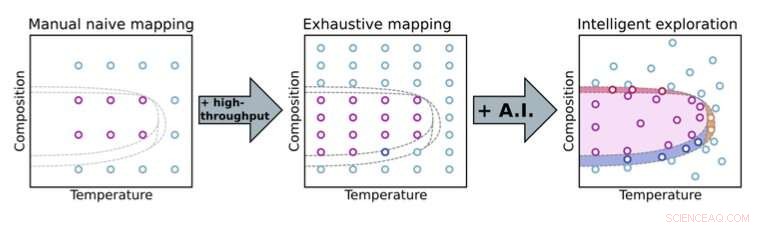

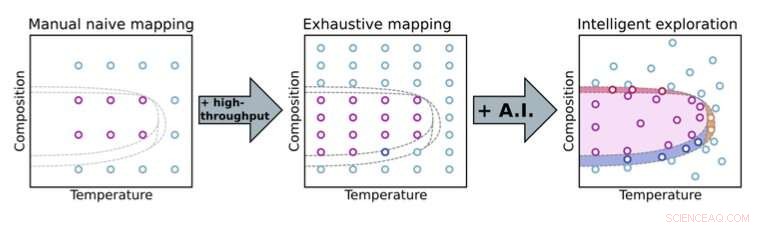

p Mudar de uma abordagem de experimentação manual para automatizada permite que os cientistas explorem mais profundamente os espaços de parâmetros. Com métodos de tomada de decisão de inteligência artificial (IA), os cientistas podem se concentrar em partes-chave do espaço de parâmetros (aqui, composição e temperatura) para descoberta acelerada de material. Crédito:Laboratório Nacional de Brookhaven

p Mudar de uma abordagem de experimentação manual para automatizada permite que os cientistas explorem mais profundamente os espaços de parâmetros. Com métodos de tomada de decisão de inteligência artificial (IA), os cientistas podem se concentrar em partes-chave do espaço de parâmetros (aqui, composição e temperatura) para descoberta acelerada de material. Crédito:Laboratório Nacional de Brookhaven

p Na visão popular da ciência tradicional, os cientistas estão no laboratório pairando sobre seus experimentos, microgerenciando cada pequeno detalhe. Por exemplo, eles podem testar iterativamente uma ampla variedade de composições de materiais, protocolos de síntese e processamento, e as condições ambientais para ver como esses parâmetros influenciam as propriedades do material. Em cada iteração, eles analisam os dados coletados, procurando padrões e confiando em seu conhecimento científico e intuição para selecionar medidas úteis de acompanhamento. p Esta abordagem manual consome um tempo limitado do instrumento e a atenção de especialistas humanos que, de outra forma, poderiam se concentrar no panorama geral. Experimentos manuais também podem ser ineficientes, especialmente quando há um grande conjunto de parâmetros para explorar, e estão sujeitos ao preconceito humano, por exemplo, ao decidir quando coletou dados suficientes e pode interromper um experimento. A maneira convencional de fazer ciência não pode escalar para lidar com a enorme complexidade dos desafios científicos futuros. Avanços em instrumentos científicos e recursos de análise de dados em instalações experimentais continuam a permitir medições mais rápidas. Embora esses avanços possam ajudar os cientistas a lidar com problemas experimentais complexos, eles também exacerbam o gargalo humano; nenhum ser humano pode acompanhar as ferramentas experimentais modernas!

p

Automação de previsão

p Uma dessas instalações que gerencia esses tipos de desafios é a Fonte de Luz Síncrotron Nacional II (NSLS-II) no Laboratório Nacional de Brookhaven do Departamento de Energia dos EUA (DOE). Direcionando feixes de luz, variando de infravermelho a raios-X duros, para amostras em estações experimentais (linhas de luz), NSLS-II pode revelar o eletrônico, químico, e estruturas atômicas de materiais. Quando os cientistas estavam projetando essas linhas de luz há uma década, eles tiveram a visão de incorporar a automação habilitada pelo aprendizado de máquina (ML) e inteligência artificial (IA) - agora um campo em expansão - como parte de sua visão.

p "Nós pensamos, não seria ótimo se os cientistas pudessem não apenas fazer medições mais rápido, mas também fazer exploração inteligente, isto é, explorar problemas científicos de maneira mais inteligente, maneiras mais eficientes, aproveitando os métodos modernos de ciência da computação, "disse Kevin Yager, líder do Grupo de Nanomateriais Eletrônicos do Centro de Nanomateriais Funcionais (CFN) do Laboratório de Brookhaven. "Na verdade, no CFN, definimos um de nossos temas de pesquisa como a descoberta acelerada de nanomateriais. "

p Essa ideia de uma linha de luz altamente automatizada que pudesse explorar problemas científicos de maneira inteligente acabou se tornando um objetivo de longo prazo da linha de luz de espalhamento de materiais complexos (CMS), desenvolvido e operado por uma equipe liderada por Masafumi Fukuto.

p "Começamos criando recursos de alto rendimento para medições rápidas, como um robô de troca de amostras e muitas ferramentas in-situ para explorar diferentes parâmetros, como temperatura, pressão de vapor, e umidade, "disse Fukuto." Ao mesmo tempo, começamos a pensar em automatizar não apenas o hardware da linha de luz para coleta de dados, mas também a análise de dados em tempo real e a tomada de decisão experimental. A capacidade de fazer medições muito rapidamente é útil e necessária, mas não suficiente para a descoberta de materiais revolucionários porque os espaços de parâmetros de materiais são muito grandes e multidimensionais. "

p Por exemplo, um experimento pode ter um espaço de parâmetro com cinco dimensões e mais de 25, 000 pontos distintos dentro desse espaço para explorar. Tanto a aquisição de dados quanto o software de análise para lidar com esses grandes, espaços de parâmetros de alta dimensão foram construídos internamente em Brookhaven. Para coleta de dados, eles construíram com base no software Bluesky, que NSLS-II desenvolveu. Para analisar os dados, Yager escreveu o código para um software de análise de imagens chamado SciAnalysis.

p

Fechando o ciclo

p Em 2017, Fukuto e Yager começaram a colaborar com Marcus Noack, em seguida, um pós-doutorado e agora um cientista pesquisador no Centro de Matemática Avançada para Aplicações de Pesquisa de Energia (CAMERA) no Laboratório Nacional Lawrence Berkeley do DOE. Durante seu tempo como pós-doutorado, Noack foi encarregado de colaborar com a equipe de Brookhaven em seu conceito de linha de luz autônoma. Especificamente, eles trabalharam juntos para desenvolver a última peça para criar uma configuração experimental totalmente automatizada:um algoritmo de tomada de decisão. A equipe de Brookhaven definiu suas necessidades, enquanto Noack forneceu sua experiência em matemática aplicada e escreveu o software para atender a essas necessidades.

p Aproveitando IA e ML, este algoritmo determina as melhores próximas medições a serem feitas enquanto um experimento está em andamento. (AI refere-se a uma máquina que simula o comportamento humano, enquanto ML é um subcampo da IA em que uma máquina aprende automaticamente a partir de dados anteriores.) Para que o algoritmo comece a modelar um sistema, é tão simples quanto um usuário definir as entradas e saídas:quais são as variáveis que posso controlar no experimento, e o que vou medir? Porém, quanto mais informações os humanos fornecerem com antecedência - como a resposta esperada do sistema ou restrições conhecidas com base no problema específico que está sendo estudado - mais robusta será a modelagem. Por trás das cenas, um processo gaussiano está em funcionamento, modelando o comportamento do sistema.

p "Um processo gaussiano é uma forma matematicamente rigorosa de estimar a incerteza, "explicou Yager." Essa é outra maneira de dizer conhecimento em minha mente. E essa é outra maneira de dizer ciência. Porque na ciência, é nisso que estamos mais interessados:o que eu sei, e como eu sei disso? "

p "Essa é a parte de ML, "acrescentou Fukuto." O algoritmo vai um passo além disso. Ele toma decisões automaticamente com base neste conhecimento e nas informações humanas para selecionar qual ponto faria sentido medir a seguir. "

p Em um caso simplista, esta próxima medição seria o local no espaço de parâmetro onde o ganho de informação pode ser maximizado (ou a incerteza reduzida). A equipe demonstrou esta prova de conceito pela primeira vez em 2019 na linha de luz NSLS-II CMS, imagem de um filme de nanomaterial feito especificamente para esta demonstração.

p Desde este sucesso inicial, a equipe tem tornado o algoritmo mais sofisticado, aplicando-o para estudar uma ampla gama de problemas científicos reais (em vez de inventados) de vários grupos, e estendendo-o a mais técnicas e instalações experimentais.

p Enquanto a versão padrão do algoritmo visa minimizar a incerteza ou maximizar o ganho de conhecimento de uma forma iterativa, existem outras maneiras de pensar sobre onde concentrar a atenção experimental para obter o máximo valor. Por exemplo, para alguns cientistas, o custo do experimento - seja sua duração ou quantidade de materiais usados - é importante. Em outras palavras, não é apenas

Onde você pega os dados, mas como

caro é pegar esses dados. Outros podem achar valor em se concentrar em recursos específicos, como limites dentro de um espaço de parâmetro ou tamanho de grão de um cristal. Quanto mais sofisticado, A versão flexível do algoritmo desenvolvido por Noack pode ser programada para aumentar a sensibilidade a esses recursos.

p "Você pode ajustar quais são seus objetivos no experimento, "explicou Yager." Então, pode ser ganho de conhecimento, ou ganho de conhecimento regulado por custo experimental ou associado a recursos específicos. "

p Outras melhorias incluem a capacidade do algoritmo de lidar com a complexidade de sistemas reais, como o fato de que os materiais não são homogêneos, o que significa que eles não são os mesmos em todos os pontos de uma amostra. Uma parte de uma amostra pode ter uma composição uniforme, enquanto outro pode ter uma composição variável. Além disso, o algoritmo agora leva em consideração a anisotropia, ou como os parâmetros individuais podem ser muito diferentes uns dos outros em termos de como afetam um sistema. Por exemplo, "x" e "y" são parâmetros equivalentes (ambos são coordenadas posicionais), mas a temperatura e a pressão não são.

p "Os processos gaussianos usam kernels - funções que descrevem como os pontos de dados dependem uns dos outros no espaço - para interpolação, "disse Noack." Os grãos têm todos os tipos de propriedades matemáticas interessantes. Por exemplo, eles podem codificar vários graus de não homogeneidade para uma amostra. "

p Aumentar a sofisticação do algoritmo é apenas parte do desafio. Então, Fukuto e Yager precisam integrar o algoritmo atualizado ao fluxo de trabalho experimental automatizado de loop fechado e testá-lo em diferentes experimentos - não apenas aqueles feitos internamente, mas também aqueles realizados pelos usuários.

p

Implantar o método para a comunidade científica mais ampla

p Recentemente, Fukuto, Yager, Noack, e colegas implantaram o método autônomo em vários experimentos reais em várias linhas de luz NSLS-II, incluindo CMS e Soft Matter Interfaces (SMI). Noack e colaboradores também implantaram o método no Advanced Light Source (ALS) do LBNL e no Institut Laue-Langevin (ILL), uma instalação de espalhamento de nêutrons na França. A equipe lançou seu software de tomada de decisão, gpCAM, para a comunidade científica mais ampla, para que qualquer um pudesse criar seus próprios experimentos autônomos.

p Em um experimento, em colaboração com o Laboratório de Pesquisa da Força Aérea dos EUA (AFRL), eles usaram o método em um experimento autônomo de espalhamento de raios-X síncrotron na linha de luz CMS. Na dispersão de raios-X, os raios X refletem em uma amostra em diferentes direções, dependendo da estrutura da amostra. O primeiro objetivo do experimento foi explorar como a estrutura ordenada de filmes compostos de nanorod-polímero depende de dois parâmetros de fabricação:a velocidade do revestimento do filme e o revestimento químico do substrato. O segundo objetivo era usar esse conhecimento para localizar e se familiarizar com as regiões dos filmes com os mais altos graus de ordem.

p "Esses materiais são de interesse para revestimentos ópticos e sensores, "explicou Ruipeng Li, cientista da linha de luz CMS." Usamos um método de fabricação particular que imita os processos industriais roll-to-roll para descobrir a melhor maneira de formar esses filmes solicitados usando processos industrialmente escaláveis. "

p Em outro experimento de espalhamento de raios-X, na linha de luz SMI, o algoritmo identificou com sucesso regiões de ordenação inesperada em um espaço de parâmetro relevante para a automontagem de filmes de copolímero em bloco. Os copolímeros em bloco são polímeros constituídos por dois ou mais "blocos" quimicamente distintos ligados entre si. Ao identificar esses recursos, o experimento autônomo iluminou um problema com o método de fabricação.

p "Não era hipotético - trabalhamos neste projeto há muitos anos, "disse o cientista de materiais da CFN Gregory Doerk." Estávamos repetindo da maneira antiga, fazendo alguns experimentos, tirar imagens em locais que escolhemos arbitrariamente, olhando as imagens, e ficar intrigado com o que está acontecendo. Com a abordagem autônoma, em um dia de experimentos na linha de luz, conseguimos encontrar os defeitos e corrigi-los imediatamente na próxima rodada. Essa é uma aceleração dramática do ciclo normal de pesquisa em que você faz um estudo, descobrir que não funcionou, e volte para a prancheta. "

p Noack e seus colaboradores também aplicaram o método a um tipo diferente de técnica de raios-X, denominado mapeamento infravermelho síncrotron autônomo, que pode fornecer informações químicas sobre uma amostra. E eles demonstraram como o método poderia ser aplicado a uma técnica de espectroscopia para descobrir de forma autônoma fases onde os elétrons se comportam de maneira fortemente correlacionada e para espalhar nêutrons para medir de forma autônoma as correlações magnéticas.

p

Moldando o futuro da experimentação autônoma

p De acordo com Yager, seu método pode ser aplicado a qualquer técnica para a qual a coleta e análise de dados já foram automatizadas. Uma das vantagens da abordagem é que ela é "agnóstica da física, "o que significa que não está vinculado a nenhum tipo específico de material, problema físico, ou técnica. As quantidades fisicamente significativas para a tomada de decisão são extraídas por meio da análise dos dados brutos.

p "Queríamos tornar nossa abordagem muito geral para que pudesse ser aplicada a qualquer coisa e, posteriormente, adaptada a problemas específicos, "disse Yager." Como uma facilidade do usuário, queremos capacitar o maior número de pessoas para fazer ciência interessante. "

p No futuro, a equipe adicionará funcionalidade para que os usuários incorporem consciência física, ou conhecimento sobre os materiais ou fenômenos que estão estudando, se eles desejam. Mas a equipe fará isso de uma maneira que não destrua a flexibilidade de propósito geral da abordagem; os usuários poderão ativar ou desativar esse conhecimento extra.

p Outro aspecto do trabalho futuro é aplicar o método para controlar processos em tempo real - em outras palavras, controlar um sistema que está evoluindo dinamicamente no tempo à medida que um experimento prossegue.

p "Até este ponto, temos nos concentrado em tomar decisões sobre como medir ou caracterizar sistemas de materiais preparados, "disse Fukuto." Também queremos tomar decisões sobre como alterar os materiais ou que tipos de materiais queremos fazer. Compreender a ciência fundamental por trás das mudanças de materiais é importante para melhorar os processos de fabricação. "

p Perceber essa capacidade de explorar de forma inteligente os materiais em evolução em tempo real exigirá a superação dos desafios de algoritmos e instrumentação.

p “A tomada de decisão tem que ser muito rápida, e você tem que construir ambientes de amostra para fazer a síntese de materiais em tempo real enquanto faz medições com um feixe de raios-X, "explicou Yager.

p Apesar desses desafios, a equipe está entusiasmada com o que o futuro da experimentação autônoma reserva.

p "Começamos esse esforço em uma escala muito pequena, mas cresceu para algo muito maior, "disse Fukuto." Muitas pessoas estão interessadas nisso, não apenas nós. A comunidade de usuários está se expandindo, e com usuários estudando diferentes tipos de problemas, esta abordagem pode ter um grande impacto na aceleração de uma série de descobertas científicas. "

p "É realmente uma grande mudança de pensamento ir da velha maneira de experimentos de microgerenciamento para esta nova visão de sistemas automatizados executando experimentos com humanos, orquestrando-os em um nível muito alto, porque eles entendem o que precisa ser feito e o que a ciência significa, "disse Yager." Essa é uma visão muito empolgante para o futuro da ciência. Vamos ser capazes de resolver problemas no futuro que há dez anos as pessoas diriam que são impossíveis. "