Crédito:lightcommands.com

Lasers brilhando em assistentes de voz como Alexa e Siri, pesquisadores de Michigan e do Japão conseguiram um hack em que os lasers tinham o poder de comandos da voz humana.

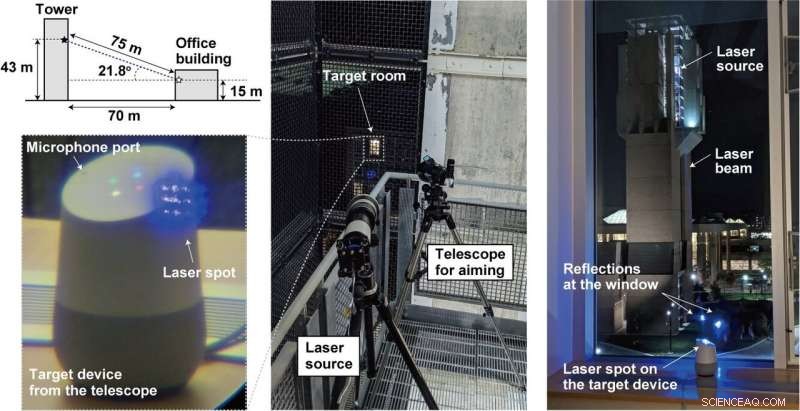

Ao direcionar o laser através da janela para microfones dentro de dispositivos como tablets, ou telefones, um atacante distante pode enviar remotamente comandos inaudíveis e potencialmente invisíveis executados por Alexa, Portal, Assistente do Google ou Siri.

Simplificando, um invasor pode sequestrar o assistente de voz e enviar comandos.

Como a equipe realizou a luz como som? Uma vulnerabilidade em microfones que usam sistemas microeletromecânicos (MEMS) é explorada. Os componentes MEMS respondem involuntariamente à luz como se fosse um som, disse Ars Technica .

Qual o pior que pode acontecer? Bastante. Ars Technica descreveu os lasers injetando comandos inaudíveis nos dispositivos e fazendo-os sub-repticiamente "destrancar portas, visite sites, e localize, desbloquear, e dar partida nos veículos. "

Os pesquisadores discutiram seu trabalho em seu artigo publicado na segunda-feira. "Comandos de luz:ataques de injeção de áudio baseados em laser em sistemas controláveis por voz" é de cinco autores afiliados à Universidade de Michigan (quatro) e à Universidade de Electro-Communications, Japão (um).

"Em nosso jornal, " eles disseram, "demonstramos esse efeito, usando com sucesso a luz para injetar comandos maliciosos em vários dispositivos controlados por voz, como alto-falantes inteligentes, tablets, e telefones em grandes distâncias e através de janelas de vidro. "

Foi fácil de realizar?

Para impedir a autenticação, bastante fácil.

"Os sistemas controlados por voz muitas vezes não exigem que os usuários se autentiquem, " escreveu Ars Technica é Dan Goodin. O ataque nessas instâncias pode ser executado com frequência sem a necessidade de senhas ou PINs. Freqüentemente. "Mesmo quando os sistemas exigem autenticação para certas ações, " ele adicionou, "pode ser viável usar força bruta no PIN, já que muitos dispositivos não limitam o número de suposições que um usuário pode fazer. "

Também, o ataque não foi caro de realizar. Comandos de luz podem ser montados de forma barata, disse um apresentador de vídeo, usando ponteiros laser regulares. Isso pode até ser feito entre dois edifícios.

A equipe disse que tentou seu ataque a sistemas de reconhecimento de voz populares, ou seja, Amazon Alexa, Apple Siri, Portal do Facebook, e Google Assistant. Na realidade, no entanto, "qualquer sistema que use microfones MEMS e atue sobre esses dados sem confirmação adicional do usuário pode ser vulnerável, "de acordo com seu próprio site de comandos de luz.

Qual é o perigo com comandos de luz?

Alexa, Como está o tempo? Isso é inofensivo. O invasor pode controlar switches de casa inteligente. Abra as portas de garagem inteligentes. Inicie veículos remotamente. Na verdade, você pode assistir a um vídeo injetando "Ok Google, abra a porta da garagem "para um Google Home apenas apontando um apontador laser barato.

O que pode ser feito para proteger contra a vulnerabilidade? O apresentador de vídeo disse que a vulnerabilidade básica não pode ser resolvida sem um reprojeto caro do microfone.

“Estamos colaborando com a Amazon, Google, Maçã, bem como outros fornecedores sobre medidas defensivas. "Eles têm mais informações e demonstrações em lightcommands.com.

"Uma camada adicional de autenticação pode ser eficaz para mitigar um pouco o ataque. Como alternativa, caso o invasor não consiga escutar a resposta do dispositivo, fazer com que o dispositivo faça ao usuário uma pergunta aleatória simples antes da execução do comando pode ser uma forma eficaz de impedir que o invasor obtenha a execução do comando com êxito.

"Os fabricantes também podem tentar usar técnicas de fusão de sensores, como adquirir áudio de vários microfones. Quando o invasor usa um único laser, apenas um único microfone recebe um sinal enquanto os outros não recebem nada ...

Outra abordagem consiste em reduzir a quantidade de luz que atinge o diafragma do microfone usando uma barreira que bloqueia fisicamente os feixes retos de luz para eliminar a linha de visão do diafragma, ou implemente uma tampa não transparente na parte superior do orifício do microfone para atenuar a quantidade de luz que atinge o microfone. Contudo, notamos que tais barreiras físicas só são eficazes até certo ponto, como um atacante sempre pode aumentar a potência do laser na tentativa de compensar a atenuação induzida pela cobertura ou para queimar as barreiras, criando um novo caminho de luz. "

O acima apareceu em seu site de comandos de luz, enquanto o documento também discutiu abordagens de mitigação e limitações.

Enquanto isso, Mariella Moon em Engadget lembrou a seus leitores que esta não seria a primeira vez que pesquisadores encontrariam vulnerabilidades em assistentes digitais. "Pesquisadores da Universidade Zheijiang da China descobriram que Siri, Alexa e outros assistentes de voz podem ser manipulados com comandos enviados em frequências ultrassônicas. "

© 2019 Science X Network