Quando um computador coloca o rosto de Nicolas Cage na cabeça de Elon Musk, pode não alinhar o rosto e a cabeça corretamente. Crédito:Siwei Lyu, CC BY-ND

Vídeos falsos são difíceis de serem detectados por olhos não treinados porque podem ser bastante realistas. Quer sejam usados como armas pessoais de vingança, para manipular os mercados financeiros ou para desestabilizar as relações internacionais, os vídeos que mostram pessoas fazendo e dizendo coisas que nunca fizeram ou disseram são uma ameaça fundamental à ideia de longa data de que "ver para crer". Não mais.

A maioria dos deepfakes é feita mostrando a um algoritmo de computador muitas imagens de uma pessoa, e depois usar o que viu para gerar novas imagens de rosto. Ao mesmo tempo, sua voz é sintetizada, então parece e soa como se a pessoa tivesse dito algo novo.

Alguns dos trabalhos anteriores do meu grupo de pesquisa nos permitiram detectar vídeos deepfake que não incluíam a quantidade normal de piscar de olhos de uma pessoa, mas a última geração de deepfakes se adaptou, portanto, nossa pesquisa continuou a avançar.

Agora, nossa pesquisa pode identificar a manipulação de um vídeo observando de perto os pixels de quadros específicos. Dando um passo adiante, também desenvolvemos uma medida ativa para proteger os indivíduos de se tornarem vítimas de deepfakes.

Encontrando falhas

Em dois artigos de pesquisa recentes, descrevemos maneiras de detectar deepfakes com falhas que não podem ser corrigidas facilmente pelos falsificadores.

Quando um algoritmo de síntese de vídeo deepfake gera novas expressões faciais, as novas imagens nem sempre correspondem ao posicionamento exato da cabeça da pessoa, ou as condições de iluminação, ou a distância para a câmera. Para fazer os rostos falsos se misturarem ao ambiente, eles têm que ser transformados geometricamente - girados, redimensionado ou distorcido. Esse processo deixa artefatos digitais na imagem resultante.

Você deve ter notado alguns artefatos de transformações particularmente severas. Isso pode fazer uma foto parecer obviamente adulterada, como bordas borradas e pele artificialmente lisa. Transformações mais sutis ainda deixam evidências, e ensinamos um algoritmo para detectá-lo, mesmo quando as pessoas não conseguem ver as diferenças.

Esses artefatos podem mudar se um vídeo deepfake tiver uma pessoa que não está olhando diretamente para a câmera. O vídeo que captura uma pessoa real mostra seu rosto se movendo em três dimensões, mas os algoritmos deepfake ainda não são capazes de fabricar faces em 3-D. Em vez de, eles geram uma imagem bidimensional regular do rosto e, em seguida, tentam girar, redimensione e distorça a imagem para se ajustar à direção para a qual a pessoa deve estar olhando.

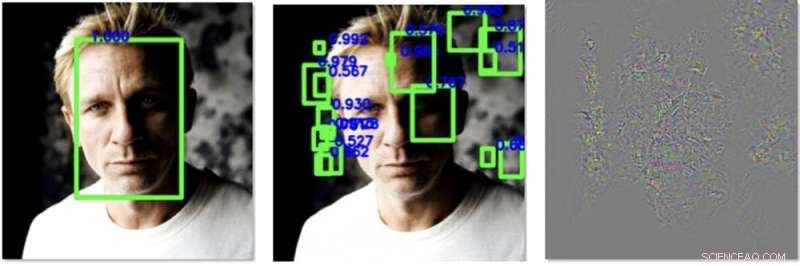

À esquerda, um rosto é facilmente detectado em uma imagem antes de nosso processamento. No meio, adicionamos perturbações que fazem com que um algoritmo detecte outras faces, mas não o real. À direita estão as alterações que adicionamos à imagem, aprimorado 30 vezes para ficar visível. Crédito:Siwei Lyu, CC BY-ND

Eles ainda não fazem isso muito bem, o que fornece uma oportunidade para detecção. Projetamos um algoritmo que calcula a direção que o nariz da pessoa está apontando em uma imagem. Ele também mede para que lado a cabeça está apontando, calculado usando o contorno do rosto. Em um vídeo real da cabeça de uma pessoa real, todos eles devem se alinhar de forma bastante previsível. Em deepfakes, no entanto, muitas vezes estão desalinhados.

Defesa contra deepfakes

A ciência da detecção de deepfakes é, efetivamente, uma corrida armamentista - os fingidores ficarão melhores em fazer suas ficções, e, portanto, nossa pesquisa sempre deve tentar acompanhar, e até mesmo ficar um pouco à frente.

Se houvesse uma maneira de influenciar os algoritmos que criam deepfakes para serem piores em suas tarefas, tornaria nosso método melhor na detecção de falsificações. Meu grupo encontrou recentemente uma maneira de fazer exatamente isso.

Bibliotecas de imagens de rostos são montadas por algoritmos que processam milhares de fotos e vídeos online e usam aprendizado de máquina para detectar e extrair rostos. Um computador pode olhar para a foto de uma turma e detectar os rostos de todos os alunos e do professor, e adicione apenas esses rostos à biblioteca. Quando a biblioteca resultante tem muitas imagens de rosto de alta qualidade, o deepfake resultante tem mais chances de enganar o público.

Descobrimos uma maneira de adicionar ruído especialmente projetado para fotos ou vídeos digitais que não são visíveis aos olhos humanos, mas podem enganar os algoritmos de detecção de rosto. Ele pode ocultar os padrões de pixel que os detectores de rosto usam para localizar um rosto, e cria iscas que sugerem que existe um rosto onde não existe um, como em um pedaço do fundo ou um quadrado da roupa de uma pessoa.

Com menos faces reais e mais não faces poluindo os dados de treinamento, um algoritmo deepfake será pior para gerar uma cara falsa. Isso não apenas retarda o processo de falsificação profunda, mas também torna o deepfake resultante mais falho e mais fácil de detectar.

À medida que desenvolvemos este algoritmo, esperamos poder aplicá-lo a quaisquer imagens que alguém esteja enviando para a mídia social ou outro site online. Durante o processo de upload, possivelmente, eles podem ser questionados, "Você quer proteger os rostos neste vídeo ou imagem contra o uso em deepfakes?" Se o usuário escolher sim, então o algoritmo poderia adicionar o ruído digital, permitindo que as pessoas online vejam os rostos, mas efetivamente ocultando-os de algoritmos que podem tentar se passar por eles.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.