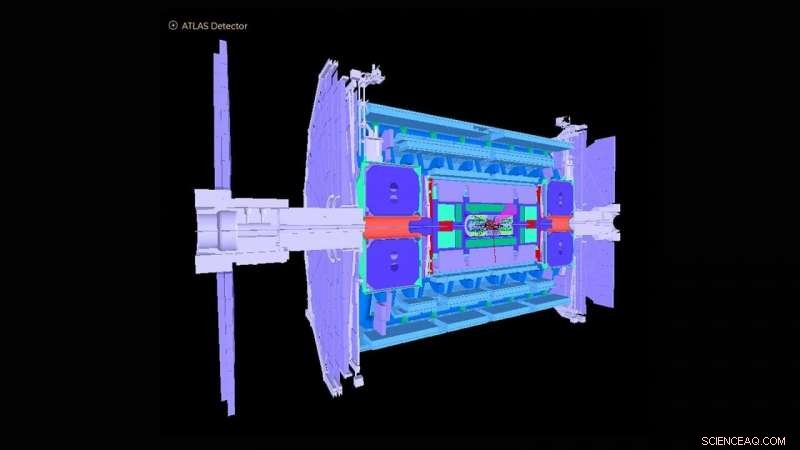

Esquemático do detector ATLAS no Large Hadron Collider. Crédito:ATLAS Collaboration

O Grande Colisor de Hádrons (LHC) perto de Genebra, A Suíça ficou famosa em todo o mundo em 2012 com a detecção do bóson de Higgs. A observação marcou uma confirmação crucial do Modelo Padrão da física de partículas, que organiza as partículas subatômicas em grupos semelhantes aos elementos da tabela periódica da química.

O Laboratório Nacional de Argonne do Departamento de Energia dos EUA (DOE) fez muitas contribuições essenciais para a construção e operação do detector experimental ATLAS no LHC e para a análise dos sinais registrados pelo detector que revelam a física subjacente das colisões de partículas. Argonne está agora desempenhando um papel de liderança na atualização de alta luminosidade do detector ATLAS para operações que estão planejadas para começar em 2027. Para esse fim, uma equipe de físicos e cientistas computacionais de Argonne desenvolveu um algoritmo baseado em aprendizado de máquina que se aproxima de como o detector atual responderia ao grande aumento de dados esperado com a atualização.

Como a maior máquina de física já construída, o LHC dispara dois feixes de prótons em direções opostas em torno de um anel de 17 milhas até que se aproximem da velocidade da luz, os esmaga e analisa os produtos de colisão com detectores gigantes como o ATLAS. O instrumento ATLAS tem aproximadamente a altura de um prédio de seis andares e pesa aproximadamente 7, 000 toneladas. Hoje, o LHC continua a estudar o bóson de Higgs, bem como abordar questões fundamentais sobre como e por que a matéria no universo é do jeito que é.

"A maioria das questões de pesquisa na ATLAS envolve encontrar uma agulha em um palheiro gigante, onde os cientistas estão interessados apenas em encontrar um evento ocorrendo entre um bilhão de outros, "disse Walter Hopkins, físico assistente na divisão de Física de Altas Energias (HEP) de Argonne.

Como parte da atualização do LHC, os esforços agora estão progredindo para aumentar a luminosidade do LHC - o número de interações próton-próton por colisão dos dois feixes de prótons - por um fator de cinco. Isso produzirá cerca de 10 vezes mais dados por ano do que os atualmente adquiridos pelos experimentos do LHC. Ainda é preciso entender como os detectores respondem a esse aumento na taxa de eventos. Isso requer a execução de simulações de computador de alto desempenho dos detectores para avaliar com precisão os processos conhecidos resultantes das colisões do LHC. Essas simulações em grande escala são caras e exigem grande parte do tempo de computação nos melhores e mais poderosos supercomputadores do mundo.

A equipe de Argonne criou um algoritmo de aprendizado de máquina que será executado como uma simulação preliminar antes de qualquer simulação em escala real. Este algoritmo aproxima, de maneiras muito rápidas e menos dispendiosas, como o detector atual responderia ao grande aumento de dados esperado com a atualização. Envolve a simulação das respostas do detector a um experimento de colisão de partículas e a reconstrução de objetos a partir dos processos físicos. Esses objetos reconstruídos incluem jatos ou borrifos de partículas, bem como partículas individuais como elétrons e múons.

"A descoberta de uma nova física no LHC e em outros lugares exige métodos cada vez mais complexos para análises de big data, "disse Doug Benjamin, um cientista computacional no HEP. "Atualmente, isso geralmente significa o uso de aprendizado de máquina e outras técnicas de inteligência artificial."

Os métodos de análise usados anteriormente para simulações iniciais não empregaram algoritmos de aprendizado de máquina e são demorados porque envolvem a atualização manual de parâmetros experimentais quando as condições no LHC mudam. Alguns também podem perder correlações de dados importantes para um determinado conjunto de variáveis de entrada para um experimento. O algoritmo desenvolvido por Argonne aprende, em tempo real enquanto um procedimento de treinamento é aplicado, os vários recursos que precisam ser introduzidos por meio de simulações completas detalhadas, evitando assim a necessidade de parâmetros experimentais artesanais. O método também pode capturar interdependências complexas de variáveis que não eram possíveis antes.

"Com nossa simulação simplificada, você pode aprender o básico com custo e tempo computacional relativamente baixos, então você pode prosseguir com muito mais eficiência com simulações completas em uma data posterior, "disse Hopkins." Nosso algoritmo de aprendizado de máquina também fornece aos usuários um poder de discriminação melhor sobre onde procurar eventos novos ou raros em um experimento, " ele adicionou.

O algoritmo da equipe pode ser inestimável não apenas para ATLAS, mas para os vários detectores experimentais no LHC, bem como outros experimentos de física de partículas agora sendo conduzidos ao redor do mundo.

Este estudo, intitulado "Simulação de detector automatizado e parametrização de reconstrução usando aprendizado de máquina, "apareceu no Jornal de Instrumentação .