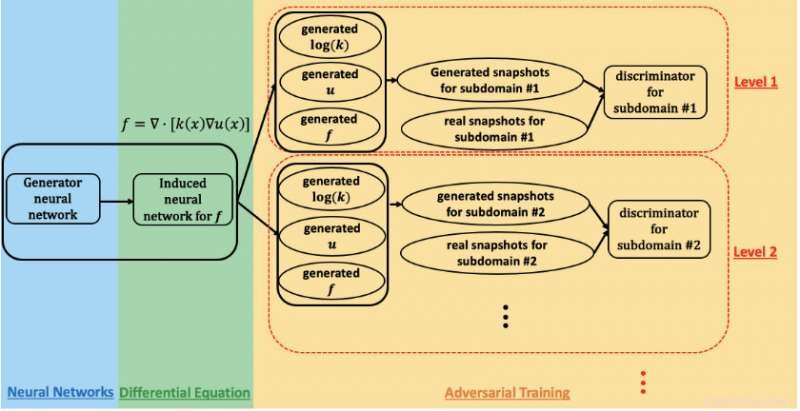

Um esquema da rede adversarial gerativa informada pela física usada para estimar parâmetros e quantificar a incerteza no fluxo subterrâneo no local de Hanford. Crédito:Prabhat, Laboratório Nacional Lawrence Berkeley

Uma colaboração de pesquisa entre Lawrence Berkeley National Laboratory (Berkeley Lab), Laboratório Nacional do Noroeste do Pacífico (PNNL), Brown University, e a NVIDIA obteve desempenho exaflop no supercomputador Summit com um aplicativo de aprendizado profundo usado para modelar o fluxo de subsuperfície no estudo de remediação de lixo nuclear. Sua conquista, que será apresentado durante o workshop "Deep Learning on Supercomputers" no SC19, demonstra a promessa de redes adversárias gerativas (GANs) informadas sobre a física para analisar complexos, problemas científicos em grande escala.

"Na ciência, conhecemos as leis da física e os princípios de observação - massa, impulso, energia, etc, "disse George Karniadakis, professor de matemática aplicada na Brown e co-autor do workshop SC19. "O conceito de GANs informados sobre a física é codificar informações anteriores da física na rede neural. Isso permite que você vá muito além do domínio de treinamento, o que é muito importante em aplicações onde as condições podem mudar. "

Os GANs foram aplicados para modelar a aparência do rosto humano com notável precisão, observou Prabhat, um co-autor do artigo SC19 que lidera a equipe de Data and Analytics Services no Centro Nacional de Pesquisa de Energia e Computação Científica do Berkeley Lab. "Em ciência, O Berkeley Lab explorou a aplicação de GANs vanilla para a criação de universos sintéticos e experimentos de física de partículas; um dos desafios abertos até agora tem sido a incorporação de restrições físicas nas previsões, "disse ele." George e seu grupo na Brown foram os pioneiros na abordagem de incorporar física aos GANs e usá-los para sintetizar dados - neste caso, campos de fluxo subterrâneo. "

Para este estudo, os pesquisadores se concentraram no site Hanford, estabelecido em 1943 como parte do Projeto Manhattan para produzir plutônio para armas nucleares e, eventualmente, abriga o primeiro reator de produção de plutônio em escala real do mundo, oito outros reatores nucleares, e cinco complexos de processamento de plutônio. Quando a produção de plutônio terminou em 1989, foram deixados para trás dezenas de milhões de galões de resíduos radioativos e químicos em grandes tanques subterrâneos e mais de 100 milhas quadradas de águas subterrâneas contaminadas resultantes do descarte de cerca de 450 bilhões de galões de líquidos em locais de disposição no solo. Portanto, nos últimos 30 anos, o Departamento de Energia dos EUA tem trabalhado com a Agência de Proteção Ambiental e o Departamento de Ecologia do Estado de Washington para limpar Hanford, que está localizado em 580 milhas quadradas (quase 500, 000 acres) no centro-sul de Washington, partes inteiras dele adjacentes ao rio Columbia - o maior rio do noroeste do Pacífico e uma via crítica para a indústria e a vida selvagem.

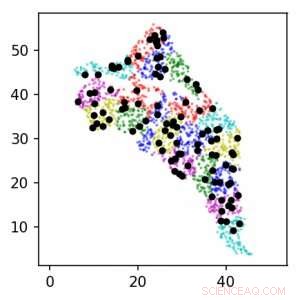

Usando GANs informados sobre a física no supercomputador Summit, a equipe de pesquisa foi capaz de estimar parâmetros e quantificar a incerteza no fluxo subterrâneo. Esta imagem mostra a localização dos sensores ao redor do local de Hanford para os níveis 1 (preto) e 2 (colorido). As unidades estão em km. Crédito:Laboratório Nacional Lawrence Berkeley

Para rastrear o esforço de limpeza, os trabalhadores confiaram na perfuração de poços no local de Hanford e na colocação de sensores nesses poços para coletar dados sobre propriedades geológicas e fluxo de água subterrânea e observar a progressão de contaminantes. Ambientes de subsuperfície, como o Site Hanford, são muito heterogêneos, com propriedades espaciais variáveis, explicou Alex Tartakovsky, um matemático computacional no PNNL e co-autor no artigo SC19. "Estimar as propriedades do local de Hanford a partir de dados apenas exigiria mais de um milhão de medições, e na prática temos talvez mil. As leis da física nos ajudam a compensar a falta de dados. "

"A abordagem de estimativa de parâmetro padrão é assumir que os parâmetros podem assumir muitas formas diferentes, e então, para cada forma, você deve resolver equações de fluxo subterrâneo, talvez milhões de vezes, para determinar os parâmetros que melhor se ajustam às observações, "Tartakovsky acrescentou. Mas para este estudo a equipe de pesquisa tomou uma direção diferente:usando um GAN informado pela física e computação de alto desempenho para estimar parâmetros e quantificar a incerteza no fluxo subterrâneo.

Para este trabalho de validação inicial, os pesquisadores optaram por usar dados sintéticos - dados gerados por um modelo computado com base no conhecimento de especialistas sobre o site Hanford. Isso permitiu que eles criassem uma representação virtual do local que eles poderiam manipular conforme necessário com base nos parâmetros que estavam interessados em medir - principalmente condutividade hidráulica e carga hidráulica, ambos são essenciais para modelar a localização dos contaminantes. Estudos futuros incorporarão dados de sensores reais e condições do mundo real.

"O objetivo inicial deste projeto era estimar a precisão dos métodos, então usamos dados sintéticos em vez de medições reais, "Tartakovsky disse." Isso nos permitiu estimar o desempenho do GANS informado pela física como uma função do número de medições. "

Ao treinar o GAN no supercomputador Summit no Oak Ridge Leadership Computing Facility OLCF, a equipe conseguiu atingir 1,2 pico exaflop e desempenho sustentado - o primeiro exemplo de uma arquitetura GAN em grande escala aplicada a SPDEs. A extensão geográfica, heterogeneidade espacial, e várias escalas de comprimento de correlação do local de Hanford exigiram o treinamento do modelo GAN para milhares de dimensões, então a equipe desenvolveu uma implementação altamente otimizada que foi dimensionada para 27, 504 GPUs NVIDIA V100 Tensor Core e 4, 584 nós no Summit com uma eficiência de escala de 93,1%.

"Alcançar uma escala e desempenho tão massivos exigiu a otimização total da pilha e várias estratégias para extrair o paralelismo máximo, "disse Mike Houston, que lidera a equipe de AI Systems da NVIDIA. "No nível do chip, otimizamos a estrutura e o design da rede neural para maximizar a utilização do Tensor Core por meio do suporte cuDNN no TensorFlow. No nível do nó, usamos NCCL e NVLink para troca de dados em alta velocidade. E no nível do sistema, otimizamos o Horovod e o MPI não apenas para combinar os dados e modelos, mas também para lidar com as estratégias paralelas do adversário. Para maximizar a utilização de nossas GPUs, tivemos que fragmentar os dados e depois distribuí-los para alinhá-los com a técnica de paralelização. "

"Este é um novo marco para as arquiteturas GAN, "Prabhat disse." Queríamos criar um substituto barato para uma simulação muito cara, e o que pudemos mostrar aqui é que uma arquitetura GAN restrita pela física pode produzir campos espaciais consistentes com nosso conhecimento de física. Além disso, este projeto exemplar reuniu especialistas em modelagem de subsuperfície, matemática Aplicada, aprendizado profundo, e HPC. Como o DOE considera aplicações mais amplas de aprendizagem profunda - e, em particular, GANs - para problemas de simulação, Espero que várias equipes de pesquisa sejam inspiradas por esses resultados. "

O papel, "Altamente escalonável, GANs com base em física para soluções de aprendizagem de PDEs estocásticos, "será apresentado no workshop SC19 Deep Learning on Supercomputers. I