No jogo de exploração escoteira, para se alinhar aos valores humanos, o robô aprende com o feedback humano às propostas. Crédito da imagem:Sra. Zhen Chen@BIGAI.

Os métodos de inteligência artificial (IA) tornaram-se cada vez mais avançados nas últimas décadas, alcançando resultados notáveis em muitas tarefas do mundo real. No entanto, a maioria dos sistemas de IA existentes não compartilha suas análises e as etapas que levaram às suas previsões com usuários humanos, o que pode tornar a avaliação confiável deles extremamente desafiadora.

Um grupo de pesquisadores da UCLA, UCSD, Peking University e Beijing Institute for General Artificial Intelligence (BIGAI) desenvolveu recentemente um novo sistema de IA que pode explicar seus processos de tomada de decisão para usuários humanos. Este sistema, introduzido em um artigo publicado na

Science Robotics , pode ser um novo passo para a criação de uma IA mais confiável e compreensível.

"O campo de IA explicável (XAI) visa construir confiança colaborativa entre robôs e humanos, e o Projeto DARPA XAI serviu como um grande catalisador para o avanço da pesquisa nessa área", Dr. Luyao Yuan, um dos primeiros autores do artigo. , disse ao TechXplore. "No início do projeto DARPA XAI, as equipes de pesquisa se concentram principalmente na inspeção de modelos para tarefas de classificação, revelando o processo de decisão dos sistemas de IA ao usuário; por exemplo, alguns modelos podem visualizar certas camadas de modelos CNN, alegando atingir um determinado nível de XAI."

Dr. Yuan e seus colegas participaram do projeto DARPA XAI, que visava especificamente o desenvolvimento de novos e promissores sistemas XAI. Ao participar do projeto, eles começaram a refletir sobre o que XAI significaria em um sentido mais amplo, particularmente sobre os efeitos que poderia ter nas colaborações entre humanos e máquinas.

O artigo recente da equipe se baseia em um de seus trabalhos anteriores, também publicado na

Science Robotics , onde a equipe explorou o impacto que os sistemas explicáveis podem ter nas percepções e na confiança de um usuário na IA durante as interações homem-máquina. Em seu estudo anterior, a equipe implementou e testou um sistema de IA fisicamente (ou seja, no mundo real), enquanto em seu novo estudo eles o testaram em simulações.

"Nosso paradigma contrasta com quase todos aqueles propostos por equipes no programa DARPA XAI, que se concentrava principalmente no que chamamos de paradigma de usuário ativo de máquina passiva", disse o professor Yixin Zhu, um dos supervisores do projeto, ao TechXplore. "Nesses paradigmas, os usuários humanos precisam verificar ativamente e tentar descobrir o que a máquina está fazendo (portanto, 'usuário ativo'), aproveitando alguns modelos que revelam o potencial processo de tomada de decisão dos modelos de IA".

Os sistemas XAI que seguem o que o Prof. Zhu chama de paradigma de "usuário ativo de máquina passiva" exigem que os usuários façam check-in constante com a IA para entender os processos por trás de suas decisões. Nesse contexto, a compreensão de um usuário dos processos de uma IA e a confiança em suas previsões não afetam os futuros processos de tomada de decisão da IA, razão pela qual a máquina é chamada de "passiva".

Em contraste, o novo paradigma introduzido pelo Dr. Yuan, Prof. Zhu e seus colegas segue o que a equipe chama de paradigma de usuário ativo de máquina ativa. Isso significa essencialmente que seu sistema pode aprender ativamente e adaptar sua tomada de decisão com base no feedback que recebe dos usuários em tempo real. Essa capacidade de se adaptar contextualmente é característica do que é frequentemente chamado de terceira/próxima onda de IA.

"Para que os sistemas de IA ajudem seus usuários como esperamos, os sistemas atuais exigem que o usuário codifique objetivos definidos por especialistas", disse o Dr. Yuan. "Isso limita o potencial da equipe homem-máquina, pois esses objetivos podem ser difíceis de definir em muitas tarefas, tornando os sistemas de IA inacessíveis para a maioria das pessoas. Para resolver esse problema, nosso trabalho permite que os robôs estimem as intenções e os valores dos usuários durante a colaboração em tempo real, poupando a necessidade de codificar objetivos complicados e específicos para os robôs de antemão, proporcionando assim um melhor paradigma de equipe homem-máquina."

O objetivo do sistema criado pelo Dr. Yuan e seus colegas é atingir o chamado "alinhamento de valores". Isso significa essencialmente que um usuário humano pode entender por que um robô ou máquina está agindo de uma maneira específica ou chegando a conclusões específicas, e a máquina ou robô pode inferir por que o usuário humano está agindo de maneiras específicas. Isso pode melhorar significativamente a comunicação humano-robô.

"Esta natureza bidirecional e desempenho em tempo real são os maiores desafios do problema e o destaque de nossas contribuições", disse o Prof. Zhu. "Juntando os pontos acima, acho que agora você entenderá por que o título do nosso artigo é "Alinhamento de valor bidirecional humano-robô in situ".

Para treinar e testar seu sistema XAI, os pesquisadores projetaram um jogo chamado "exploração de batedores", no qual os humanos precisam concluir uma tarefa em equipes. Um dos aspectos mais importantes deste jogo é que os humanos e os robôs precisam alinhar suas chamadas "funções de valor".

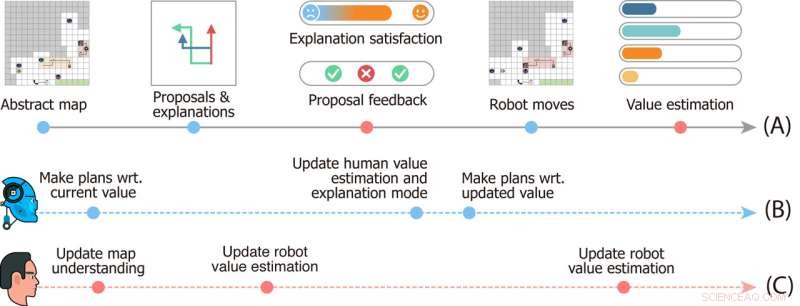

Projeto de estudo do Jogo de Exploração Escoteira. A linha do tempo (A) denota eventos que acontecem em uma única rodada do jogo. As linhas do tempo (B) e (C) retratam a dinâmica mental dos robôs e do usuário, respectivamente. Crédito da imagem:Sra. Zhen Chen@BIGAI.

"No jogo, um grupo de robôs pode perceber o ambiente; isso emula aplicações do mundo real onde o grupo de robôs deve trabalhar de forma autônoma para minimizar as intervenções humanas", disse Zhu. "O usuário humano, no entanto, não pode interagir diretamente com o ambiente; em vez disso, o usuário recebeu uma função de valor específica, representada pela importância de alguns fatores (por exemplo, o tempo total para concluir o tempo e os recursos coletados em movimento). )."

No jogo de exploração scout, a equipe de robôs não tem acesso à função de valor dada aos usuários humanos, e precisa inferi-la. Como esse valor não pode ser expresso e comunicado facilmente, para concluir a tarefa, o robô e a equipe humana devem inferir um do outro.

“A comunicação é bidirecional no jogo:por um lado, o robô propõe vários planos de tarefas ao usuário e explica os prós e contras de cada um deles, e por outro o usuário dá feedback sobre as propostas e avalia cada explicação, " Dr. Xiaofeng Gao, um dos primeiros autores do artigo, disse ao TechXplore. "Essas comunicações bidirecionais permitem o que é conhecido como alinhamento de valor."

Essencialmente, para concluir as tarefas de "exploração de batedores", a equipe de robôs deve entender qual função de valor dos usuários humanos é simplesmente baseada no feedback humano. Enquanto isso, os usuários humanos aprendem as estimativas de valor atuais dos robôs e podem oferecer feedback que os ajuda a melhorar e, em última análise, os orienta para a resposta correta.

"Também integramos a teoria da mente em nosso modelo computacional, possibilitando ao sistema de IA gerar explicações adequadas para revelar seu valor atual e estimar o valor dos usuários a partir de seu feedback em tempo real durante a interação", disse o Dr. Gao. "Em seguida, realizamos extensos estudos de usuários para avaliar nossa estrutura".

Nas avaliações iniciais, o sistema criado pelo Dr. Yuan, Prof. Zhu, Dr. Gao e seus colegas obteve resultados notáveis, levando ao alinhamento de valores no jogo de exploração escoteira de forma dinâmica e interativa. A equipe descobriu que o robô se alinhava com a função de valor do usuário humano já em 25% do jogo, enquanto os usuários podiam obter percepções precisas das funções de valor da máquina na metade do jogo.

"O emparelhamento de convergência (i) do valor dos robôs para os valores verdadeiros do usuário e (ii) da estimativa do usuário dos valores dos robôs para os valores atuais dos robôs forma um alinhamento de valor bidirecional ancorado pelo valor verdadeiro do usuário", disse o Dr. disse Yuan. “Acreditamos que nossa estrutura destaca a necessidade de construir máquinas inteligentes que aprendam e entendam nossas intenções e valores por meio de interações, que são críticas para evitar muitas das histórias distópicas de ficção científica retratadas em romances e na tela grande”.

O trabalho recente dessa equipe de pesquisadores é uma contribuição significativa para a área de pesquisa com foco no desenvolvimento de IA mais compreensível. O sistema que eles propuseram pode servir de inspiração para a criação de outros sistemas XAI onde robôs ou assistentes inteligentes se envolvam ativamente com humanos, compartilhando seus processos e melhorando seu desempenho com base no feedback que recebem dos usuários.

"O alinhamento de valor é nosso primeiro passo para a colaboração genérica entre humanos e robôs", explicou o Dr. Yuan. "Neste trabalho, o alinhamento de valor acontece no contexto de uma única tarefa. No entanto, em muitos casos, um grupo de agentes coopera em muitas tarefas. Por exemplo, esperamos que um robô doméstico nos ajude em muitas tarefas diárias, em vez de comprar muitos robôs, cada um capaz de fazer apenas um tipo de trabalho."

Até agora, o sistema XAI dos pesquisadores alcançou resultados altamente promissores. Em seus próximos estudos, Dr. Yuan, Prof. Zhu, Dr. Gao e seus colegas planejam explorar instâncias de alinhamento de valor humano-robô que podem ser aplicadas em muitas tarefas diferentes do mundo real, para que usuários humanos e agentes de IA possam acumular informações que eles adquiriram sobre os processos e capacidades uns dos outros à medida que colaboram em diferentes tarefas.

"Em nossos próximos estudos, também procuramos aplicar nossa estrutura a mais tarefas e robôs físicos", disse o Dr. Gao. “Além dos valores, acreditamos que alinhar outros aspectos dos modelos mentais (por exemplo, crenças, desejos, intenções) entre humanos e robôs também seria uma direção promissora”.

Os pesquisadores esperam que seu novo paradigma de IA explicável ajude a melhorar a colaboração entre humanos e máquinas em várias tarefas. Além disso, eles esperam que sua abordagem aumente a confiança dos humanos em sistemas baseados em IA, incluindo assistentes inteligentes, robôs, bots e outros agentes virtuais.

"Por exemplo, você pode corrigir o Alexa ou o Google Home quando ele cometer um erro, mas ele cometerá o mesmo erro na próxima vez que você usá-lo", acrescentou o Prof. Zhu. "Quando seu Roomba vai a algum lugar que você não quer que ele vá e tenta combatê-lo, ele não entende, pois apenas segue a lógica de IA predefinida. Tudo isso proíbe a IA moderna de entrar em nossas casas. Como o primeiro passo, nosso trabalho mostra o potencial de resolver esses problemas, um passo mais perto de alcançar o que a DARPA chamou de 'adaptação contextual' na terceira onda de IA".

+ Explorar mais Permitir que robôs sociais aprendam as relações entre as rotinas dos usuários e seu humor

© 2022 Science X Network