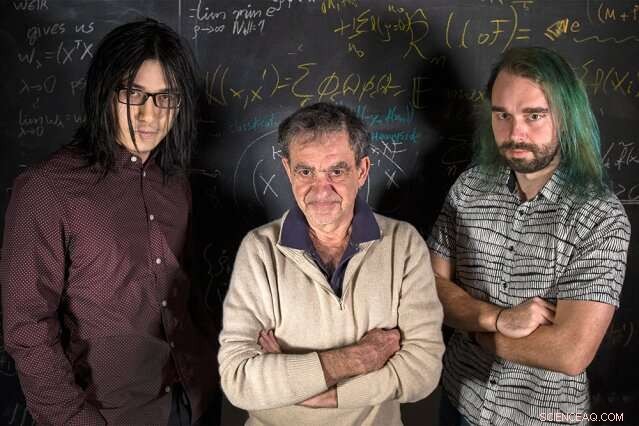

p Pesquisadores do MIT (da esquerda para a direita) Qianli Liao, Tomaso Poggio, e Andrzej Banburski estão com suas equações. Crédito:Kris Brewer

p Pesquisadores do MIT (da esquerda para a direita) Qianli Liao, Tomaso Poggio, e Andrzej Banburski estão com suas equações. Crédito:Kris Brewer

p Cursos introdutórios de estatística nos ensinam que, ao ajustar um modelo a alguns dados, devemos ter mais dados do que parâmetros livres para evitar o perigo de overfitting - ajustar dados ruidosos demais, e, portanto, deixando de ajustar novos dados. É surpreendente, então, que no aprendizado profundo moderno a prática é ter ordens de magnitude mais parâmetros do que dados. Apesar disso, redes profundas mostram bom desempenho preditivo, e, de fato, melhoram quanto mais parâmetros eles têm. Por que isso seria? p Já se sabe há algum tempo que um bom desempenho no aprendizado de máquina vem do controle da complexidade das redes, que não é apenas uma função simples do número de parâmetros livres. A complexidade de um classificador, como uma rede neural, depende da medição do “tamanho” do espaço de funções que esta rede representa, com várias medidas técnicas sugeridas anteriormente:dimensão Vapnik – Chervonenkis, cobrindo números, ou complexidade Rademacher, para nomear alguns. Complexidade, conforme medido por essas noções, pode ser controlado durante o processo de aprendizagem, impondo uma restrição à norma dos parâmetros - em suma, sobre o quão "grande" eles podem ficar. O fato surpreendente é que nenhuma restrição explícita parece ser necessária no treinamento de redes profundas. O aprendizado profundo está fora da teoria clássica do aprendizado? Precisamos repensar os fundamentos?

p Em um novo artigo da Nature Communications, "Controle de complexidade por gradiente descendente em redes profundas, "uma equipe do Center for Brains, Minds, e Máquinas lideradas pelo Diretor Tomaso Poggio, o professor Eugene McDermott do Departamento de Ciências do Cérebro e Cognitivas do MIT, lançou alguma luz sobre esse quebra-cabeça ao abordar as aplicações mais práticas e bem-sucedidas do aprendizado profundo moderno:problemas de classificação.

p "Para problemas de classificação, observamos que de fato os parâmetros do modelo não parecem convergir, mas, em vez disso, crescer em tamanho indefinidamente durante a descida do gradiente. Contudo, em problemas de classificação, apenas os parâmetros normalizados importam - ou seja, a direção que eles definem, não é o tamanho deles, "diz o co-autor e candidato a Ph.D. do MIT, Qianli Liao." A coisa não tão óbvia que mostramos é que a descida gradiente comumente usada nos parâmetros não normalizados induz o controle de complexidade desejado nos normalizados. "

p "Já sabemos há algum tempo, no caso de regressão para redes lineares rasas, como máquinas de kernel, que as iterações de gradiente descendente fornecem uma implícita, efeito de regularização de desaparecimento, "Poggio diz." Na verdade, neste caso simples, provavelmente sabemos que obtemos a margem máxima de melhor comportamento, solução de norma mínima. A pergunta que nos perguntamos, então, foi:Algo semelhante pode acontecer com redes profundas? "

p Os pesquisadores descobriram que sim. Como co-autor e pós-doutorado do MIT, Andrzej Banburski explica, "Compreender a convergência em redes profundas mostra que há direções claras para melhorar nossos algoritmos. Na verdade, já vimos indícios de que controlar a taxa em que esses parâmetros não normalizados divergem nos permite encontrar soluções de melhor desempenho e encontrá-los mais rapidamente. "

p O que isso significa para o aprendizado de máquina? Não há mágica por trás de redes profundas. A mesma teoria por trás de todos os modelos lineares também está em jogo aqui. Este trabalho sugere maneiras de melhorar redes profundas, tornando-os mais precisos e rápidos de treinar. p

Esta história foi republicada por cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisas do MIT, inovação e ensino.