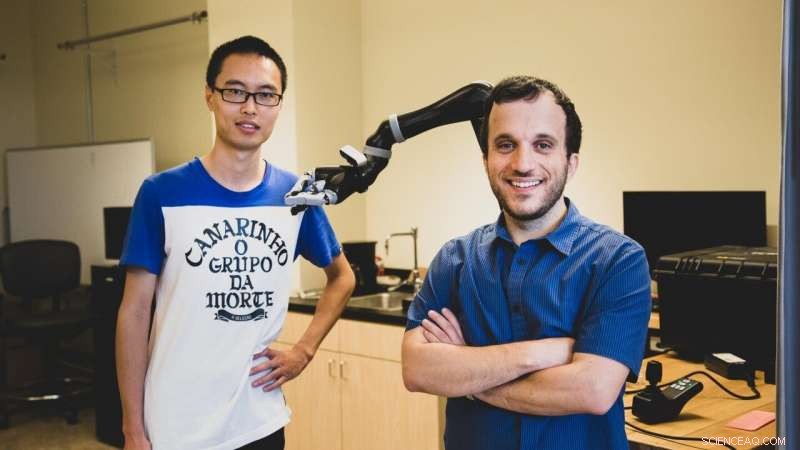

O estudante de doutorado da USC Jiali Duan (à esquerda) e Stefanos Nikolaidis, um professor assistente em ciência da computação, usar aprendizagem por reforço, uma técnica na qual os programas de inteligência artificial "aprendem" com a experimentação repetida. Crédito:Haotian Mai.

De acordo com um novo estudo realizado por cientistas da computação da USC, para ajudar um robô a ter sucesso, talvez você precise mostrar a ele um amor forte.

Em uma tarefa de manipulação simulada por computador, os pesquisadores descobriram que treinar um robô com um adversário humano melhorou significativamente sua compreensão de objetos.

"Este é o primeiro esforço de aprendizagem de robôs usando usuários humanos adversários, "disse o co-autor do estudo Stefanos Nikolaidis, professor assistente de ciência da computação.

"Imagine como se estivesse jogando um esporte:se você está jogando tênis com alguém que sempre permite que você ganhe, você não vai melhorar. O mesmo acontece com os robôs. Se quisermos que eles aprendam uma tarefa de manipulação, como agarrar, para que possam ajudar as pessoas, precisamos desafiá-los. "

O estudo, "Aprendizagem de robôs por meio de jogos humanos adversários, "foi apresentado em 4 de novembro na Conferência Internacional sobre Robôs e Sistemas Inteligentes. Os alunos de Ph.D. da USC Jiali Duan e Qian Wang são os autores principais, aconselhado pelo Professor C. C. Jay Kuo, com o co-autor adicional Lerrel Pinto da Carnegie Mellon University.

Aprendendo com a prática

Nikolaidis, que ingressou na Escola de Engenharia USC Viterbi em 2018, e sua equipe usa aprendizagem por reforço, uma técnica na qual os programas de inteligência artificial "aprendem" com a experimentação repetida.

Em vez de se limitar a completar uma pequena gama de tarefas repetitivas, como robôs industriais, o sistema robótico "aprende" com base em exemplos anteriores, em teoria, aumentando a gama de tarefas que pode realizar.

Mas criar robôs de uso geral é notoriamente desafiador, devido em parte à quantidade de treinamento necessária. Os sistemas robóticos precisam ver um grande número de exemplos para aprender como manipular um objeto de maneira humana.

Por exemplo, O impressionante sistema robótico da OpenAI aprendeu a resolver um cubo de Rubik com uma mão humanóide, mas exigia o equivalente a 10, 000 anos de treinamento simulado para aprender a manipular o cubo.

Mais importante, a destreza do robô é muito específica. Sem treinamento extensivo, não pode pegar um objeto, manipule-o com outra pegada, ou agarrar e manusear um objeto diferente.

"Como um humano, mesmo se eu souber a localização do objeto, Não sei exatamente quanto pesa ou como se moverá ou se comportará quando eu o pegar, ainda assim fazemos isso com sucesso quase o tempo todo, "disse Nikolaidis.

"Isso porque as pessoas são muito intuitivas sobre como o mundo se comporta, mas o robô é como um bebê recém-nascido. "

Em outras palavras, sistemas robóticos acham difícil generalizar, uma habilidade que os humanos consideram natural. Isso pode parecer trivial, mas pode ter consequências graves. Se dispositivos robóticos assistivos, como robôs agarradores, são para cumprir sua promessa de ajudar as pessoas com deficiência, os sistemas robóticos devem ser capazes de operar de forma confiável em ambientes do mundo real.

Humano no circuito

Uma linha de pesquisa que tem sido bem-sucedida em superar esse problema é ter um "ser humano no circuito". Em outras palavras, o humano fornece feedback ao sistema robótico, demonstrando a capacidade de concluir a tarefa.

Mas, até agora, esses algoritmos fizeram uma forte suposição de um supervisor humano cooperante auxiliando o robô.

"Sempre trabalhei na colaboração humano-robô, Mas na realidade, as pessoas nem sempre serão colaboradores de robôs na selva, "disse Nikolaidis.

Como um exemplo, ele aponta para um estudo de pesquisadores japoneses, que soltou um robô em um complexo comercial público e observou crianças "agindo violentamente" em relação a ele em várias ocasiões.

Então, pensou Nikolaidis, e se, em vez disso, alavancássemos nossa inclinação humana para tornar as coisas mais difíceis para o robô? Em vez de mostrar como agarrar melhor um objeto, e se tentássemos puxá-lo para longe? Adicionando desafio, o pensamento vai, o sistema aprenderia a ser mais robusto para a complexidade do mundo real.

Elemento de desafio

O experimento foi mais ou menos assim:em uma simulação de computador, o robô tenta agarrar um objeto. O humano, no computador, observa o aperto do robô simulado. Se a pegada for bem-sucedida, o humano tenta arrancar o objeto das mãos do robô, usando o teclado para sinalizar a direção.

Adicionar este elemento de desafio ajuda o robô a aprender a diferença entre um aperto fraco (digamos, segurando uma garrafa no topo), versus um aperto firme (segurando no meio), o que torna muito mais difícil para o adversário humano arrebatar.

Foi uma ideia meio maluca, admite Nikolaidis, mas funcionou.

Os pesquisadores descobriram que o sistema treinado com o adversário humano rejeitou agarrões instáveis, e rapidamente aprendeu agarramentos robustos para esses objetos. Em um experimento, o modelo alcançou uma taxa de sucesso de agarramento de 52% com um adversário humano contra uma taxa de sucesso de agarramento de 26,5% com um colaborador humano.

"O robô aprendeu não apenas como agarrar objetos de forma mais robusta, mas também para ter sucesso com mais frequência com novos objetos em uma orientação diferente, porque aprendeu uma compreensão mais estável, "disse Nikolaidis.

Eles também descobriram que o modelo treinado com um adversário humano teve um desempenho melhor do que um adversário simulado, que teve uma taxa de sucesso de agarramento de 28%. Então, os sistemas robóticos aprendem melhor com adversários de carne e osso.

"Isso porque os humanos podem entender estabilidade e robustez melhor do que adversários eruditos, "explicou Nikolaidis.

"O robô tenta pegar coisas e, se o humano tentar atrapalhar, leva a agarramentos mais estáveis. E porque aprendeu uma compreensão mais estável, terá sucesso com mais frequência, mesmo se o objeto estiver em uma posição diferente. Em outras palavras, aprendeu a generalizar. Isso é um grande negócio. "

Encontrar um equilíbrio

Nikolaidis espera que o sistema funcione em um braço robótico real dentro de um ano. Isso apresentará um novo desafio - no mundo real, o menor atrito ou ruído nas articulações de um robô pode confundir as coisas. Mas Nikolaidis está esperançoso quanto ao futuro do aprendizado adversarial para a robótica.

"Acho que acabamos de arranhar a superfície das aplicações potenciais da aprendizagem por meio de jogos humanos adversários, "disse Nikolaidis.

"Estamos empolgados para explorar o aprendizado adversário humano no circuito em outras tarefas também, como evitar obstáculos para braços robóticos e robôs móveis, como carros autônomos. "

Isso levanta a questão:até onde estamos dispostos a levar o aprendizado do adversário? Estaríamos dispostos a chutar e vencer os robôs até a submissão? A resposta, disse Nikolaidis, reside em encontrar um equilíbrio de amor duro e incentivo com nossos colegas da robótica.

"Eu sinto que o amor duro - no contexto do algoritmo que propomos - é novamente como um esporte:ele se enquadra em regras e restrições específicas, "disse Nikolaidis.

"Se o humano quebrar a garra do robô, o robô falhará continuamente e nunca aprenderá. Em outras palavras, o robô precisa ser desafiado, mas ainda ter permissão para ter sucesso para aprender. "