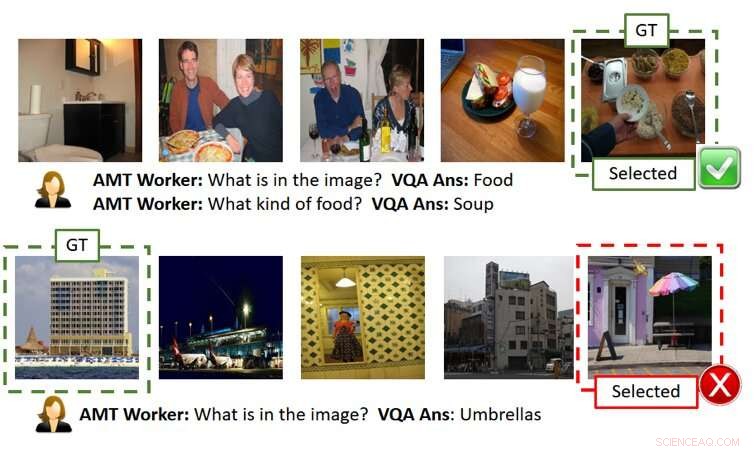

A figura acima mostra dois jogos sem explicações (cada linha é um exemplo de jogo). Conforme mostrado na linha superior, o usuário (ou seja, O AMT Worker, uma vez que usamos o Amazon Mechanical Turk para avaliação em grande escala com base em crowd-source, é capaz de descobrir a imagem secreta corretamente com respostas de IA precisas. Contudo, como mostrado na linha inferior, o usuário pode falhar mesmo quando as respostas de IA são razoáveis, mas um pouco fora do ponto (ou seja, há uma estrutura que parece um guarda-chuva ao lado do edifício, embora não seja o foco da imagem da verdade do terreno). GT significa Ground Truth (ou seja, a imagem secreta), Selecionada é a imagem selecionada pelo usuário após fazer as perguntas e obter as respostas e / ou explicações. Crédito:Ray et al.

Nos últimos anos, pesquisadores têm tentado tornar a inteligência artificial (IA) mais transparente, desenvolvendo algoritmos que podem explicar suas ações e comportamento, pois isso poderia encorajar uma maior confiança nas máquinas e aprimorar as interações humano-IA. Apesar de seus esforços, até agora, poucos estudos avaliaram de forma tangível o impacto das explicações da IA no desempenho alcançado em tarefas que envolvem a colaboração humano-IA.

Para resolver essa lacuna na literatura existente, uma equipe de pesquisadores da SRI International criou um jogo de adivinhação de imagens de AI inspirado no popular jogo 20 Questions (20Q), que pode ser usado para avaliar a utilidade das explicações da máquina. Seu papel, publicado recentemente no arXiv, está entre os primeiros a explorar os efeitos do desenvolvimento de IA mais "explicável".

"A ideia surgiu enquanto estávamos trabalhando em um projeto DARPA, "Arijit Ray, um cientista da computação da SRI International que realizou o estudo, disse TechXolore. "Neste projeto, estamos desenvolvendo sistemas de IA explicáveis, que não apenas geram a saída desejada (por exemplo, detecção de objeto, respostas a perguntas, etc.), mas também explicações de como chegaram a esse resultado. Precisávamos de um mecanismo para avaliar se as explicações adicionais fornecidas pelos IAs eram úteis para o usuário obter uma melhor compreensão dos sistemas de IA. Para este fim, criamos uma tarefa colaborativa humana-IA interativa, Adivinhação assistida por explicação qual (ExAG), que é uma adaptação do famoso jogo 20Q, para demonstrar a eficácia das várias técnicas de explicação de máquina que estamos desenvolvendo. "

O jogo de adivinhação de imagens desenvolvido por Ray e seus colegas se parece muito com o popular jogo 20 Questions, que geralmente envolve dois jogadores. No 20Q, um jogador pensa sobre algo e o segundo jogador tenta adivinhar o que é, fazendo 20 perguntas fechadas (ou seja, perguntas que só podem ser respondidas com 'sim' ou 'não').

No ExAG, a adaptação do jogo idealizada por Ray e seus colegas, um usuário vê cinco imagens, uma das quais foi escolhida pelo sistema de IA como a 'imagem secreta'. Essencialmente, o usuário precisa descobrir qual entre as fotos que viu é a 'imagem secreta, 'fazendo perguntas em linguagem natural sobre ele.

Em contraste com o jogo 20Q tradicional, no ExAG, os usuários humanos podem fazer perguntas fechadas e abertas. Por exemplo, eles poderiam perguntar 'o que está na imagem ?, '' onde a imagem foi tirada? ' e assim por diante. O sistema de IA responde às perguntas do usuário uma de cada vez e pode, opcionalmente, explicar suas respostas.

Com base nessas respostas, o usuário tentará adivinhar a imagem que a IA selecionou originalmente. O objetivo geral do jogo é identificar corretamente a 'imagem secreta' fazendo o mínimo de perguntas possível.

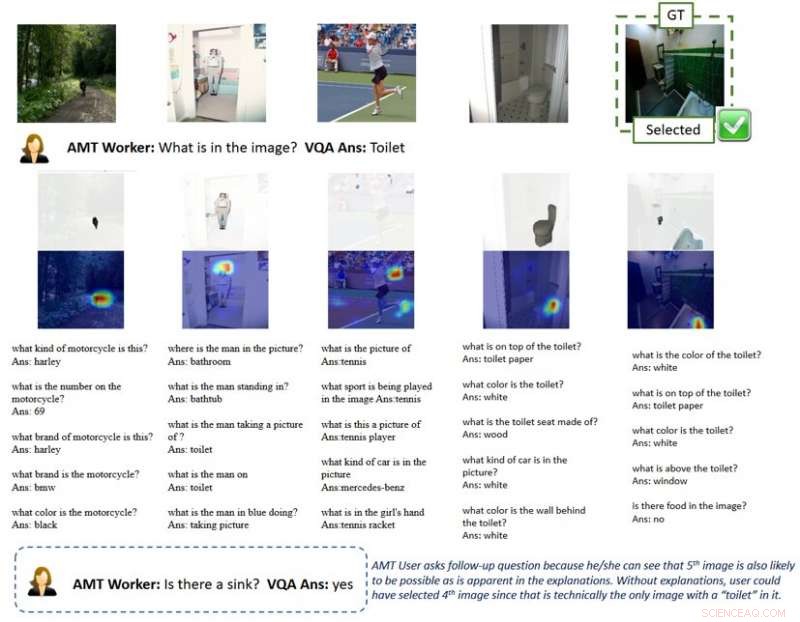

"O sistema AI oferece dois modos de explicação, visual e textual, "Ray explicou." Para explicações visuais, o sistema de IA gera mapas de calor destacando as regiões que suportam suas respostas. Por exemplo, se um usuário perguntar o que está na imagem, e parece um cachorro, a IA destacará a região do cachorro e dirá que isso é o que leva à resposta 'é um cachorro'. Para explicações textuais, por outro lado, o sistema de IA fornece respostas a perguntas relacionadas para cada uma das imagens. Então, se você perguntar o que uma pessoa está fazendo e a resposta for surfar, por exemplo, ele também responderá a perguntas relacionadas como 'o que vejo na imagem? Um surfista. ' 'Onde a foto é tirada? Uma praia.'

Devido à natureza do jogo de adivinhação de imagens, a qualidade das respostas e explicações fornecidas pela IA pode afetar significativamente o sucesso e o desempenho de um usuário humano. É importante notar que o desempenho atual de última geração em respostas visuais a perguntas está em torno de 65 por cento, o que significa que o sistema de IA gera respostas corretas 65 por cento das vezes.

Ray e seus colegas observaram que os usuários normalmente obtinham sucesso no ExAG aproveitando as explicações dos AIs, especialmente quando as próprias respostas estavam erradas. Por exemplo, se a 'imagem secreta' retrata um cachorro, mas a IA responde 'é um surfista, 'uma explicação visual pode ajudar um usuário humano a perceber o erro da IA. De acordo com os pesquisadores, isso prova que o jogo deles é uma ferramenta adequada para avaliar a utilidade das explicações da IA.

A figura acima mostra uma jogabilidade com explicações. A explicação visual do mapa de calor destaca as regiões nas imagens que levam às respostas de IA. Com tal explicação, os usuários entendem que os sistemas de IA podem pegar objetos que não são o foco principal da imagem na perspectiva humana ao responder a uma pergunta geral como "o que está na imagem". Isso sugere que o usuário faça perguntas de acompanhamento e, por fim, selecione a imagem secreta corretamente. GT significa Ground Truth (ou seja, a imagem secreta), Selecionada é a imagem selecionada pelo usuário após fazer as perguntas e obter as respostas e / ou explicações. Crédito:Ray et al.

"Na minha opinião, o resultado mais interessante do nosso estudo é que os usuários podem usar apenas algumas boas explicações para ganhar jogos quando as respostas de IA estão, em sua maioria, erradas, "Disse Ray." Em contraste, para jogos com precisão de resposta semelhante, mas sem explicações, os usuários confiam cegamente nas respostas geradas pela IA e perdem o jogo. Isso apóia a importância de algumas boas explicações para sistemas colaborativos de IA humana, especialmente quando o sistema de IA é imperfeito, o que acontece na maioria dos casos hoje em dia. "

Para explicar melhor essa ideia, Ray oferece o exemplo de veículos autônomos. Ao longo dos últimos anos, tem havido muito debate sobre sua segurança, também devido a acidentes ocorridos durante os testes dos veículos. De acordo com Ray, explicações eficazes de IA podem encorajar uma maior confiança na segurança de veículos autônomos, pois permitiriam que os motoristas humanos identificassem problemas com antecedência e evitassem acidentes.

"Por exemplo, vamos supor que o sistema de IA está tendo problemas para detectar as pistas de forma confiável, "Disse Ray." Como a estrada atualmente é reta, sem informações adicionais, o usuário não seria capaz de dizer se o AI está falhando. Mesmo que ele / ela tivesse algumas dúvidas, ele / ela provavelmente não faria nada até o último momento, quando o carro tem que fazer uma curva, não, e trava, o que seria tarde demais. Em contraste, se uma tela no carro mostrasse explicações de como a IA está percebendo o ambiente, como mapas de calor, o usuário seria capaz de identificar a falha latente da IA e assumir o controle da roda com antecedência. "

Os pesquisadores descobriram que explicações úteis afetaram positivamente o desempenho dos usuários humanos no jogo de adivinhação de imagens. Suas descobertas sugerem que ter pelo menos uma explicação "correta" foi significativamente útil, particularmente nos casos em que as respostas do AI às perguntas do usuário foram "barulhentas" ou mal definidas. Interessantemente, os jogadores desenvolveram uma preferência por explicações em vez de respostas e muitas vezes classificaram as explicações de IA como 'úteis'.

"Acho que, embora várias linhas de trabalho tentassem fornecer explicações para os resultados ou ações de um sistema de IA, nosso é o primeiro estudo a introduzir uma tarefa de colaboração humana e de máquina para avaliar a eficácia das explicações de IA; portanto, trouxe muitos insights sobre como as explicações da IA podem melhorar as interações entre humanos e robôs, "Yi Yao, um gerente técnico sênior da SRI International que estava envolvido no estudo, disse TechXplore.

O estudo realizado por Ray e seus colegas é um dos primeiros a fornecer evidências tangíveis da utilidade das explicações da IA. Os pesquisadores esperam que sua pesquisa venha a informar o desenvolvimento de sistemas de IA que podem agir racionalmente na sociedade, conectando-se e relacionando-se melhor assim com os humanos.

De acordo com Ray, Os sistemas de IA que podem explicar claramente o raciocínio e os processos por trás de suas ações seriam um passo significativo no desenvolvimento de máquinas inteligentes. Ao responder a perguntas de forma eficaz e racionalizar suas decisões, esses sistemas podem promover um maior senso de confiança na IA, bem como um relacionamento mais profundo com ele.

"Muitas outras empresas, grupos e grupos de pesquisa têm abordado IA explicável, e tem havido muitas propostas de como estender os modelos e sistemas de IA existentes para fornecer explicações aos usuários, "disse Giedrius Burachas, um cientista da computação sênior da SRI International e investigador principal por trás do estudo da DARPA que levou ao desenvolvimento do jogo Guess Which. "Embora muitas ideias tenham sido geradas, evidências de que essas ideias funcionavam estavam faltando, então, um dos lados fortes de nossa pesquisa é que ela fornece evidências indiscutíveis de que certos tipos de explicações são realmente muito eficazes para melhorar a colaboração com os sistemas de IA, mas também na construção de confiança neles. "

Até agora, o trabalho de Ray e seus colegas concentrava-se principalmente em tarefas de resposta a perguntas visuais (VQA), onde os usuários fazem perguntas sobre imagens e respostas de IA. Eles agora estão planejando continuar suas pesquisas em técnicas de explicação de IA, aplicando essas técnicas a um escopo mais amplo de tarefas de IA.

"Também continuaremos desenvolvendo protocolos para avaliar a eficácia das explicações geradas por IA com granularidade mais fina (por exemplo, qual explicação é mais eficaz em quais cenários?) E de diferentes perspectivas (por exemplo, as explicações ajudam os usuários a construir o modelo mental?), "Disse Ray." Para fechar o ciclo, usaremos as lições aprendidas com essas avaliações para desenvolver métodos de explicação mais eficazes. Acreditamos que o Santo Graal da IA explicável é conceber explicações que não apenas informem os usuários, mas também melhorem o desempenho da máquina, melhorando sua capacidade de raciocínio. "

Além de explorar os efeitos das explicações da IA sobre o desempenho e as percepções dos usuários humanos, Portanto, os pesquisadores gostariam de investigar seu impacto nos próprios sistemas de IA. Eles acham que as explicações de IA também podem tornar os sistemas de IA inerentemente melhores, pois eles iriam gradualmente adquirir habilidades de raciocínio e racionalização.

© 2019 Science X Network