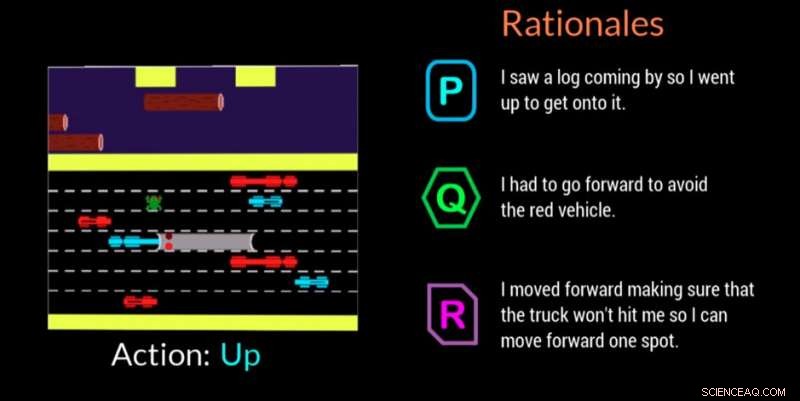

Um agente de IA fornece sua justificativa para tomar uma decisão neste videogame. Crédito:Georgia Tech

Pesquisadores do Georgia Institute of Technology, em colaboração com a Cornell University e a University of Kentucky, desenvolveram um agente artificialmente inteligente (IA) que pode gerar automaticamente explicações em linguagem natural em tempo real para transmitir as motivações por trás de suas ações. O trabalho foi projetado para dar aos humanos envolvidos com agentes de IA ou robôs a confiança de que o agente está realizando a tarefa corretamente e pode explicar um erro ou comportamento errôneo.

O agente também usa uma linguagem cotidiana que os não especialistas podem entender. As explicações, ou "justificativas", como os pesquisadores os chamam, são projetados para serem identificáveis e inspirar confiança naqueles que podem estar no local de trabalho com máquinas de IA ou interagir com eles em situações sociais.

"Se o poder da IA deve ser democratizado, precisa ser acessível a qualquer pessoa, independentemente de suas habilidades técnicas, "disse Upol Ehsan, Ph.D. aluno da School of Interactive Computing da Georgia Tech e pesquisador líder.

"Como a IA permeia todos os aspectos de nossas vidas, há uma necessidade distinta de design de IA centrado no ser humano que torne os sistemas de IA de caixa preta explicáveis para usuários comuns. Nosso trabalho dá um passo formativo para a compreensão do papel das explicações baseadas na linguagem e como os humanos as percebem. "

O estudo foi apoiado pelo Office of Naval Research (ONR).

Os pesquisadores desenvolveram um estudo participante para determinar se seu agente de IA poderia oferecer justificativas que imitassem as respostas humanas. Os espectadores assistiram ao agente de IA jogar o videogame Frogger e então classificaram três argumentos lógicos na tela em ordem de quão bem cada um descreveu o movimento do jogo de IA.

Das três justificativas anônimas para cada movimento - uma resposta gerada por humanos, a resposta do agente AI, e uma resposta gerada aleatoriamente - os participantes preferiram os fundamentos gerados por humanos primeiro, mas as respostas geradas por IA ficaram em segundo lugar.

Frogger ofereceu aos pesquisadores a chance de treinar uma IA em um "ambiente de tomada de decisão sequencial, "o que é um grande desafio de pesquisa porque as decisões que o agente já tomou influenciam as decisões futuras. Portanto, explicar a cadeia de raciocínio para especialistas é difícil, e ainda mais quando se comunica com não especialistas, de acordo com os pesquisadores.

Os espectadores humanos entenderam o objetivo de Frogger em levar o sapo para casa em segurança, sem ser atropelado por veículos em movimento ou se afogar no rio. A mecânica de jogo simples de subir, baixa, esquerda ou direita, permitiu que os participantes vissem o que a IA estava fazendo, e para avaliar se os fundamentos na tela justificavam claramente o movimento.

Os espectadores julgaram os fundamentos com base em:

As justificativas geradas por IA que obtiveram classificação mais alta pelos participantes foram aquelas que mostraram reconhecimento das condições ambientais e adaptabilidade, bem como aqueles que comunicaram a consciência dos perigos futuros e planejados para eles. Informações redundantes que apenas declaravam o óbvio ou descaracterizavam o ambiente tiveram um impacto negativo.

"Este projeto tem mais a ver com a compreensão das percepções e preferências humanas desses sistemas de IA do que sobre a construção de novas tecnologias, "disse Ehsan." No cerne da explicabilidade está a criação de sentido. Estamos tentando entender esse fator humano. "

Um segundo estudo relacionado validou a decisão dos pesquisadores de projetar seu agente de IA para ser capaz de oferecer um de dois tipos distintos de fundamentos:

Neste segundo estudo, os participantes só receberam explicações geradas por IA depois de assistir a IA jogar Frogger. Eles foram solicitados a selecionar a resposta de sua preferência em um cenário em que uma IA cometeu um erro ou se comportou de forma inesperada. Eles não sabiam que os fundamentos eram agrupados nas duas categorias.

Por uma margem de 3 para 1, os participantes preferiram respostas classificadas na categoria "quadro completo". As respostas mostraram que as pessoas gostavam da IA pensando nas etapas futuras, e não apenas no que estava no momento, o que pode torná-los mais propensos a cometer outro erro. As pessoas também queriam saber mais para que pudessem ajudar diretamente a IA a corrigir o comportamento errôneo.

"A compreensão situada das percepções e preferências das pessoas que trabalham com máquinas de IA nos dá um poderoso conjunto de percepções acionáveis que podem nos ajudar a projetar melhor centrado no ser humano, geração de justificativa, agentes autônomos, "disse Mark Riedl, professor de computação interativa e membro do corpo docente do projeto.

Uma possível direção futura para a pesquisa será a aplicação dos resultados a agentes autônomos de vários tipos, como agentes complementares, e como eles podem responder com base na tarefa em questão. Os pesquisadores também analisarão como os agentes podem responder em diferentes cenários, como durante uma resposta de emergência ou ao ajudar professores em sala de aula.

A pesquisa foi apresentada em março na Conferência 2019 da Association for Computing Machinery's Intelligent User Interfaces. O artigo é intitulado "Geração Racional Automatizada:Uma Técnica para IA Explicável e seus Efeitos nas Percepções Humanas." Ehsan apresentará um documento de posição destacando os desafios de design e avaliação de sistemas de IA explicável centrados no homem no próximo workshop Perspectivas Emergentes em Aprendizado de Máquina Centrado no Homem na conferência ACM CHI 2019, 4 a 9 de maio, em Glasgow, Escócia.