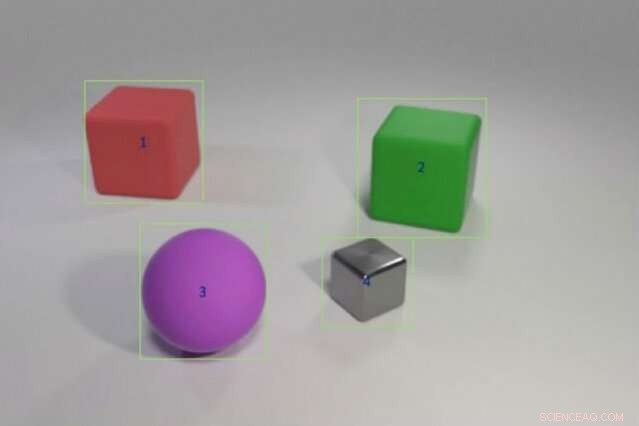

Os pesquisadores treinaram um modelo híbrido de IA para responder a perguntas como "O objeto vermelho à esquerda do cubo verde tem a mesma forma que a coisa roxa fosca?" alimentando-o com exemplos de cores e formas de objetos seguidos por cenários mais complexos envolvendo comparações de vários objetos. O modelo pode transferir esse conhecimento para novos cenários tão bem ou melhores do que modelos de última geração usando uma fração dos dados de treinamento. Crédito:Justin Johnson

Uma criança que nunca viu um elefante rosa ainda pode descrever um - ao contrário de um computador. "O computador aprende com os dados, "disse Jiajun Wu, um Ph.D. estudante do MIT. "A capacidade de generalizar e reconhecer algo que você nunca viu antes - um elefante rosa - é muito difícil para as máquinas."

Os sistemas de aprendizado profundo interpretam o mundo selecionando padrões estatísticos nos dados. Essa forma de aprendizado de máquina agora está em toda parte, marcar amigos automaticamente no Facebook, narrando a última previsão do tempo de Alexa, e apresentando curiosidades por meio da pesquisa do Google. Mas o aprendizado estatístico tem seus limites. Requer toneladas de dados, tem problemas para explicar suas decisões, e é péssimo na aplicação de conhecimentos anteriores a novas situações; Ele não pode compreender um elefante que é rosa em vez de cinza.

Para dar aos computadores a capacidade de raciocinar mais como nós, pesquisadores de inteligência artificial (IA) estão voltando ao abstrato, ou simbólico, programação. Popular nas décadas de 1950 e 1960, Os fios simbólicos da IA nas regras e na lógica permitem que as máquinas façam comparações e interpretem como os objetos e entidades se relacionam. AI simbólica usa menos dados, registra a cadeia de etapas necessárias para chegar a uma decisão, e quando combinado com o poder de processamento bruto das redes neurais estatísticas, pode até vencer os humanos em um teste de compreensão de imagem complicado.

Um novo estudo de uma equipe de pesquisadores do MIT, Laboratório de IA do MIT-IBM Watson, e DeepMind mostra a promessa de fundir IA estatística e simbólica. Liderado por Wu e Joshua Tenenbaum, um professor do Departamento de Cérebro e Ciências Cognitivas do MIT e do Laboratório de Ciência da Computação e Inteligência Artificial, a equipe mostra que seu modelo híbrido pode aprender conceitos relacionados a objetos, como cor e forma, e alavancar esse conhecimento para interpretar relacionamentos de objetos complexos em uma cena. Com dados de treinamento mínimos e nenhuma programação explícita, seu modelo pode transferir conceitos para cenas maiores e responder a perguntas cada vez mais complicadas tão bem ou melhor do que seus pares de última geração. A equipe apresenta seus resultados na Conferência Internacional sobre Representações de Aprendizagem em maio.

"Uma das maneiras pelas quais as crianças aprendem conceitos é conectando palavras com imagens, "diz o principal autor do estudo, Jiayuan Mao, um graduando da Universidade de Tsinghua que trabalhou no projeto como bolsista visitante no MIT. "Uma máquina que pode aprender da mesma maneira precisa de muito menos dados, e é mais capaz de transferir seu conhecimento para novos cenários. "

O estudo é um forte argumento para voltar às abordagens de programa abstrato, disse Jacob Andreas, recém-formado pela Universidade da Califórnia em Berkeley, que começou no MIT como professor assistente neste outono e não esteve envolvido no trabalho. "O truque, acontece que, é adicionar mais estrutura simbólica, e para alimentar as redes neurais com uma representação do mundo que é dividido em objetos e propriedades, em vez de alimentá-lo com imagens brutas, ", diz ele." Este trabalho nos dá uma visão sobre o que as máquinas precisam entender antes que o aprendizado de uma linguagem seja possível. "

A equipe treinou seu modelo em imagens combinadas com perguntas e respostas relacionadas, parte do teste de compreensão de imagem CLEVR desenvolvido na Universidade de Stanford. Conforme o modelo aprende, as perguntas ficam cada vez mais difíceis, a partir de, "Qual é a cor do objeto?" para "Quantos objetos estão à direita do cilindro verde e têm o mesmo material que a pequena bola azul?" Uma vez que os conceitos de nível de objeto são dominados, o modelo avança para aprender como relacionar objetos e suas propriedades entre si.

Como outros modelos híbridos de IA, O MIT funciona dividindo a tarefa. Um módulo de percepção de redes neurais tritura os pixels em cada imagem e mapeia os objetos. Um módulo de linguagem, também feito de redes neurais, extrai um significado das palavras em cada frase e cria programas simbólicos, ou instruções, que dizem à máquina como responder à pergunta. Um terceiro módulo de raciocínio executa os programas simbólicos em cena e dá uma resposta, atualizar o modelo quando ele comete erros.

A chave para a abordagem da equipe é um módulo de percepção que traduz a imagem em uma representação baseada em objeto, tornando os programas mais fáceis de executar. Também é único o que eles chamam de aprendizado curricular, ou treinar seletivamente o modelo em conceitos e cenas que se tornam cada vez mais difíceis. Acontece que alimentar os dados da máquina de maneira lógica, ao invés de aleatoriamente, ajuda o modelo a aprender mais rápido enquanto melhora a precisão.

Uma vez que o modelo tenha uma base sólida, pode interpretar novas cenas e conceitos, e perguntas cada vez mais difíceis, quase perfeitamente. Solicitado a responder a uma pergunta desconhecida como, "Qual é a forma da grande coisa amarela?" ele superou seus pares em Stanford e no vizinho MIT Lincoln Laboratory com uma fração dos dados.

Enquanto outros modelos eram treinados no conjunto de dados CLEVR completo de 70, 000 imagens e 700, 000 perguntas, o modelo MIT-IBM usado 5, 000 imagens e 100, 000 perguntas. Como o modelo construído em conceitos previamente aprendidos, absorveu os programas subjacentes a cada questão, agilizando o processo de treinamento.

Embora estatístico, modelos de aprendizagem profunda agora estão incorporados na vida diária, muito do seu processo de decisão permanece oculto. Essa falta de transparência torna difícil prever onde o sistema é suscetível de manipulação, erro, ou viés. Adicionar uma camada simbólica pode abrir a caixa preta, explicando o crescente interesse em sistemas híbridos de IA.

"Dividir a tarefa e permitir que os programas façam parte do trabalho é a chave para construir a interpretabilidade em modelos de aprendizagem profunda, "diz o pesquisador do Lincoln Laboratory David Mascharka, cujo modelo híbrido, Transparência por Design Network, é avaliado no estudo do MIT-IBM.

A equipe do MIT-IBM agora está trabalhando para melhorar o desempenho do modelo em fotos do mundo real e estendê-lo para compreensão de vídeo e manipulação robótica. Outros autores do estudo são Chuang Gan e Pushmeet Kohli, pesquisadores do MIT-IBM Watson AI Lab e DeepMind, respectivamente.

Esta história foi republicada por cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisas do MIT, inovação e ensino.