Os jogadores de basquete Darren Collision (à esquerda) e Gordon Hayward (à direita). Crédito:basketball-reference.com

A tecnologia de reconhecimento facial progrediu a ponto de agora interpretar emoções em expressões faciais. Esse tipo de análise é cada vez mais utilizado no cotidiano. Por exemplo, as empresas podem usar software de reconhecimento facial para ajudar nas decisões de contratação. Outros programas examinam os rostos nas multidões para identificar ameaças à segurança pública.

Infelizmente, esta tecnologia luta para interpretar as emoções dos rostos negros. Meu novo estudo, publicado no mês passado, mostra que a tecnologia de análise emocional atribui mais emoções negativas aos rostos dos homens negros do que aos rostos dos homens brancos.

Esta não é a primeira vez que os programas de reconhecimento facial demonstraram ser tendenciosos. O Google rotulou rostos negros como gorilas. As câmeras identificaram rostos asiáticos como piscando. Os programas de reconhecimento facial lutaram para identificar corretamente o gênero das pessoas com pele mais escura.

Meu trabalho contribui para uma necessidade crescente de entender melhor o preconceito oculto em softwares de inteligência artificial.

Polarização de medição

Para examinar o preconceito nos sistemas de reconhecimento facial que analisam as emoções das pessoas, Usei um conjunto de dados de 400 fotos de jogadores da NBA da temporada de 2016 a 2017, porque os jogadores são semelhantes em suas roupas, atletismo, idade e sexo. Também, já que são retratos profissionais, os jogadores olham para a câmera na foto.

Corri as imagens por meio de dois tipos conhecidos de software de reconhecimento emocional. Ambos atribuíram aos jogadores negros pontuações emocionais mais negativas em média, não importa o quanto eles sorriam.

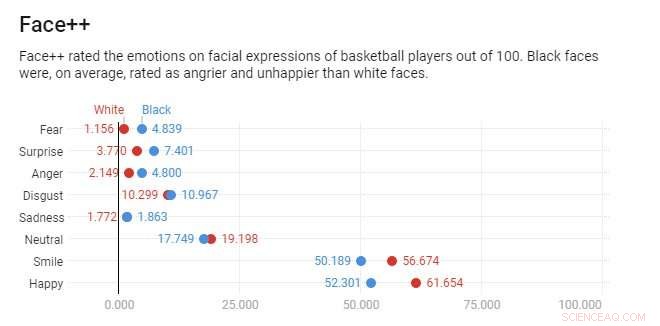

Crédito:Gráfico:A conversa, Fonte CC-BY-ND:SSRN (2018)

Por exemplo, considere as fotos oficiais da NBA de Darren Collison e Gordon Hayward. Ambos os jogadores estão sorrindo, e, de acordo com o programa de reconhecimento e análise facial Face ++, Darren Collison e Gordon Hayward têm pontuações de sorriso semelhantes - 48,7 e 48,1 em 100, respectivamente.

Contudo, Face ++ classifica a expressão de Hayward como 59,7% feliz e 0,13% zangada e a expressão de Collison como 39,2% feliz e 27% zangada. Collison é visto tão zangado quanto feliz e muito mais zangado do que Hayward - apesar do próprio programa de reconhecimento facial reconhecer que os dois jogadores estão sorrindo.

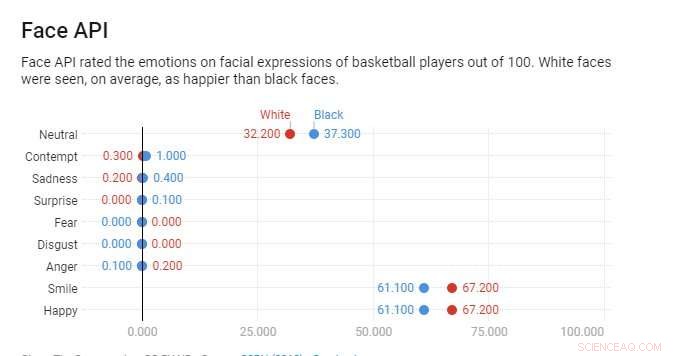

Em contraste, A Face API da Microsoft considerou os dois homens felizes. Ainda, Collison é visto como menos feliz do que Hayward, com pontuações de felicidade de 98 e 93 por cento, respectivamente. Apesar de seu sorriso, Collison é ainda pontuado com uma pequena dose de desprezo, enquanto Hayward não tem nenhum.

Em todas as fotos da NBA, o mesmo padrão emerge. Na média, Face ++ classifica rostos negros duas vezes mais zangados do que rostos brancos. Face API pontua rostos negros como três vezes mais desdenhosos do que rostos brancos. Depois de combinar jogadores com base em seus sorrisos, ambos os programas de análise facial são ainda mais propensos a atribuir as emoções negativas de raiva ou desprezo a rostos negros.

Estereotipado por AI

Meu estudo mostra que os programas de reconhecimento facial exibem dois tipos distintos de preconceito.

Crédito:Gráfico:A conversa, Fonte CC-BY-ND:SSRN (2018)

Primeiro, rostos negros eram consistentemente marcados como mais raivosos do que rostos brancos para cada sorriso. Face ++ mostrou este tipo de preconceito. Segundo, rostos negros sempre eram pontuados como mais raivosos se houvesse alguma ambigüidade em sua expressão facial. Face API exibia esse tipo de disparidade. Mesmo que rostos negros estejam sorrindo parcialmente, minha análise mostrou que os sistemas assumiram emoções mais negativas em comparação com suas contrapartes brancas com expressões semelhantes. As pontuações emocionais médias eram muito mais próximas entre as corridas, mas ainda havia diferenças perceptíveis para rostos em preto e branco.

Esta observação está alinhada com outras pesquisas, o que sugere que os profissionais negros devem amplificar as emoções positivas para receber paridade em suas avaliações de desempenho no local de trabalho. Estudos mostram que as pessoas consideram os homens negros mais fisicamente ameaçadores do que os brancos, mesmo quando são do mesmo tamanho.

Alguns pesquisadores argumentam que a tecnologia de reconhecimento facial é mais objetiva do que os humanos. Mas meu estudo sugere que o reconhecimento facial reflete os mesmos preconceitos que as pessoas têm. As expressões faciais dos homens negros são marcadas com emoções associadas a comportamentos ameaçadores com mais frequência do que os homens brancos, mesmo quando estão sorrindo. Há boas razões para acreditar que o uso de reconhecimento facial pode formalizar estereótipos preexistentes em algoritmos, incorporando-os automaticamente na vida cotidiana.

Até que o reconhecimento facial avalie rostos em preto e branco de forma semelhante, os negros podem precisar exagerar suas expressões faciais positivas - essencialmente sorrir mais - para reduzir a ambigüidade e interpretações potencialmente negativas por parte da tecnologia.

Embora inovador, a inteligência artificial pode perpetrar e exacerbar a dinâmica de poder existente, levando a impactos díspares entre grupos raciais / étnicos. Alguma responsabilidade social é necessária para garantir justiça a todos os grupos porque o reconhecimento facial, como a maioria da inteligência artificial, muitas vezes é invisível para as pessoas mais afetadas por suas decisões.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.