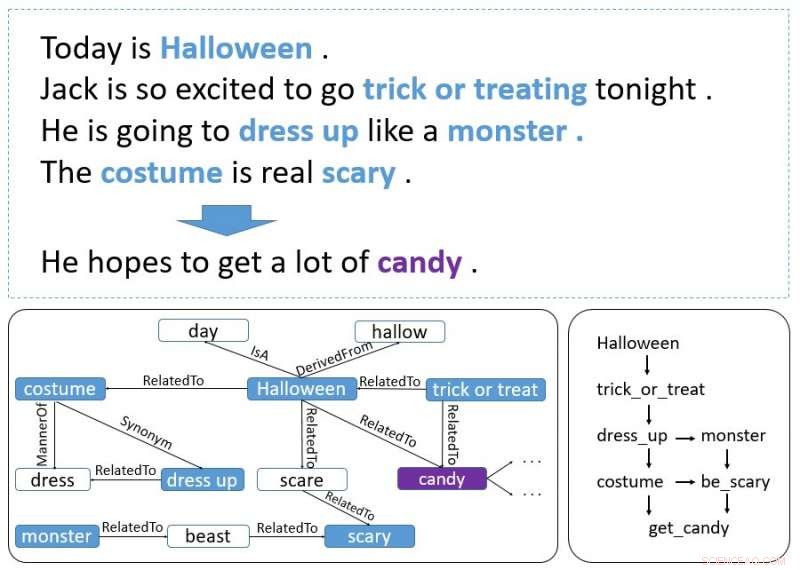

Um exemplo de história. Palavras em negrito são eventos e entidades. O gráfico inferior esquerdo é recuperado do ConceptNet e o gráfico inferior direito representa como eventos e entidades formam a pista de contexto. Crédito:Guan, Wang e Huang

Pesquisadores do AI Lab da Tsinghua University desenvolveram recentemente um modelo incremental baseado em codificador que pode gerar finais de histórias. Um codificador incremental é um tipo de algoritmo de compressão de codificação que costuma ser usado para comprimir dados classificados, como listas de palavras ou frases.

O novo modelo, descrito em um artigo pré-publicado no arXiv, emprega um esquema de codificação incremental com atenção de várias fontes às pistas de contexto do processo que abrangem toda a história, gerando um final adequado.

Inicialmente, os pesquisadores estavam interessados no Story Cloze Test (SCT), em que um sistema escolhe um final correto para uma história entre duas possibilidades disponíveis. Pesquisas anteriores se concentraram neste teste específico para desenvolver ferramentas de geração de final de história, mas o estudo recente leva essa ideia um passo adiante.

"Nós pensamos, por que não desenvolver um modelo que pode gerar um final por conta própria? Então, criamos a tarefa de geração de fim de história, "Yansen Wang, um dos pesquisadores que realizaram o estudo disse ao TechXplore. "Contudo, breve, descobrimos que gerar um final de história razoável é uma tarefa muito mais desafiadora do que a original porque requer a captura de informações de lógica e causalidade que podem se estender por várias frases de um contexto de história. Utilizar o bom senso também é necessário nesta tarefa, o que não é tão importante se dois finais possíveis são dados. "

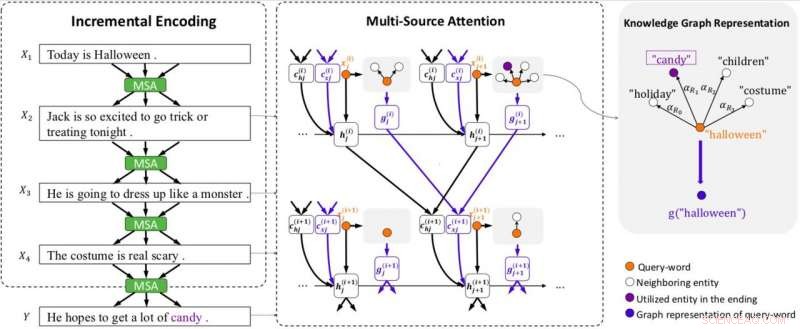

Visão geral do modelo. O modelo é equipado com codificação incremental (IE) e atenção de múltiplas fontes (MSA) (incluindo atenção de gráfico para representar gráficos de conhecimento). MSA produz vetores de contexto de estado (c (i) hj) atendendo aos estados ocultos (h (i) j), e vetores de contexto de conhecimento (c (i) xj) atendendo aos vetores do gráfico (g (i) j) da frase anterior. O IE usa os vetores de contexto de estado e conhecimento para construir codificações de contexto de forma incremental. Cada gráfico é representado por um vetor (g (i) j) usando a atenção do gráfico. x (i) j denota a j-ésima palavra na frase i. Crédito:Guan, Wang e Huang

Para enfrentar esses dois desafios, os pesquisadores desenvolveram um esquema de codificação incremental com um mecanismo de atenção de múltiplas fontes que pode gerar finais de história eficazes. Este sistema funciona codificando o contexto de uma história de forma incremental, com seu mecanismo de atenção de múltiplas fontes usando pistas de contexto e conhecimento de senso comum.

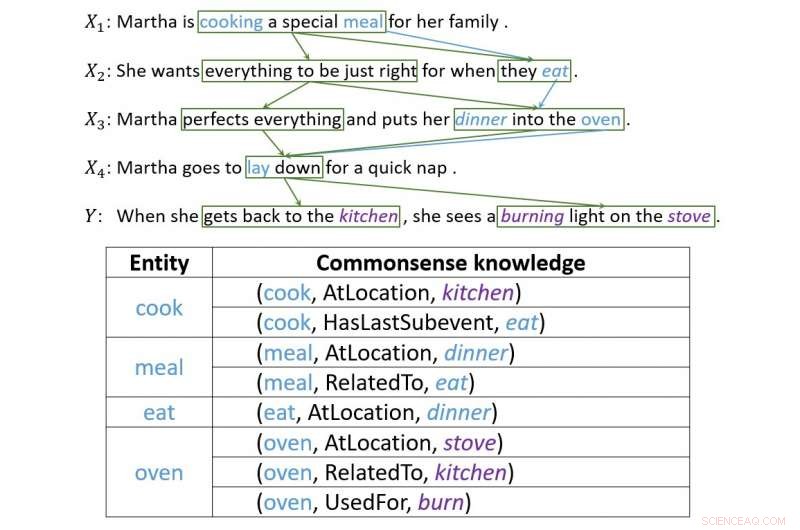

"O esquema de codificação incremental que desenvolvemos pode codificar os estados anteriores contendo informações e relações entre palavras de forma incremental, "Disse Wang." O mecanismo de atenção de múltiplas fontes irá encontrar e capturar a ordem cronológica ou relação causal entre entidades ou eventos em frases adjacentes. Para utilizar o conhecimento do senso comum, um chefe da atenção de múltiplas fontes apontará para uma representação lógica das palavras, que contém conhecimento de senso comum recuperado do ConceptNet. "

Projetar este modelo provou ser uma tarefa difícil e complexa, já que vários desafios tiveram que ser superados para garantir que o sistema produzisse finais sensatos. Na verdade, um final de história eficaz deve considerar vários aspectos da história, se encaixam bem com seu contexto e também fazem sentido.

"A geração do final da história requer a captura da lógica e causalidade da informação, "Wang explicou." Este tipo de informação não é apenas ponto a ponto. Na maioria dos casos, forma uma estrutura mais complexa, que as pessoas chamam de 'pista de contexto'. Passamos muito tempo projetando nosso modelo, então surgiu o esquema de codificação incremental. A atenção entre as frases naturalmente forma uma estrutura semelhante a uma rede, e as informações lógicas transmitidas pela atenção são exatamente o que queríamos. "

Um exemplo que ilustra como a codificação incremental constrói conexões entre pistas de contexto. Crédito:Guan, Wang e Huang

Os pesquisadores avaliaram seu modelo e o compararam com outros sistemas de geração de finalização de história. Eles descobriram que isso poderia gerar finais de história muito mais apropriados e razoáveis do que linhas de base de última geração.

"Ao testar o modelo, alcançamos resultados encantadores, "Disse Wang." Nos experimentos a seguir, também descobrimos que este esquema poderia passar mais informações, incluindo conhecimento de senso comum, somente se pudermos representar esse tipo de informação adequadamente. Isso demonstra a flexibilidade do nosso esquema. "

O modelo projetado por Wang e seus colegas prova o quão longe a tecnologia mais recente pode ir, mesmo em tarefas que até agora foram realizadas principalmente por humanos. Embora tenha alcançado resultados altamente promissores, os pesquisadores acreditam que ainda há muito espaço para melhorias.

"Agora estamos tentando aplicar essa estrutura em um corpus de história mais longo, uma vez que a duração das histórias em SCT não é muito longa, "disse Wang." Além do mais, uma vez que a estrutura de codificação incremental pode transportar diferentes tipos de informações, estamos tentando aplicá-lo a outros tipos de tarefas que envolvem a passagem de informações de longo prazo, como a geração de conversas multi-turn. "

© 2018 Tech Xplore