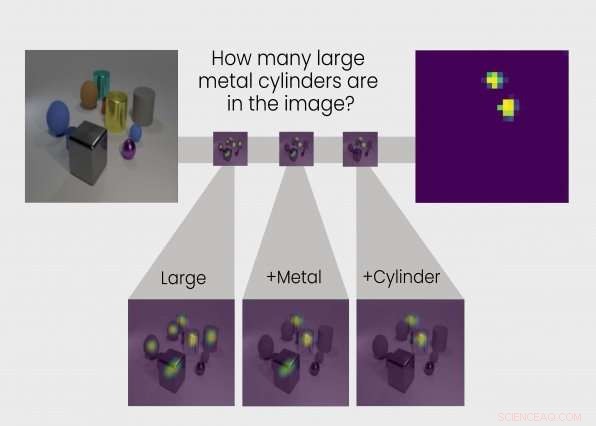

O TbD-net resolve o problema de raciocínio visual dividindo-o em uma cadeia de subtarefas. A resposta para cada subtarefa é mostrada em mapas de calor destacando os objetos de interesse, permitindo que os analistas vejam o processo de pensamento da rede. Crédito:Grupo de Tecnologias de Inteligência e Decisão

Aprendemos pela razão como interpretar o mundo. Então, também, fazer redes neurais. Agora, uma equipe de pesquisadores do Grupo de Tecnologias de Inteligência e Decisão do Laboratório Lincoln do MIT desenvolveu uma rede neural que executa etapas de raciocínio semelhantes às humanas para responder a perguntas sobre o conteúdo das imagens. Chamada Transparency by Design Network (TbD-net), o modelo renderiza visualmente seu processo de pensamento à medida que resolve problemas, permitindo que analistas humanos interpretem seu processo de tomada de decisão. O modelo tem um desempenho melhor do que as melhores redes neurais de raciocínio visual de hoje.

Compreender como uma rede neural toma suas decisões tem sido um desafio de longa data para os pesquisadores de inteligência artificial (IA). Como a parte neural do nome sugere, redes neurais são sistemas de IA inspirados no cérebro, destinados a replicar a maneira como os humanos aprendem. Eles consistem em camadas de entrada e saída, e camadas intermediárias que transformam a entrada na saída correta. Algumas redes neurais profundas se tornaram tão complexas que é praticamente impossível acompanhar esse processo de transformação. É por isso que são chamados de sistemas de "caixa preta", com exatamente o que acontece por dentro, opaco até mesmo para os engenheiros que os construíram.

Com o TbD-net, os desenvolvedores pretendem tornar esse funcionamento interno transparente. A transparência é importante porque permite que os humanos interpretem os resultados de uma IA.

É importante saber, por exemplo, o que exatamente uma rede neural usada em carros autônomos pensa que é a diferença entre um pedestre e um sinal de pare, e em que ponto ao longo de sua cadeia de raciocínio ele vê essa diferença. Esses insights permitem que os pesquisadores ensinem a rede neural a corrigir quaisquer suposições incorretas. Mas os desenvolvedores da TbD-net dizem que as melhores redes neurais de hoje carecem de um mecanismo eficaz para permitir que os humanos entendam seu processo de raciocínio.

"O progresso na melhoria do desempenho no raciocínio visual veio ao custo da interpretabilidade, "diz Ryan Soklaski, que construiu o TbD-net com seus colegas pesquisadores Arjun Majumdar, David Mascharka, e Philip Tran.

O grupo do Laboratório Lincoln conseguiu fechar a lacuna entre desempenho e interpretabilidade com a rede TbD. Uma chave para seu sistema é uma coleção de "módulos, "pequenas redes neurais especializadas para realizar subtarefas específicas. Quando o TbD-net é questionado sobre o raciocínio visual de uma imagem, ele divide a questão em subtarefas e atribui o módulo apropriado para cumprir sua parte. Como trabalhadores em uma linha de montagem, cada módulo constrói o que o módulo anterior descobriu para, eventualmente, produzir o final, resposta correta. Como um todo, TbD-net utiliza uma técnica de IA que interpreta questões da linguagem humana e divide essas frases em subtarefas, seguido por múltiplas técnicas de visão computacional de IA que interpretam as imagens.

Majumdar diz:"Quebrando uma cadeia complexa de raciocínio em uma série de subproblemas menores, cada um dos quais pode ser resolvido de forma independente e composto, é um meio poderoso e intuitivo de raciocínio. "

A saída de cada módulo é representada visualmente no que o grupo chama de "máscara de atenção". A máscara de atenção mostra blobs de mapa de calor sobre objetos na imagem que o módulo está identificando como sua resposta. Essas visualizações permitem que o analista humano veja como um módulo está interpretando a imagem.

Leva, por exemplo, a seguinte questão colocada à TbD-net:"Nesta imagem, de que cor é o grande cubo de metal? "Para responder à pergunta, o primeiro módulo localiza apenas objetos grandes, produzindo uma máscara de atenção com aqueles grandes objetos destacados. O próximo módulo pega essa saída e descobre quais dos objetos identificados como grandes pelo módulo anterior também são de metal. A saída desse módulo é enviada para o próximo módulo, que identifica qual desses grandes, objetos de metal também são um cubo. Afinal, essa saída é enviada para um módulo que pode determinar a cor dos objetos. A saída final do TbD-net é "vermelho, "a resposta correta para a pergunta.

Quando testado, O TbD-net alcançou resultados que superam os modelos de raciocínio visual de melhor desempenho. Os pesquisadores avaliaram o modelo usando um conjunto de dados de resposta a perguntas visuais consistindo em 70, 000 imagens de treinamento e 700, 000 perguntas, junto com conjuntos de teste e validação de 15, 000 imagens e 150, 000 perguntas. O modelo inicial alcançou 98,7 por cento de precisão de teste no conjunto de dados, que, de acordo com os pesquisadores, de longe supera outras abordagens baseadas em rede de módulo neural.

Mais importante, os pesquisadores foram capazes de melhorar esses resultados por causa da vantagem principal de seu modelo - transparência. Ao olhar para as máscaras de atenção produzidas pelos módulos, eles puderam ver onde as coisas deram errado e refinar o modelo. O resultado final foi um desempenho de última geração com precisão de 99,1%.

"Nosso modelo oferece uma abordagem direta, saídas interpretáveis em cada estágio do processo de raciocínio visual, "Mascharka diz.

A interpretabilidade é especialmente valiosa se algoritmos de aprendizado profundo forem implantados junto com humanos para ajudar a lidar com tarefas complexas do mundo real. Para construir confiança nesses sistemas, os usuários precisarão da capacidade de inspecionar o processo de raciocínio para que possam entender por que e como um modelo pode fazer previsões erradas.

Paul Metzger, líder do Grupo de Tecnologias de Decisão e Inteligência, afirma que a pesquisa "faz parte do trabalho do Lincoln Laboratory para se tornar um líder mundial em pesquisa de aprendizado de máquina aplicada e inteligência artificial que promove a colaboração homem-máquina".

Esta história foi republicada por cortesia do MIT News (web.mit.edu/newsoffice/), um site popular que cobre notícias sobre pesquisas do MIT, inovação e ensino.