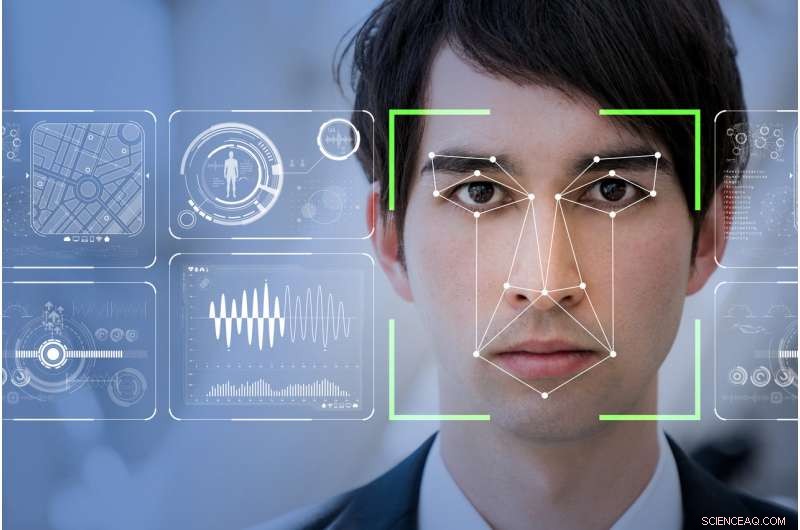

O software de reconhecimento facial tornará o mundo um lugar mais seguro, como afirmam as empresas de tecnologia, ou tornará os marginalizados mais vulneráveis e monitorados? Crédito:Shutterstock

Minha mãe sempre disse que eu tinha cara de rádio. Graças a Deus, já que o rádio pode ser o último lugar neste mundo aprimorado pela tecnologia onde seu rosto não determinará seu status social ou potencial para cometer um crime.

RealNetworks, o líder global de uma tecnologia que permite a entrega digital contínua de arquivos de áudio e vídeo pela Internet, acaba de lançar sua mais recente visão computacional:um pacote de software de aprendizado de máquina. A esperança é que este novo software detecte, e potencialmente prever, comportamento suspeito por meio do reconhecimento facial.

Chamado SAFR (seguro, Reconhecimento facial preciso), o conjunto de ferramentas foi comercializado como uma maneira econômica de se integrar perfeitamente aos sistemas de monitoramento de vídeo CCTV existentes. Será capaz de "detectar e combinar milhões de rostos em tempo real, "especificamente em ambientes escolares.

Ostensivamente, A RealNetworks vê sua tecnologia como algo que pode tornar o mundo mais seguro. A marca cativante, Contudo, mascara as verdadeiras questões éticas que envolvem a implantação de sistemas de detecção facial. Alguns desses problemas incluem questões sobre os preconceitos inerentes incorporados ao código e, em última análise, como esses dados capturados são usados.

O modelo chinês

O Big Brother está assistindo. Nenhum outro país do mundo possui mais vigilância por vídeo do que a China. Com 170 milhões de câmeras CCTV e cerca de 400 milhões de novas sendo instaladas, é um país que adotou e implantou o reconhecimento facial de maneira orwelliana.

No futuro próximo, seus cidadãos, e aqueles de nós que viajam para lá, estará exposto a uma vasta e integrada rede de sistemas de reconhecimento facial monitorando tudo, desde o uso de transporte público, a velocidade para a quantidade de papel higiênico que se usa no banheiro público.

O elemento mais preocupante até agora é a recente introdução do reconhecimento facial para monitorar o comportamento de crianças em escolas públicas chinesas.

Como parte da integração total da China de seu sistema de crédito social igualmente orwelliano - um programa de incentivo que recompensa o compromisso de cada cidadão com a moral ditada pelo estado - este sistema digital totalmente integrado identificará automaticamente uma pessoa. Pode então determinar a capacidade de alguém progredir na sociedade - e, por extensão, o status econômico e social da família imediata dessa pessoa - monitorando o comportamento não sancionado do Estado.

Em essência, o reconhecimento facial está impossibilitando as pessoas expostas ao luxo de ter um dia ruim.

Os sistemas de reconhecimento facial que estão sendo implantados nas escolas chinesas estão monitorando tudo, desde a frequência à sala de aula até se uma criança está sonhando acordada ou prestando atenção. É um sistema de monitoramento completo que determina, em grande medida, futuro de uma criança sem considerar algumas qualidades, como o pensamento abstrato, não pode ser facilmente detectado ou, na melhor das hipóteses, olhado favoravelmente, com reconhecimento facial.

Também levanta algumas noções muito desconfortáveis de ética ou a falta dela, especialmente para os membros mais vulneráveis da sociedade.

Necessidade de regulamentação pública

O lançamento do SAFR pela RealNetworks vem logo após o manifesto apaixonado do presidente da Microsoft, Brad Smith, sobre a necessidade de regulamentação pública e responsabilidade corporativa no desenvolvimento e implantação de tecnologia de reconhecimento facial.

Smith apontou corretamente que as ferramentas de reconhecimento facial ainda são um pouco distorcidas e têm "maiores taxas de erro para mulheres e pessoas de cor". Este problema é duplo, com o reconhecimento de que as pessoas que codificam podem inconscientemente incorporar preconceitos culturais.

Os conjuntos de dados atualmente disponíveis podem não ter a robustez objetiva necessária para garantir que os rostos das pessoas não sejam identificados incorretamente, ou ainda pior, predeterminado por meio de viés codificado, como agora está começando a acontecer no sistema escolar chinês.

Em um esforço para resolver isso e uma miríade de outras questões relacionadas, A Microsoft estabeleceu um Comitê de IA e Ética em Engenharia e Pesquisa (AETHER). Este comitê também foi criado para ajudá-los a cumprir o Regulamento Geral de Proteção de Dados (GDPR) da União Europeia recentemente aplicado e sua eventual adoção futura. de alguma forma, na América do Norte.

O apelo ardente de Smith questiona corretamente o uso atual e futuro pretendido e a implantação de sistemas de reconhecimento facial, ainda não aborda como a Microsoft ou, por extensão, outros líderes de tecnologia de IA, pode eliminar preconceitos em seu código base ou conjuntos de dados desde o início.

Relatório minoritário

Os traços do nosso rosto são pouco mais do que gestos que a força do hábito tornou permanentes . — Marcel Proust, 1919

Como muitas tecnologias, Pandora já saiu da caixa. Se você possui um smartphone e usa a Internet, você já optou por não aceitar quaisquer noções básicas de anonimato pessoal na sociedade ocidental.

Com o GDPR agora totalmente envolvido na Europa, visitar um site agora exige que você "aceite" a possibilidade de esse site estar coletando dados pessoais. Os sistemas de reconhecimento facial não têm como seguir as regras do GDPR, então como tal, nós, como sociedade, somos automaticamente "incluídos" e, portanto, completamente à mercê de como nossos rostos estão sendo gravados, processado e armazenado pelo governo, sistemas de CFTV corporativos ou mesmo privados.

Os testes de reconhecimento facial realizados na Inglaterra pela Polícia Metropolitana de Londres apresentaram consistentemente uma taxa de reprovação de 98%. De forma similar, em South West Wales, os testes tiveram desempenho apenas ligeiramente melhor, com menos de 10 por cento de sucesso.

Por outro lado, Universidade da Califórnia, Berkeley, os cientistas concluíram que a variação facial substantiva é um traço evolutivo exclusivo dos humanos. Então, onde está a desconexão?

Se como Marcel Proust sugeriu, nossas vidas e, portanto, nossas personalidades são exclusivamente identificáveis por nossos rostos, por que os sistemas de reconhecimento facial não podem retornar resultados positivos facilmente?

A resposta remonta a como a programação do computador é escrita e aos conjuntos de dados usados por esse código para retornar uma correspondência positiva. Inevitavelmente, o código é escrito para dar suporte a uma noção idealizada de tipo facial.

Como tal, variações remotas, como deformidades faciais naturais ou características faciais afetadas por traumas físicos ou mentais, representam apenas uma pequena fração das infinitas variações faciais possíveis no mundo. Os conjuntos de dados assumem que somos doppelgängers homogêneos uns dos outros, sem abordar as micro-variações dos rostos das pessoas.

Se for esse o caso, we are all subject to the possibility that our faces as interpreted by the ever-increasing deployment of immature facial recognition systems will betray the reality of who we are.

Este artigo foi publicado originalmente em The Conversation. Leia o artigo original.