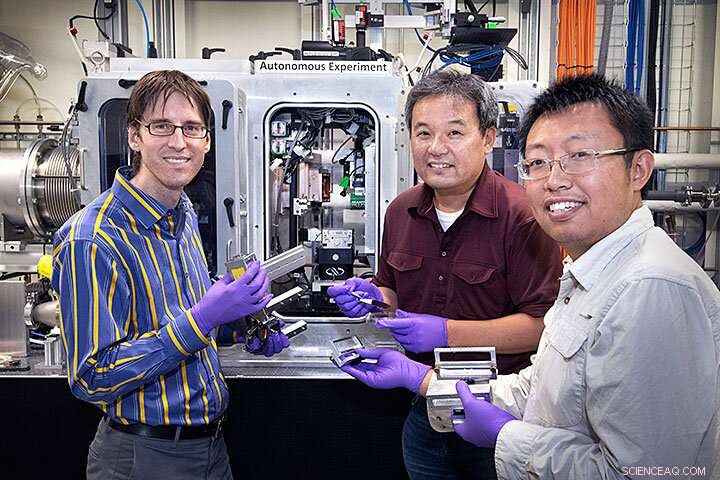

(Da esquerda para a direita) Kevin Yager, Masafumi Fukuto, e Ruipeng Li preparou a linha de luz de dispersão de materiais complexos (CMS) em NSLS-II para uma medição usando o novo algoritmo de tomada de decisão, que foi desenvolvido por Marcus Noack (não retratado). Crédito:Laboratório Nacional de Brookhaven

Uma equipe de cientistas do Laboratório Nacional Brookhaven do Departamento de Energia dos EUA e do Laboratório Nacional Lawrence Berkeley projetou, criada, e testou com sucesso um novo algoritmo para tomar decisões de medição científicas mais inteligentes. O algoritmo, uma forma de inteligência artificial (IA), pode tomar decisões autônomas para definir e executar a próxima etapa de um experimento. A equipe descreveu as capacidades e flexibilidade de sua nova ferramenta de medição em um artigo publicado em 14 de agosto, 2019 em Relatórios Científicos .

De Galileu e Newton à recente descoberta das ondas gravitacionais, realizar experimentos científicos para entender o mundo ao nosso redor tem sido a força motriz de nosso avanço tecnológico por centenas de anos. Melhorar a maneira como os pesquisadores fazem seus experimentos pode ter um impacto tremendo na rapidez com que esses experimentos produzem resultados aplicáveis para novas tecnologias.

Nas últimas décadas, os pesquisadores aceleraram seus experimentos por meio da automação e de uma variedade cada vez maior de ferramentas de medição rápida. Contudo, alguns dos desafios científicos mais interessantes e importantes - como a criação de materiais de bateria aprimorados para armazenamento de energia ou novos materiais quânticos para novos tipos de computadores - ainda exigem experimentos muito exigentes e demorados.

Ao criar um novo algoritmo de tomada de decisão como parte de uma configuração experimental totalmente automatizada, a equipe interdisciplinar de duas instalações do DOE Office of Science de Brookhaven - o Center for Functional Nanomaterials (CFN) e a National Synchrotron Light Source II (NSLS-II) - e o Berkeley Lab's Center for Advanced Mathematics for Energy Research Applications (CAMERA) oferece a possibilidade de estudar esses desafios de forma mais eficiente.

O desafio da complexidade

O objetivo de muitos experimentos é obter conhecimento sobre o material que é estudado, e os cientistas têm uma maneira bem testada de fazer isso:eles pegam uma amostra do material e medem como ele reage às mudanças em seu ambiente.

Uma abordagem padrão para cientistas em instalações de usuários como NSLS-II e CFN é examinar manualmente as medições de um determinado experimento para determinar a próxima área onde eles podem querer executar um experimento. Mas o acesso às ferramentas de caracterização de materiais de alta qualidade dessas instalações é limitado, portanto, o tempo de medição é precioso. Uma equipe de pesquisa pode ter apenas alguns dias para medir seus materiais, então eles precisam tirar o máximo proveito de cada medição.

"A chave para alcançar um número mínimo de medições e qualidade máxima do modelo resultante é ir onde as incertezas são grandes, "disse Marcus Noack, um pós-doutorado na CAMERA e principal autor do estudo. "Realizar medições lá reduzirá com mais eficácia a incerteza geral do modelo."

Como Kevin Yager, um co-autor e cientista do CFN, apontou, "O objetivo final não é apenas obter dados mais rapidamente, mas também melhorar a qualidade dos dados que coletamos. Penso nisso como experimentalistas mudando de microgerenciamento de seu experimento para gerenciamento em um nível superior. Em vez de ter que decidir onde medir a seguir na amostra, os cientistas podem, em vez disso, pensar no quadro geral, que é, em última análise, o que nós, como cientistas, estamos tentando fazer. "

"Esta nova abordagem é um exemplo aplicado de inteligência artificial, "disse o co-autor Masafumi Fukuto, um cientista do NSLS-II. "O algoritmo de tomada de decisão está substituindo a intuição do experimentador humano e pode examinar os dados e tomar decisões inteligentes sobre como o experimento deve prosseguir."

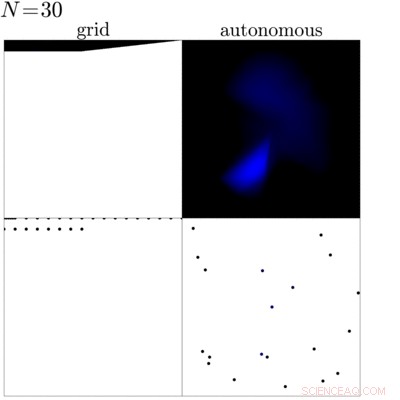

Esta animação mostra uma comparação entre uma medição de grade tradicional (esquerda) de uma amostra com uma medição dirigida pelo algoritmo de tomada de decisão recém-desenvolvido (direita). Essa comparação mostra que o algoritmo pode identificar as bordas e a parte interna da amostra e foca a medição nessas regiões para obter mais conhecimento sobre a amostra. Crédito:Laboratório Nacional de Brookhaven

Mais informações por menos?

Na prática, antes de iniciar um experimento, os cientistas definem um conjunto de objetivos que desejam obter da medição. Com essas metas definidas, o algoritmo analisa os dados medidos anteriormente enquanto o experimento está em andamento para determinar a próxima medição. Em sua busca pela melhor próxima medição, o algoritmo cria um modelo substituto dos dados, que é uma suposição fundamentada de como o material se comportará nas próximas etapas possíveis, e calcula a incerteza - basicamente o quão confiante ele está em sua suposição - para cada próxima etapa possível. Com base nisso, ele então seleciona a opção mais incerta para medir a seguir. O truque aqui é escolher a etapa mais incerta para medir a seguir, o algoritmo maximiza a quantidade de conhecimento que ganha ao fazer essa medição. O algoritmo não só maximiza o ganho de informação durante a medição, também define quando terminar o experimento, descobrindo o momento em que quaisquer medições adicionais não resultariam em mais conhecimento.

"A ideia básica é, dado um monte de experimentos, como você pode escolher automaticamente o próximo melhor? "disse James Sethian, diretor do CAMERA e co-autor do estudo. "Marcus construiu um mundo que constrói um modelo substituto aproximado com base em seus experimentos anteriores e sugere o melhor ou mais apropriado experimento para tentar a seguir."

Como chegamos aqui

Para tornar os experimentos autônomos uma realidade, a equipe teve que lidar com três peças importantes:a automação da coleta de dados, análise em tempo real, e, claro, o algoritmo de tomada de decisão.

"Esta é uma parte empolgante desta colaboração, "disse Fukuto." Todos nós fornecemos uma peça essencial para isso:a equipe da CAMERA trabalhou no algoritmo de tomada de decisão, Kevin da CFN desenvolveu a análise de dados em tempo real, e nós do NSLS-II fornecemos a automação para as medições. "

A equipe implementou primeiro seu algoritmo de tomada de decisão na linha de luz de dispersão de materiais complexos (CMS) em NSLS-II, onde o CFN e o NSLS-II atuam em parceria. Este instrumento oferece raios-x ultrabright para estudar a nanoestrutura de vários materiais. Como cientista líder da linha de luz deste instrumento, Fukuto já havia projetado a linha de luz com a automação em mente. A linha de luz oferece um robô de troca de amostras, movimento automático da amostra em várias direções, e muitas outras ferramentas úteis para garantir medições rápidas. Junto com a análise de dados em tempo real de Yager, a linha de luz era - por design - o ajuste perfeito para o primeiro experimento "inteligente".

O primeiro experimento "inteligente"

O primeiro experimento totalmente autônomo que a equipe realizou foi mapear o perímetro de uma gota onde as nanopartículas segregam usando uma técnica chamada espalhamento de raios X de baixo ângulo na linha de luz CMS. Durante o espalhamento de raios-X de pequeno ângulo, os cientistas emitem raios-x brilhantes na amostra e, dependendo da estrutura atômica para nanoescala da amostra, os raios-x refletem em direções diferentes. Os cientistas então usam um grande detector para capturar os raios-x espalhados e calcular as propriedades da amostra no ponto iluminado. Neste primeiro experimento, os cientistas compararam a abordagem padrão de medir a amostra com as medições feitas quando o novo algoritmo de tomada de decisão estava dando as cartas. O algoritmo foi capaz de identificar a área da gota e focou em suas bordas e partes internas ao invés do fundo.

"Depois de nosso próprio sucesso inicial, queríamos aplicar mais o algoritmo, então entramos em contato com alguns usuários e propusemos testar nosso novo algoritmo em seus problemas científicos, "disse Yager." Eles disseram que sim, e desde então medimos várias amostras. Um dos mais interessantes foi o estudo de uma amostra fabricada para conter um espectro de diferentes tipos de materiais. Então, em vez de fazer e medir um número enorme de amostras e talvez perder uma combinação interessante, o usuário fez uma única amostra que incluiu todas as combinações possíveis. Nosso algoritmo foi então capaz de explorar esta enorme diversidade de combinações de forma eficiente, " ele disse.

Qual é o próximo?

Após os primeiros experimentos bem-sucedidos, os cientistas planejam melhorar ainda mais o algoritmo e, portanto, seu valor para a comunidade científica. Uma de suas ideias é tornar o algoritmo "ciente da física" - tirando proveito de tudo o que já é conhecido sobre o material em estudo - para que o método possa ser ainda mais eficaz. Outro desenvolvimento em andamento é o uso do algoritmo durante a síntese e processamento de novos materiais, por exemplo, para entender e otimizar processos relevantes para a fabricação avançada, visto que esses materiais são incorporados em dispositivos do mundo real. A equipe também está pensando em um quadro maior e quer transferir o método autônomo para outras configurações experimentais.

"Acho que os usuários veem as linhas de luz do NSLS-II ou microscópios do CFN como ferramentas de caracterização poderosas. Estamos tentando transformar essas capacidades em uma poderosa instalação de descoberta de materiais, "Fukuto disse.