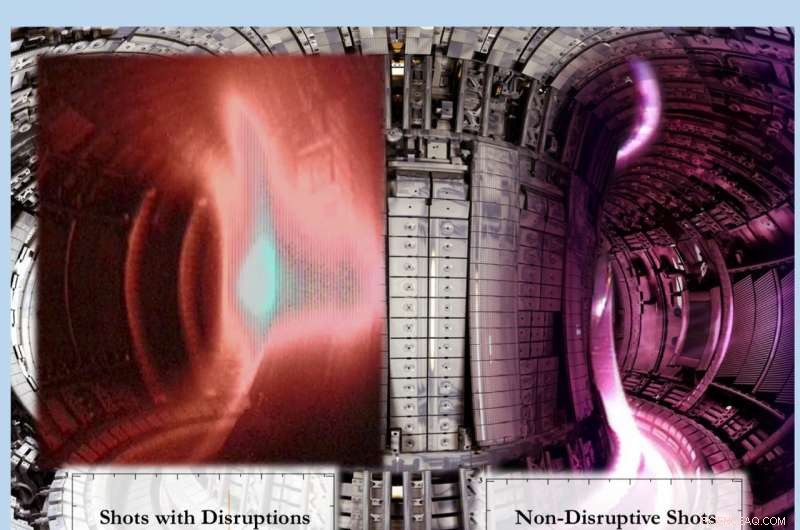

Ruptura de plasma em experimento no JET, deixou, e experimento sem interrupções no JET, direito. O treinamento da rede neural FRNN para prever interrupções exige a atribuição de pesos ao fluxo de dados ao longo das conexões entre os nós. Os dados de novos experimentos são então colocados na rede, que prevê "interrupção" ou "não interrupção". O objetivo final é pelo menos 95% de previsões corretas de eventos de interrupção. Crédito:Eliot Feibush.

Antes que os cientistas possam efetivamente capturar e implantar a energia de fusão, eles devem aprender a prever grandes interrupções que podem interromper as reações de fusão e danificar as paredes dos dispositivos de fusão em forma de rosca chamados tokamaks. Previsão oportuna de interrupções, a repentina perda de controle do calor, plasma carregado que alimenta as reações, será vital para desencadear etapas para evitar ou mitigar tais eventos de grande escala.

Hoje, pesquisadores do Departamento de Energia dos EUA (DOE) Princeton Plasma Physics Laboratory (PPPL) e da Universidade de Princeton estão empregando inteligência artificial para melhorar a capacidade preditiva. Pesquisadores liderados por William Tang, um físico do PPPL e um conferencista com o título e o título de professor da Universidade de Princeton, estão desenvolvendo o código para previsões para ITER, a experiência internacional em construção na França para demonstrar a praticidade da energia de fusão.

Forma de "aprendizado profundo"

O novo software preditivo, chamado de código Fusion Recurrent Neural Network (FRNN), é uma forma de "aprendizado profundo", uma versão mais nova e poderosa do software de aprendizado de máquina moderno, uma aplicação de inteligência artificial. "O aprendizado profundo representa um novo e estimulante caminho para a previsão de interrupções, "Tang disse." Este recurso agora pode lidar com dados multidimensionais. "

FRNN é uma arquitetura de aprendizado profundo que provou ser a melhor maneira de analisar dados sequenciais com padrões de longo alcance. Membros da equipe de aprendizado de máquina da PPPL e da Universidade de Princeton são os primeiros a aplicar sistematicamente uma abordagem de aprendizado profundo ao problema de previsão de interrupção em plasmas de fusão tokamak.

O arquiteto-chefe da FRNN é Julian Kates-Harbeck, um estudante de pós-graduação na Harvard University e um DOE-Office of Science Computational Science Graduate Fellow. Com base na experiência adquirida ao obter o título de mestre em ciência da computação na Universidade de Stanford, ele liderou a construção do software FRNN.

Previsões mais precisas

Usando essa abordagem, a equipe demonstrou a capacidade de prever eventos perturbadores com mais precisão do que os métodos anteriores. Com base na enorme base de dados na instalação Joint European Torus (JET) localizada no Reino Unido - o maior e mais poderoso tokamak em operação - os pesquisadores melhoraram significativamente as previsões de interrupções e reduziram o número de alarmes falsos positivos. EUROfusion, o Consórcio Europeu para o Desenvolvimento da Energia de Fusão, gerencia a pesquisa do JET.

A equipe agora visa atingir os objetivos desafiadores que o ITER exigirá. Isso inclui a produção de 95 por cento de previsões corretas quando ocorrem interrupções, enquanto fornece menos de 3 por cento de alarmes falsos quando não há interrupções. "Nos conjuntos de dados de teste examinados, o FRNN melhorou a curva para prever verdadeiros positivos enquanto reduz os falsos positivos, "disse Eliot Feibush, um cientista computacional da PPPL, referindo-se ao que é chamado de curva "Receiver Operating Characteristic", que é comumente usada para medir a precisão do aprendizado de máquina. "Estamos trabalhando para trazer mais dados de treinamento para fazer ainda melhor."

Altamente exigente

O processo é altamente exigente. "Treinar redes neurais profundas é uma tarefa computacionalmente intensiva que requer o envolvimento de hardware de computação de alto desempenho, "disse Alexey Svyatkovskiy, pesquisador de Big Data da Universidade de Princeton. "É por isso que uma grande parte do que fazemos é desenvolver e distribuir novos algoritmos em muitos processadores para obter uma computação paralela altamente eficiente. Essa computação vai lidar com o tamanho crescente dos problemas extraídos da base de dados relevante para interrupções do JET e outros tokamaks. "

O código de aprendizado profundo é executado em unidades de processamento gráfico (GPUs) que podem calcular milhares de cópias de um programa de uma vez, muito mais do que as unidades de processamento central (CPUs) mais antigas. Testes realizados em clusters de GPU modernos, e em máquinas de classe mundial, como Titan, atualmente o supercomputador mais rápido e poderoso dos EUA no Oak Ridge Leadership Computing Facility, um DOE Office of Science User Facility no Oak Ridge National Laboratory, demonstraram excelente escalonamento linear. Esse dimensionamento reduz o tempo de execução computacional em proporção direta ao número de GPUs usadas - um requisito importante para o processamento paralelo eficiente.

Aglomerado de tigres de Princeton

O cluster Tiger de GPUs modernas da Universidade de Princeton foi o primeiro a realizar testes de aprendizado profundo, usando FRNN para demonstrar a capacidade aprimorada de prever interrupções de fusão. Desde então, o código foi executado no Titan e em outros clusters de GPU de supercomputação líderes nos Estados Unidos, Europa e Ásia, e continuaram a mostrar um excelente escalonamento com o número de GPUs contratadas.

Daqui para frente, os pesquisadores procuram demonstrar que este poderoso software preditivo pode ser executado em tokamaks em todo o mundo e, eventualmente, no ITER. Também está planejado o aprimoramento da velocidade da análise de interrupção para os tamanhos crescentes de problemas associados aos conjuntos de dados maiores antes do início de um evento de interrupção. O apoio para este projeto veio principalmente dos fundos de Pesquisa e Desenvolvimento Dirigidos por Laboratório fornecidos pelo PPPL.