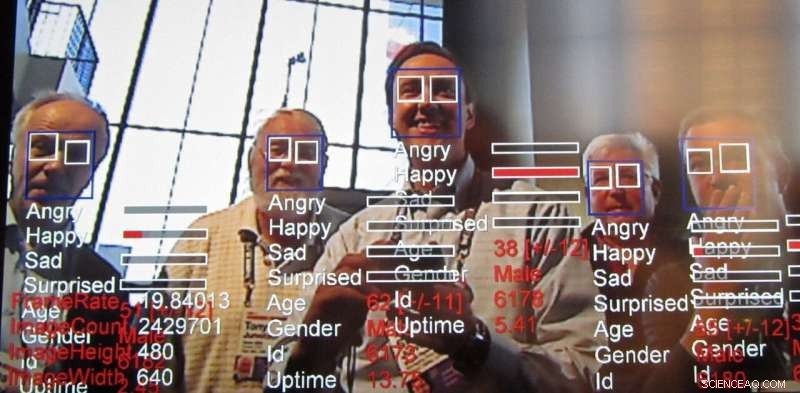

Tecnologia de reconhecimento de emoções, uma conseqüência da tecnologia de reconhecimento facial, continua a avançar rapidamente. Crédito:Steve Jurvetson / flickr, CC BY-SA

Em seu relatório anual, o AI Now Institute, um centro de pesquisa interdisciplinar que estuda as implicações sociais da inteligência artificial, pediu a proibição de tecnologia projetada para reconhecer as emoções das pessoas em certos casos. Especificamente, os pesquisadores disseram que afetam a tecnologia de reconhecimento, também chamada de tecnologia de reconhecimento de emoção, não deve ser usado em decisões que "impactam a vida das pessoas e o acesso a oportunidades, "como decisões de contratação ou avaliações de dor, porque não é suficientemente preciso e pode levar a decisões tendenciosas.

O que é essa tecnologia, que já está sendo usado e comercializado, e por que está levantando preocupações?

Conseqüência do reconhecimento facial

Os pesquisadores têm trabalhado ativamente em algoritmos de visão computacional que podem determinar as emoções e as intenções dos humanos, junto com fazer outras inferências, por pelo menos uma década. A análise da expressão facial existe desde pelo menos 2003. Os computadores são capazes de entender as emoções por ainda mais tempo. Essa tecnologia mais recente se baseia em técnicas centradas em dados conhecidas como "aprendizado de máquina, "algoritmos que processam dados para" aprender "como tomar decisões, para obter um reconhecimento de afeto ainda mais preciso.

O desafio de ler emoções

Os pesquisadores estão sempre procurando fazer coisas novas com base no que já foi feito antes. O reconhecimento da emoção é atraente porque, de alguma forma, nós, como humanos, podemos realizar isso relativamente bem, mesmo desde tenra idade, e ainda replicar habilmente essa habilidade humana usando a visão computacional ainda é um desafio. Embora seja possível fazer coisas notáveis com imagens, como estilizar uma foto para fazer com que pareça ter sido desenhada por um artista famoso e até mesmo criar rostos foto-realistas - sem mencionar a criação dos chamados deepfakes - a capacidade de inferir propriedades como emoções humanas a partir de uma imagem real sempre foi tem sido de interesse para pesquisadores.

As emoções são difíceis porque tendem a depender do contexto. Por exemplo, quando alguém está se concentrando em algo, pode parecer que está simplesmente pensando. O reconhecimento facial percorreu um longo caminho com o aprendizado de máquina, mas identificar o estado emocional de uma pessoa com base puramente em olhar para o rosto dela está faltando informações importantes. As emoções são expressas não apenas por meio da expressão de uma pessoa, mas também onde ela está e o que está fazendo. Essas dicas contextuais são difíceis de alimentar até mesmo em algoritmos modernos de aprendizado de máquina. Para endereçar isto, existem esforços ativos para aumentar as técnicas de inteligência artificial para considerar o contexto, não apenas para reconhecimento de emoção, mas todos os tipos de aplicações.

Lendo as emoções dos funcionários

O relatório divulgado pela AI Now lança luz sobre algumas maneiras em que a IA está sendo aplicada à força de trabalho para avaliar a produtividade do trabalhador e até mesmo na fase de entrevista. Analisando filmagens de entrevistas, especialmente para quem procura emprego remoto, já está em andamento. Se os gerentes puderem ter uma ideia das emoções de seus subordinados desde a entrevista até a avaliação, tomada de decisão em relação a outras questões trabalhistas, como aumentos, promoções ou atribuições podem acabar sendo influenciadas por essas informações. Mas existem muitas outras maneiras de usar essa tecnologia.

Porque a preocupação

Esses tipos de sistemas quase sempre são justos, prestação de contas, falhas de transparência e ética ("FATE") embutidas em sua correspondência de padrões. Por exemplo, um estudo descobriu que algoritmos de reconhecimento facial classificaram rostos de pessoas negras como mais raivosos do que rostos brancos, mesmo quando eles estavam sorrindo.

Muitos grupos de pesquisa estão lidando com este problema, mas parece claro neste ponto que o problema não pode ser resolvido exclusivamente no nível tecnológico. Questões relacionadas a FATE em IA exigirão um esforço contínuo e concentrado por parte daqueles que usam a tecnologia para estar cientes dessas questões e resolvê-las. Como destaca o relatório da AI Now:"Apesar do aumento no conteúdo de ética da IA ... os princípios e declarações éticos raramente se concentram em como a ética da IA pode ser implementada e se eles são eficazes." Ele observa que tais declarações de ética de IA ignoram amplamente as questões de como, Onde, e quem colocará essas diretrizes em operação. Na realidade, é provável que todos estejam cientes dos tipos de preconceitos e fraquezas que esses sistemas apresentam, semelhante a como devemos estar cientes de nossos próprios preconceitos e dos outros.

O problema com as proibições de tecnologia geral

Maior precisão e facilidade no monitoramento persistente trazem outras preocupações além da ética. Há também uma série de questões gerais de privacidade relacionadas à tecnologia, abrangendo desde a proliferação de câmeras que servem como feeds da polícia até o potencial de tornar dados confidenciais anônimos.

Com essas preocupações éticas e de privacidade, uma reação natural pode ser pedir a proibição dessas técnicas. Certamente, aplicar IA a resultados de entrevistas de emprego ou procedimentos de condenação criminal parece perigoso se os sistemas estão aprendendo preconceitos ou não são confiáveis. Existem aplicativos úteis, no entanto, por exemplo, ajudando a detectar sinais de alerta para prevenir o suicídio de jovens e detectar motoristas bêbados. Essa é uma razão pela qual até mesmo pesquisadores preocupados, reguladores e cidadãos em geral pararam de pedir proibições gerais de tecnologias relacionadas à IA.

Combinando IA e julgamento humano

Em última análise, designers de tecnologia e a sociedade como um todo precisam observar cuidadosamente como as informações dos sistemas de IA são injetadas nos processos de tomada de decisão. Esses sistemas podem dar resultados incorretos como qualquer outra forma de inteligência. Eles também são notoriamente ruins em avaliar sua própria confiança, não ao contrário dos humanos, mesmo em tarefas mais simples, como a capacidade de reconhecer objetos. Também permanecem desafios técnicos significativos na leitura de emoções, principalmente considerando o contexto para inferir emoções.

Se as pessoas dependem de um sistema que não é preciso na tomada de decisões, os usuários desse sistema estão em pior situação. Também é sabido que os humanos tendem a confiar mais nesses sistemas do que em outras figuras de autoridade. Diante disso, nós, como sociedade, precisamos considerar cuidadosamente a justiça desses sistemas, prestação de contas, transparência e ética durante o design e a aplicação, sempre mantendo um humano como o tomador de decisão final.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.