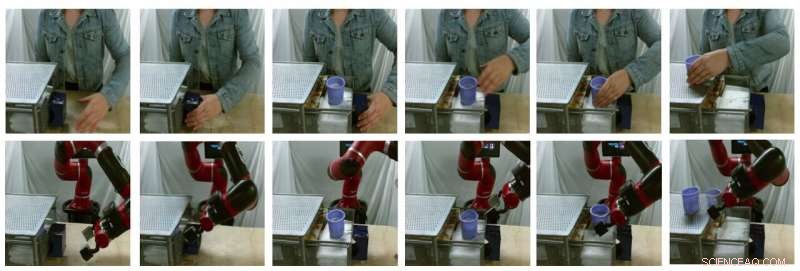

Amostras de fotos de traduções geradas por modelos (a linha superior são imagens humanas reais, a linha inferior são imagens de robôs falsas). Crédito:Smith et al.

Nos últimos anos, equipes de pesquisa em todo o mundo têm usado o aprendizado por reforço (RL) para ensinar os robôs a realizar uma variedade de tarefas. Treinar esses algoritmos, Contudo, pode ser muito desafiador, pois também requer esforços humanos substanciais para definir adequadamente as tarefas que o robô deve completar.

Uma maneira de ensinar os robôs a realizar tarefas específicas é por meio de demonstrações humanas. Embora isso possa parecer simples, pode ser muito difícil de implementar, principalmente porque robôs e humanos têm corpos muito diferentes, assim, eles são capazes de movimentos diferentes.

Pesquisadores da Universidade da Califórnia em Berkeley desenvolveram recentemente uma nova estrutura que pode ajudar a superar alguns dos desafios encontrados ao treinar robôs por meio de aprendizagem por imitação (ou seja, usando demonstrações humanas). Sua estrutura, chamado AVID, com base em dois modelos de aprendizagem profunda desenvolvidos em pesquisas anteriores.

"Ao desenvolver AVID, construímos principalmente em dois trabalhos recentes, CycleGAN e SOLAR, que introduziu abordagens para abordar as limitações fundamentais que impediram a aprendizagem de vídeos humanos em mudança de domínio e treinamento em um robô físico a partir de entrada visual, respectivamente, "Laura Smith, um dos pesquisadores que realizou o estudo, disse TechXplore.

Em vez de usar técnicas que não levam em consideração as diferenças entre um robô e o corpo de um usuário humano, Smith e seus colegas usaram Cycle-GAN, uma técnica que pode transformar imagens em um nível de pixel. Usando Cycle-GAN, seu método converte demonstrações humanas de como completar uma determinada tarefa em vídeos de um robô completando a mesma tarefa. Eles então usaram esses vídeos para desenvolver uma função de recompensa para um algoritmo RL.

Amostras de fotos de traduções geradas por modelos (a linha superior são imagens humanas reais, a linha inferior são imagens de robôs falsas). Crédito:Smith et al.

"AVID funciona fazendo com que o robô observe um ser humano realizando alguma tarefa e, em seguida, imagine como seria para si mesmo realizar a mesma coisa, "Smith explicou." Para saber como realmente alcançar esse sucesso imaginado, deixamos o robô aprender por tentativa e erro. "

Usando a estrutura desenvolvida por Smith e seus colegas, um robô aprende tarefas um estágio de cada vez, redefinir cada estágio e tentar novamente sem exigir a intervenção de um usuário humano. O processo de aprendizagem, portanto, torna-se amplamente automatizado, com o robô aprendendo novas habilidades com o mínimo de intervenção humana.

"Uma das principais vantagens da nossa abordagem é que o professor humano pode interagir com o aluno robô enquanto ele está aprendendo, "Smith explicou." Além disso, projetamos nossa estrutura de treinamento para ser receptiva ao aprendizado de um comportamento de longo prazo com o mínimo de esforço. "

Os pesquisadores avaliaram sua abordagem em uma série de testes e descobriram que ela pode efetivamente ensinar os robôs a realizar tarefas complexas, como operar uma máquina de café, simplesmente processando 20 minutos de vídeos de demonstração humanos crus e praticando a nova habilidade por 180 minutos. Além disso, AVID superou todas as outras técnicas para as quais era, incluindo ablação por imitação, ablação de espaço de pixel, e abordagens de clonagem comportamental.

"O que descobrimos é que podemos alavancar o CycleGAN para efetivamente fazer vídeos de demonstrações humanas compreensíveis para o robô sem exigir um processo tedioso de coleta de dados, "Smith disse." Nós também mostramos que explorar a natureza de vários estágios de tarefas estendidas temporalmente nos permite aprender um comportamento robusto enquanto facilita o treinamento. Vemos nosso trabalho como um passo significativo para trazer a implantação do mundo real de robôs autônomos ao nosso alcance, pois nos dá uma forma muito natural, maneira intuitiva de ensiná-los. "

A nova estrutura de aprendizagem introduzida por Smith e seus colegas permite um tipo diferente de aprendizagem de imitação, onde um robô aprende a completar uma meta de nível superior por vez, concentrando-se no que considera mais desafiador em cada etapa. Além disso, em vez de exigir que usuários humanos reconfigurem a cena após cada tentativa prática, permite que os robôs reiniciem a cena automaticamente e continuem praticando. No futuro, AVID pode melhorar os processos de aprendizagem de imitação, permitindo que os desenvolvedores treinem robôs de forma mais rápida e eficaz.

"Uma das principais limitações do nosso trabalho até agora é que exigimos a coleta de dados e o treinamento do CycleGAN para cada nova cena que o robô possa encontrar. Esperamos ser capazes de tratar o treinamento do CycleGAN como uma única vez, O custo inicial tal que o treinamento uma vez em um grande corpus de dados pode permitir que o robô adquira rapidamente uma grande variedade de habilidades com algumas demonstrações e um pouco de prática. "

© 2020 Science X Network