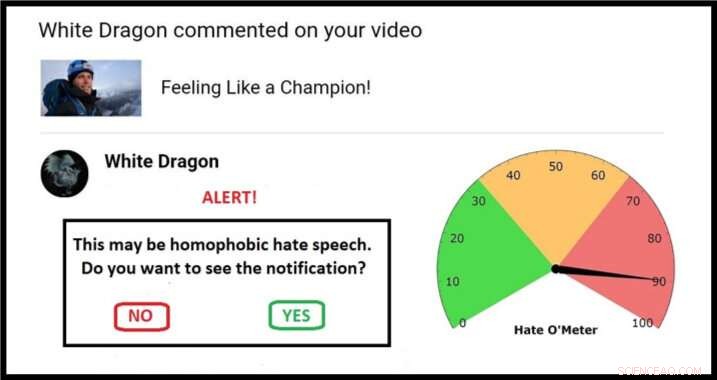

Exemplo de uma abordagem possível para uma tela de quarentena, completo com Hate O'Meter. Crédito:Stefanie Ullman

A disseminação do discurso de ódio através da mídia social poderia ser combatida usando a mesma abordagem de "quarentena" implantada para combater software malicioso, de acordo com pesquisadores da Universidade de Cambridge.

As definições de discurso de ódio variam de acordo com a nação, lei e plataforma, e apenas bloquear palavras-chave é ineficaz:as descrições gráficas de violência não precisam conter calúnias étnicas óbvias para constituir ameaças de morte racistas, por exemplo.

Como tal, discurso de ódio é difícil de detectar automaticamente. Tem que ser relatado por aqueles expostos a ele, depois que o pretendido "dano psicológico" é infligido, com exércitos de moderadores necessários para julgar cada caso.

Esta é a nova linha de frente de um antigo debate:liberdade de expressão versus linguagem venenosa.

Agora, um engenheiro e um linguista publicaram uma proposta na revista Ética e Tecnologia da Informação que aproveita técnicas de segurança cibernética para dar controle aos alvos, sem recorrer à censura.

Os especialistas em idiomas e aprendizado de máquina de Cambridge estão usando bancos de dados de ameaças e insultos violentos para construir algoritmos que podem fornecer uma pontuação para a probabilidade de uma mensagem online contendo formas de discurso de ódio.

À medida que esses algoritmos são refinados, potencial discurso de ódio pode ser identificado e colocado em "quarentena". Os usuários receberiam um alerta de aviso com um "Hate O'Meter" - a pontuação de gravidade do discurso de ódio - o nome do remetente, e uma opção para visualizar o conteúdo ou excluir o que não foi visto.

Essa abordagem é semelhante a filtros de spam e malware, e pesquisadores do projeto 'Dando Voz às Democracias Digitais' acreditam que isso poderia reduzir drasticamente a quantidade de discurso de ódio que as pessoas são forçadas a vivenciar. Eles pretendem ter um protótipo pronto no início de 2020.

"O discurso de ódio é uma forma de dano online intencional, como malware, e pode, portanto, ser tratada por meio de quarentena, "disse o co-autor e linguista Dr. Stefanie Ullman." Na verdade, muito discurso de ódio é gerado por softwares como os bots do Twitter. "

"Empresas como o Facebook, O Twitter e o Google geralmente respondem reativamente ao discurso de ódio, "disse o co-autor e engenheiro Dr. Marcus Tomalin." Isso pode ser bom para aqueles que não o encontram com frequência. Para outros é muito pouco, muito tarde."

"Muitas mulheres e pessoas de grupos minoritários que são vistos pelo público recebem um discurso de ódio anônimo por ousar ter uma presença online. Estamos vendo isso impedir as pessoas de entrar ou continuar na vida pública, muitas vezes, aqueles de grupos que precisam de maior representação, " ele disse.

A ex-secretária de Estado dos EUA, Hillary Clinton, disse recentemente a uma audiência do Reino Unido que o discurso de ódio representava uma "ameaça às democracias", na esteira de muitas mulheres parlamentares que citam abusos online como parte da razão pela qual elas não irão mais se candidatar.

Enquanto estava em um discurso na Universidade de Georgetown, O CEO do Facebook, Mark Zuckerberg, falou sobre "amplas divergências sobre o que se qualifica como ódio" e argumentou:"devemos errar por usar mais expressão".

Os pesquisadores dizem que sua proposta não é uma solução mágica, mas fica entre as "abordagens libertárias e autoritárias extremas" de permitir ou proibir inteiramente certa linguagem online.

Mais importante, o usuário se torna o árbitro. "Muitas pessoas não gostam da ideia de uma empresa não eleita ou um governo microgerenciado decidindo o que podemos ou não dizer uns aos outros, "disse Tomalin.

"Nosso sistema sinalizará quando você deve ter cuidado, mas é sempre sua decisão. Isso não impede que as pessoas postem ou vejam o que gostam, mas dá o controle necessário para aqueles que estão sendo inundados com ódio. "

No papel, os pesquisadores referem-se a algoritmos de detecção que alcançam 60% de precisão - não muito melhor do que o acaso. O laboratório de aprendizado de máquina da Tomalin agora chega a 80%, e ele antecipa a melhoria contínua da modelagem matemática.

Enquanto isso, Ullman reúne mais "dados de treinamento":discurso de ódio verificado com o qual os algoritmos podem aprender. Isso ajuda a refinar as "pontuações de confiança" que determinam uma quarentena e subsequente leitura de Hate O'Meter, que pode ser definido como um dial de sensibilidade, dependendo da preferência do usuário.

Um exemplo básico pode envolver uma palavra como 'cadela':uma calúnia misógina, mas também um termo legítimo em contextos como a criação de cães. É a análise algorítmica de onde essa palavra se encaixa sintaticamente - os tipos de palavras ao redor e as relações semânticas entre elas - que informa a pontuação do discurso de ódio.

"Identificar palavras-chave individuais não é suficiente, estamos olhando para estruturas de sentenças inteiras e muito mais além. Informações sociolingüísticas em perfis de usuário e históricos de postagem podem ajudar a melhorar o processo de classificação, "disse Ullman.

Adicionou Tomalin:"Por meio de quarentenas automatizadas que fornecem orientação sobre a força do conteúdo de incitação ao ódio, podemos capacitar aqueles que recebem o discurso de ódio, envenenando nossos discursos online. "

Contudo, Os pesquisadores, que trabalham no Centro de Pesquisa em Artes de Cambridge, Humanidades e Ciências Sociais (CRASSH), dizem que - como acontece com os vírus de computador - sempre haverá uma corrida armamentista entre o discurso de ódio e os sistemas para limitá-lo.

O projeto também começou a olhar para o "contra-discurso":as formas como as pessoas respondem ao discurso de ódio. Os pesquisadores pretendem alimentar debates sobre como assistentes virtuais como 'Siri' devem responder a ameaças e intimidação.