Os pesquisadores do CMU desenvolveram um método para identificar automaticamente os memes e aplicar modelos pré-escritos para adicionar texto alternativo descritivo, tornando-os inteligíveis por meio de tecnologias assistivas, como leitores de tela. Crédito:Carnegie Mellon University

Pessoas com deficiência visual usam as redes sociais como todas as outras pessoas, frequentemente com a ajuda de um software leitor de tela. Mas essa tecnologia falha quando encontra memes, que não incluem texto alternativo, ou texto alternativo, para descrever o que está representado na imagem.

Para combater isso, pesquisadores da Carnegie Mellon University desenvolveram um método para identificar automaticamente memes e aplicar modelos pré-escritos para adicionar texto alternativo descritivo, tornando-os inteligíveis por meio de tecnologias assistivas existentes.

Memes são imagens que são copiadas e sobrepostas com pequenas variações de texto. Muitas vezes são bem-humorados e transmitem uma experiência compartilhada, mas "se você é cego, você sente falta dessa parte da conversa, "disse Cole Gleason, um Ph.D. estudante no Instituto de Interação Humano-Computador da CMU (HCII.)

"Memes pode não parecer o problema mais importante, mas uma parte vital da acessibilidade não é escolher para as pessoas o que merece sua atenção, "disse Jeff Bigham, professor associado do HCII. "Muitas pessoas usam memes, e por isso devem ser acessíveis. "

Em grande parte, os memes vivem em plataformas de mídia social que têm barreiras para adicionar texto alternativo. Twitter, por exemplo, permite que as pessoas adicionem texto alternativo às suas imagens, mas esse recurso nem sempre é fácil de encontrar. De 9 milhões de tweets que os pesquisadores do CMU examinaram, um milhão de imagens incluídas e, daqueles, apenas 0,1 por cento incluiu texto alternativo.

Gleason disse que técnicas básicas de visão computacional tornam possível descrever as imagens subjacentes a cada meme, seja uma celebridade, um bebê chorando, um personagem de desenho animado ou uma cena como um ônibus derrubado em um ralo. Técnicas de reconhecimento óptico de caracteres são usadas para decifrar o texto sobreposto, que pode mudar com cada iteração do meme. Para cada tipo de meme, é necessário apenas fazer um modelo que descreva a imagem, e o texto sobreposto pode ser adicionado para cada iteração desse meme.

Mas escrever o que o meme pretende transmitir revelou-se difícil.

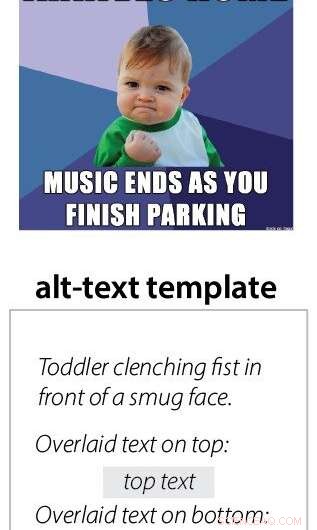

"Dependia do meme se o humor fosse traduzido. Algumas das imagens são mais matizadas, "Gleason disse." E às vezes é explícito e você pode simplesmente descrevê-lo. "Por exemplo, o texto alternativo completo para o meme chamado "garoto do sucesso" declara "Criança cerrando o punho na frente de uma cara presunçosa. Texto sobreposto na parte superior:Foi um menino mau o ano todo. Texto sobreposto na parte inferior:Ainda ganhei presentes incríveis do Papai Noel."

A equipe também criou uma plataforma para traduzir memes em som, em vez de texto. Os usuários pesquisam em uma biblioteca de sons e arrastam e soltam elementos em um modelo. Este sistema foi feito para traduzir memes existentes e transmitir o sentimento por meio de música e efeitos sonoros.

"Um dos motivos pelos quais tentamos os memes de áudio foi porque pensamos que o texto alternativo acabaria com a piada, mas as pessoas ainda preferem o texto porque estão tão acostumadas com ele, "Gleason disse.

A implantação da tecnologia será um desafio. Mesmo que fosse integrado a um site gerador de meme, esse texto alternativo não seria copiado automaticamente quando a imagem fosse compartilhada nas redes sociais.

"Teríamos que convencer o Twitter a adicionar um novo recurso, "Disse Gleason. Pode ser algo adicionado a um smartphone pessoal, mas ele observou que isso colocaria o fardo sobre o usuário. Os pesquisadores da CMU estão atualmente trabalhando em projetos relacionados, incluindo uma extensão do navegador para o Twitter que tenta adicionar texto alternativo para cada imagem e pode incluir um sistema de meme. Outro projeto busca integrar o texto alternativo aos metadados das imagens que permaneceriam com a imagem onde quer que fosse postada.

Este trabalho foi apresentado no início deste ano na conferência ACCESS em Pittsburgh. Outros pesquisadores envolvidos no projeto incluem a bolsista de pós-doutorado do HCII, Amy Pavel, Xingyu Liu, estudante de graduação da CMU, Professor assistente de HCII Patrick Carrington, e Lydia Chilton, da Columbia University.