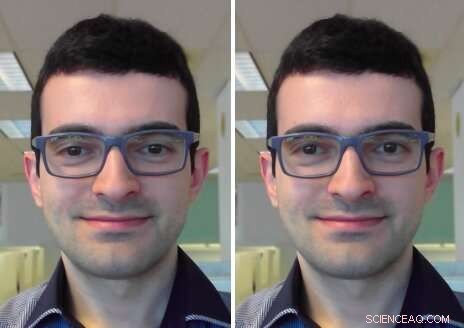

Correção do contato visual:no quadro de entrada (esquerda), o usuário está olhando para a tela. No quadro de saída (à direita), seu olhar é corrigido para olhar para a câmera. Crédito:Isikdogan, Gerasimow &Michael.

Ao participar de uma videochamada ou conferência, muitas vezes é difícil manter contato visual direto com outros participantes, pois isso requer olhar para a câmera em vez de para a tela. Embora a maioria das pessoas use serviços de videochamada regularmente, até aqui, não houve uma solução generalizada para esse problema.

Uma equipe de pesquisadores da Intel desenvolveu recentemente um modelo de correção de contato visual que pode ajudar a superar esse incômodo, restaurando o contato visual em chats de vídeo ao vivo, independentemente de onde a câmera e a tela do dispositivo estão situadas. Ao contrário das abordagens propostas anteriormente, este modelo centraliza automaticamente o olhar de uma pessoa sem a necessidade de entradas especificando o ângulo de redirecionamento ou a câmera / tela / geometria do usuário.

"O principal objetivo do nosso projeto é melhorar a qualidade das experiências de videoconferência, tornando mais fácil manter o contato visual, "Leo Isikdogan, um dos pesquisadores que realizou o estudo, disse TechXplore. "É difícil manter contato visual durante uma videochamada porque não é natural olhar para a câmera durante uma chamada. As pessoas olham para a imagem da outra pessoa em sua tela, ou às vezes eles até olham para sua própria imagem de visualização, mas não para a câmera. Com este novo recurso de correção de contato visual, os usuários poderão ter uma conversa cara a cara natural. "

O objetivo principal do estudo realizado por Isikdogan e seus colegas era criar uma experiência natural de chat por vídeo. Para alcançar isto, eles só queriam que seu recurso de correção de contato visual funcionasse quando um usuário estivesse envolvido na conversa, em vez de quando eles tiram naturalmente os olhos da tela (por exemplo, ao olhar para papéis ou manipular objetos ao seu redor).

"Correção do contato visual e redirecionamento do olhar em geral, não são novas ideias de pesquisa, "Disse Isikdogan." Muitos pesquisadores propuseram modelos para manipular para onde as pessoas estão olhando nas imagens. Contudo, alguns deles requerem configurações especiais de hardware, outros precisam de informações adicionais do usuário, como em que direção e em quanto o redirecionamento precisa ser, e outros usam processos computacionalmente caros que são viáveis apenas para o processamento de vídeos pré-gravados. "

O novo sistema desenvolvido por Isikdogan e seus colegas usa uma rede neural convolucional profunda (CNN) para redirecionar o olhar de uma pessoa, distorcendo e ajustando os olhos em seus quadros de entrada. Essencialmente, a CNN processa uma imagem monocular e produz um campo vetorial e um mapa de brilho para corrigir o olhar do usuário.

Em contraste com as abordagens propostas anteriormente, seu sistema pode ser executado em tempo real, fora da caixa e sem exigir nenhuma entrada de usuários ou hardware dedicado. Além disso, o corretor funciona em uma variedade de dispositivos com diferentes tamanhos de exibição e posições de câmera.

"Nosso corretor de contato visual usa um conjunto de mecanismos de controle que evitam mudanças abruptas e garantem que o corretor de contato visual evita fazer qualquer correção não natural que de outra forma seria assustadora, "Isikdogan disse." Por exemplo, a correção é desabilitada suavemente quando o usuário pisca ou olha para algum lugar distante. "

Os pesquisadores treinaram seu modelo de forma bidirecional em um grande conjunto de dados gerados sinteticamente, imagens fotorrealistas e rotuladas. Eles então avaliaram sua eficácia e como os usuários a percebiam em uma série de testes cegos.

"Nosso teste cego mostrou que a maioria das pessoas não sabe quando ligamos ou desligamos nosso algoritmo, eles não veem artefatos, mas sentem que têm contato visual com a pessoa com quem estão se comunicando, "Gilad Michael, outro pesquisador envolvido no estudo, disse TechXplore.

Interessantemente, os pesquisadores observaram que seu modelo também aprendeu a prever o olhar de entrada (ou seja, onde pensava que um usuário estava olhando antes que seu olhar fosse corrigido), mesmo que nunca tenha sido treinado para isso. Eles acreditam que essa capacidade pode ser um subproduto do redirecionamento contínuo do modelo do olhar do usuário para o centro, sem especificar onde um usuário estava olhando em primeiro lugar.

"O modelo simplesmente inferiu o olhar de entrada para que possa movê-lo para o centro, "Isikdogan explicou." Portanto, podemos indiscutivelmente considerar o problema de correção do contato visual como um superconjunto parcial da previsão do olhar. "

As descobertas coletadas pelos pesquisadores também destacam o valor do uso de dados sintéticos fotorrealistas para treinar algoritmos. Na verdade, seu modelo alcançou resultados notáveis, mesmo que durante o treinamento tenha se baseado quase inteiramente em imagens geradas por computador. Os pesquisadores estão longe de ser os primeiros a experimentar dados de treinamento sintéticos, ainda assim, seu estudo é mais uma confirmação de seu potencial para a criação de aplicativos de alto desempenho.

"Também confirmamos que é uma boa prática manter a reversibilidade do mapeamento em mente ao construir modelos que manipulam suas entradas, "Isikdogan acrescentou." Por exemplo, se o modelo está movendo alguns pixels da parte inferior esquerda para o centro, devemos ser capazes de pedir ao modelo para movê-los de volta para o canto esquerdo inferior e obter uma imagem que parece quase idêntica à imagem original. Essa abordagem evita que o modelo modifique as imagens além do reparo. "

No futuro, o sistema proposto por Isikdogan, Michael e seu colega Timo Gerasimow podem ajudar a melhorar as experiências de videoconferência, trazendo-os ainda mais perto de interações pessoais. Os pesquisadores agora planejam finalizar seu sistema para que possa ser aplicado aos serviços de videoconferência existentes.

"Nós nos esforçamos muito para garantir que nossa solução seja prática e pronta para ser usada em produtos reais, "Michael disse." Podemos agora tentar melhorar algumas das descobertas de subprodutos do algoritmo, como detecção de olhar e classificação de engajamento para permitir casos de uso adjacentes. "

© 2019 Science X Network