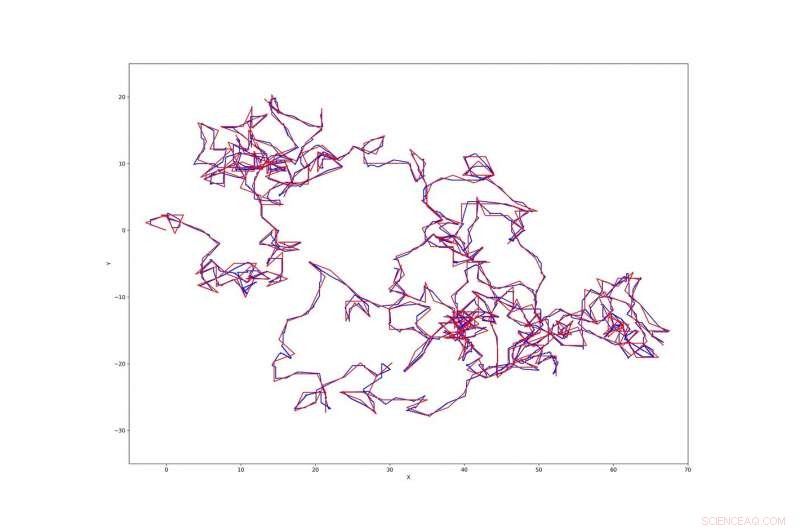

Trajetória do indivíduo de melhor desempenho desde a melhor corrida. Verde:trajetória ótima; azul:trajetória real. Ambos começam em (0, 0). Crédito:Inden &Jost.

Algoritmos evolutivos (EAs) são projetados para replicar o comportamento e a evolução de organismos biológicos enquanto resolvem problemas de computação. Nos últimos anos, muitos pesquisadores desenvolveram EAs e os usaram para lidar com uma variedade de tarefas de otimização.

Estudos anteriores também exploraram o uso desses algoritmos para aprender a topologia e pesos de conexão de redes neurais que acionam robôs ou agentes virtuais. Quando aplicado neste contexto, EAs podem ter inúmeras vantagens, por exemplo, melhorando o desempenho de agentes de inteligência artificial (IA) e melhorando nossa compreensão atual de sistemas biológicos.

Até aqui, Contudo, aplicações de robótica evolutiva do mundo real têm sido escassas, com muito poucos estudos conseguindo produzir comportamentos complexos usando EAs. Pesquisadores da Nottingham Trent University e do Instituto Max Planck de Matemática nas Ciências desenvolveram recentemente uma nova abordagem para desenvolver redes neurais com um crescimento linear sustentado na complexidade de seu comportamento.

"Se quisermos um crescimento linear sustentado da complexidade durante a evolução, devemos garantir que as propriedades do ambiente em que a evolução ocorre, incluindo a estrutura da população e as propriedades das redes neurais que são relevantes para os operadores de mutação aplicados, permanecem constantes em média ao longo do tempo evolutivo, "os pesquisadores explicaram em seu artigo." Congelar estruturas de rede antigas é um método que ajuda a alcançar isso, mas como as investigações apresentadas aqui irão mostrar, não é suficiente por si só e nem mesmo o principal contribuinte para atingir a meta. "

Em seu estudo, os pesquisadores se concentraram em uma tarefa na qual um agente robótico precisa seguir uma trajetória predefinida em um plano 2-D infinito pelo maior tempo possível, que eles chamam de "tarefa de seguimento de trajetória". Em sua versão desta tarefa, o agente não recebeu nenhuma informação por meio de seus sensores sobre onde deveria estar localizado. Se estiver muito longe da trajetória, Contudo, o agente "morre". Nesse contexto, a evolução deve permitir que o agente se adapte a esta tarefa e aprenda a seguir a trajetória usando o controle de malha aberta.

Para alcançar um crescimento linear na complexidade dos comportamentos evolutivos do agente durante a execução desta tarefa, os pesquisadores adicionaram quatro recursos-chave aos métodos padrão para a evolução das redes neurais. Essencialmente, eles congelaram a estrutura previamente desenvolvida da rede, ao mesmo tempo que adiciona andaimes temporais, uma função de transferência homogênea para nós de saída e mutações que criam novos caminhos para saídas.

Embora a adição de mutações às redes e a alteração das funções de transferência de resultados levem a alguma melhoria no desempenho, eles descobriram que o aprimoramento mais significativo estava associado ao uso de andaimes. Isso sugere que as redes neurais padrão não são particularmente boas em produzir comportamento que varia ao longo do tempo de uma forma que seja facilmente acessível pela evolução.

Em seu jornal, os pesquisadores propõem que as redes neurais aumentadas por andaimes podem ser uma solução viável para atingir comportamentos e evolução cada vez mais complexos em redes neurais. No futuro, a abordagem que eles apresentaram pode informar o desenvolvimento de novas ferramentas para desenvolver redes neurais para controle de robôs e outras tarefas.

"Geral, a complexidade evoluída é de até duas ordens de magnitude sobre a alcançada pelos métodos padrão nos experimentos que relatamos, com o principal fator limitante para crescimento adicional sendo o tempo de execução disponível, "os pesquisadores escreveram em seu artigo." Assim, o conjunto de métodos proposto aqui promete ser uma adição útil a vários métodos atuais de neuroevolução. "

© 2019 Science X Network