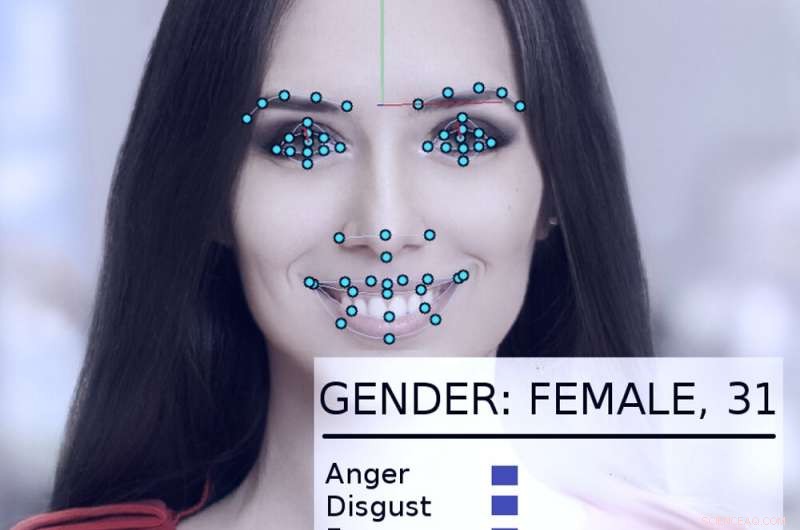

Um sistema de rastreamento e análise de rosto examina o rosto de uma mulher. Crédito:Abyssus / Wikimedia Commons, CC BY-SA

Os sistemas de inteligência artificial podem - se usados corretamente - ajudar a tornar o governo mais eficaz e responsivo, melhorar a vida dos cidadãos. Usado indevidamente, Contudo, as visões distópicas de "1984" de George Orwell tornam-se mais realistas.

Por conta própria e estimulados por uma nova ordem executiva presidencial, governos nos EUA, incluindo agências estaduais e federais, estão explorando maneiras de usar tecnologias de IA.

Como pesquisador de IA por mais de 40 anos, que foi consultor ou participante de muitos projetos governamentais, Eu acredito que é importante notar que às vezes eles fizeram isso bem - e outras vezes não tão bem. Os potenciais danos e benefícios são significativos.

Um sucesso inicial

Em 2015, o Departamento de Segurança Interna dos EUA desenvolveu um sistema de IA chamado "Emma, "um chatbot que pode responder a perguntas feitas a ele em inglês normal, sem precisar saber o que "seu" site introdutório chama de "linguagem do governo" - todos os termos e siglas oficiais usados em documentos de agências.

No final de 2016, O DHS informou que Emma já estava ajudando a responder quase meio milhão de perguntas por mês, permitindo que o DHS lide com muito mais consultas do que antes, e permitir que funcionários humanos gastem mais tempo ajudando pessoas com questões mais complicadas que estão além das habilidades de Emma. Este tipo de inteligência artificial que automatiza a conversação agora tem sido usado por outras agências governamentais, em cidades e países em todo o mundo.

Água de sílex

Um exemplo mais complicado de como os governos poderiam aplicar IA apropriadamente pode ser visto em Flint, Michigan. Enquanto os governos locais e estaduais lutavam para combater a contaminação por chumbo na água potável da cidade, ficou claro que eles precisariam substituir os encanamentos de chumbo remanescentes da cidade. Contudo, os registros da cidade estavam incompletos, e seria extremamente caro cavar todos os encanamentos da cidade para ver se eram de chumbo ou cobre.

Em vez de, cientistas da computação e funcionários do governo colaboraram para analisar uma ampla gama de dados sobre cada um dos 55, 000 propriedades na cidade, incluindo a idade da casa, para calcular a probabilidade de ser servido por tubos de chumbo. Antes de o sistema ser usado, 80% dos tubos escavados precisaram ser substituídos, o que significava 20% do tempo, dinheiro e esforço estavam sendo desperdiçados em canos que não precisavam ser substituídos.

O sistema de IA ajudou os engenheiros a se concentrarem em propriedades de alto risco, identificar um conjunto de propriedades com maior probabilidade de precisar de substituições de tubos. Quando os inspetores da cidade visitaram para verificar a situação, o algoritmo estava certo 70% das vezes. Isso prometia economizar enormes quantias de dinheiro e acelerar o processo de substituição do tubo.

Contudo, a política local atrapalhou. Muitos membros do público não entenderam por que o sistema estava identificando as casas que ele fez, e objetou, dizendo que o método de IA estava ignorando injustamente suas casas. Depois que as autoridades municipais pararam de usar o algoritmo, apenas 15% dos canos desenterrados eram de chumbo. Isso tornou o projeto de substituição mais lento e caro.

Exemplos angustiantes

O problema em Flint era que as pessoas não entendiam que a tecnologia de IA estava sendo bem usada, e que as pessoas estavam verificando suas descobertas com inspeções independentes. Em parte, isso acontecia porque eles não confiavam na IA - e, em alguns casos, há um bom motivo para isso.

Em 2017, Eu estava entre um grupo de mais de quatro dezenas de pesquisadores de IA que enviaram uma carta ao secretário interino do Departamento de Segurança Interna dos Estados Unidos. Expressamos preocupações sobre uma proposta de uso de sistemas automatizados para determinar se uma pessoa que busca asilo nos EUA se tornaria um "membro que contribui positivamente para a sociedade" ou se tem mais probabilidade de ser uma ameaça terrorista.

"Simplificando, "nossa carta dizia, "nenhum método computacional pode fornecer avaliações confiáveis ou objetivas das características que o [DHS] busca medir." Explicamos que o aprendizado de máquina é suscetível a um problema chamado "distorção de dados, "em que a capacidade do sistema de prever uma característica depende em parte de quão comum essa característica é nos dados usados para treinar o sistema.

Então, em um banco de dados de 300 milhões de americanos, se uma em cada 100 pessoas for, dizer, de ascendência indiana, o sistema será bastante preciso em identificá-los. Mas se olharmos para uma característica compartilhada por apenas um em um milhão de americanos, realmente não há dados suficientes para o algoritmo fazer uma boa análise.

Como a carta explica, "na escala da população americana e nas taxas de imigração, atos criminosos são relativamente raros, e atos terroristas são extremamente raros. "É extremamente improvável que a análise de algoritmos identifique potenciais terroristas. Felizmente, nossos argumentos se mostraram convincentes. Em maio de 2018, O DHS anunciou que não usaria um algoritmo de aprendizado de máquina dessa forma.

Outros esforços preocupantes

Outros usos governamentais da IA estão sendo questionados, também - como tentativas de "policiamento preditivo, "estabelecendo valores de fiança e sentenças criminais e contratando funcionários públicos. Todos eles se mostraram suscetíveis a problemas técnicos e limitações de dados que podem influenciar suas decisões com base na raça, gênero ou origem cultural.

Outras tecnologias de IA, como reconhecimento facial, vigilância automatizada e coleta de dados em massa estão levantando preocupações reais sobre a segurança, privacidade, justiça e precisão em uma sociedade democrática.

Como a ordem executiva de Trump demonstra, há um interesse significativo em aproveitar a IA para todo o seu potencial positivo. Mas os perigos significativos do abuso, o uso indevido e o preconceito - seja intencional ou não - têm o potencial de trabalhar contra os próprios princípios sobre os quais as democracias internacionais foram construídas.

Conforme o uso de tecnologias de IA cresce, seja originalmente bem-intencionado ou deliberadamente autoritário, o potencial de abuso também aumenta. Sem supervisão governamental atualmente existente nos EUA, a melhor maneira de evitar esses abusos é ensinar o público sobre os usos apropriados da IA por meio de conversas entre cientistas, cidadãos preocupados e administradores públicos para ajudar a determinar quando e onde é inadequado implantar essas novas ferramentas poderosas.

Este artigo foi republicado de The Conversation sob uma licença Creative Commons. Leia o artigo original.