Crédito:Tautkutè &Trzcinski

Pesquisadores da Academia Polonesa-Japonesa de Tecnologia da Informação e da Universidade de Tecnologia de Varsóvia desenvolveram um modelo de rede de alinhamento profundo (DAN) para classificar e visualizar emoções. Seu método foi encontrado para superar os métodos de classificação de emoção de última geração em dois conjuntos de dados de referência.

O desenvolvimento de modelos que possam reconhecer e classificar as emoções humanas é um desafio fundamental no campo do aprendizado de máquina e da visão computacional. A maioria das ferramentas de reconhecimento de emoção existentes usa redes convolucionais de várias camadas, que não inferem explicitamente as características faciais na fase de classificação.

Ivona Tautkute e Tomasz Trzcinski, os pesquisadores que realizaram o estudo recente, estavam inicialmente trabalhando em um sistema para uma startup com sede na Califórnia que pudesse ser integrado a carros autônomos. Este sistema foi capaz de contar os passageiros com base em dados extraídos de uma única câmera de vídeo montada no interior do carro.

Num estado mais avançado, os dois pesquisadores começaram a explorar modelos que poderiam fazer mais do que isso, criar estatísticas mais amplas sobre os passageiros, estimando sua idade e sexo. Uma extensão óbvia deste sistema era detectar expressões faciais e emoções, também.

"Como o sistema era para ser usado com passageiros idosos, era importante capturar emoções negativas e positivas associadas ao desligamento do motorista, "Tautkute explicou." As abordagens existentes para o reconhecimento de emoções estão longe de ser perfeitas, então começamos a pesquisar novas maneiras interessantes de melhorar. Ocorreu-nos uma ideia após uma discussão com um colega pesquisador de visão computacional, Marek Kowalski, que estava trabalhando no alinhamento facial com rede de alinhamento profundo (DAN). A localização dos pontos de referência faciais está diretamente relacionada à emoção expressa, portanto, estávamos curiosos para saber se poderíamos construir um sistema que combinasse essas duas tarefas. "

EmotionalDAN, o modelo idealizado por Tautkute e Trzcinski, é uma adaptação do modelo DAN de Kowalski, que inclui um termo relacionado às características faciais. Graças a esta modificação, seu modelo simultaneamente aprende a localização de ambos os marcos faciais e emoção expressa.

Crédito:Tautkutè &Trzcinski

Crédito:Tautkutè &Trzcinski

Crédito:Tautkutè &Trzcinski

Crédito:Tautkutè &Trzcinski

"Conseguimos isso estendendo a função de perda do DAN original por um termo responsável pela classificação de emoção, "Tautkute disse." A rede neural é treinada em estágios consecutivos que permitem o refinamento de marcos faciais e emoções aprendidas. Também há uma transferência de informações entre as etapas, que mantém o controle da entrada de rosto normalizado, mapa de recursos e o mapa de calor dos pontos de referência. "

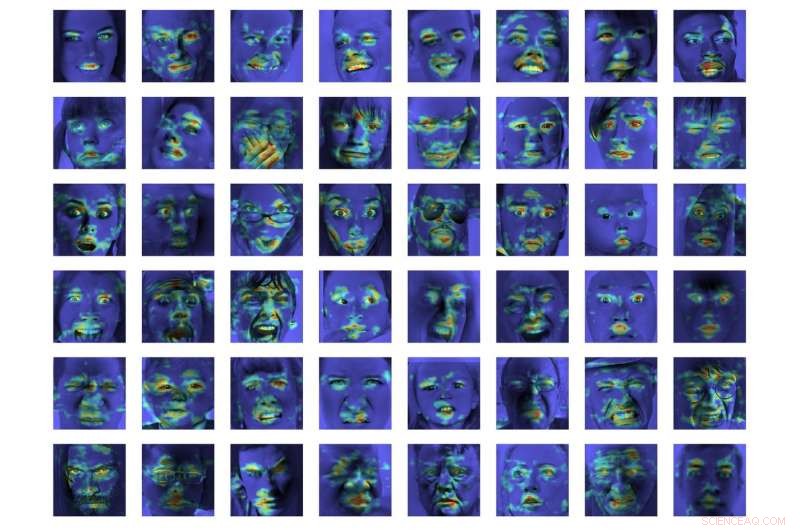

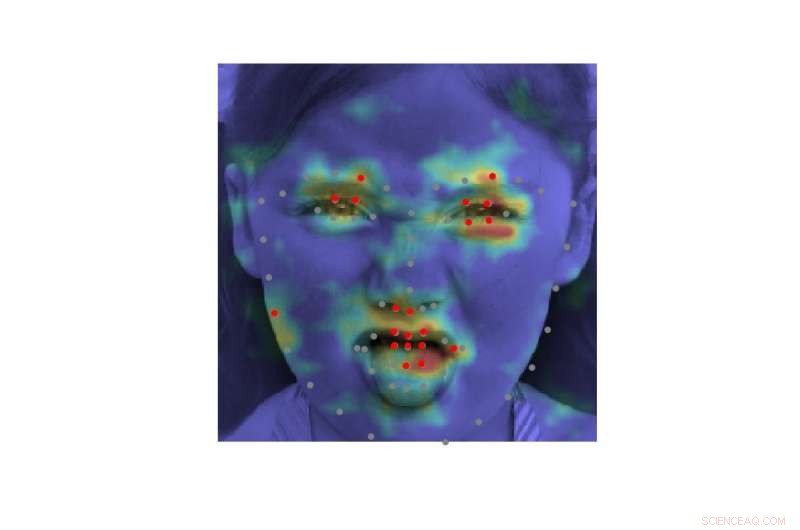

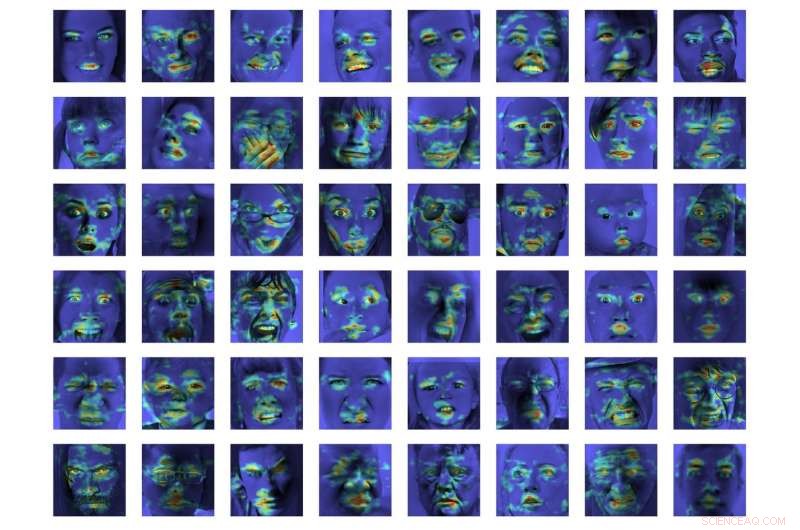

Em uma avaliação inicial, EmotionalDAN superou os métodos de classificação de última geração em 5 por cento em dois conjuntos de dados de referência, nomeadamente CK + e ISED. Os pesquisadores também puderam visualizar regiões da imagem analisadas por seu modelo ao tomar uma decisão. Suas observações revelaram que o EmotionalDAN pode identificar corretamente os marcos faciais associados à expressão de emoções em humanos.

"O que é realmente interessante sobre o nosso estudo é que, embora não forneçamos nenhuma informação espacial relacionada à emoção para a rede, o modelo é capaz de aprender por si mesmo quais regiões do rosto devem ser observadas ao tentar entender as expressões faciais, "Tautkute disse." Nós, humanos, olhamos intuitivamente para os olhos e a boca de uma pessoa para notar sorrisos ou tristeza, mas a rede neural vê apenas uma matriz de pixels. Verificar quais regiões da imagem são ativadas para determinada decisão de classificação nos traz um passo mais perto de entender o modelo e como ele toma decisões. "

Crédito:Tautkutè &Trzcinski.

Apesar dos resultados muito promissores alcançados pelo EmotionalDAN e outras ferramentas de reconhecimento de emoção, compreender as emoções humanas continua sendo uma tarefa muito complexa. Embora os sistemas existentes tenham alcançado resultados notáveis, eles têm sido capazes de fazer isso principalmente quando as emoções são expressas em um grau significativo.

Em situações da vida real, Contudo, as pistas emocionais expressas pelos humanos costumam ser muito mais sutis. Por exemplo, a felicidade de uma pessoa nem sempre pode ser transmitida mostrando todos os dentes em um largo sorriso, mas pode envolver apenas um leve movimento dos cantos dos lábios.

"Seria muito interessante entender os aspectos mais subjetivos da emoção e como sua expressão difere entre os indivíduos, "Tautkute disse." Para ir mais longe, pode-se tentar distinguir as emoções falsas das genuínas. Por exemplo, neurologistas afirmam que diferentes músculos faciais estão envolvidos em sorrisos reais e falsos. Em particular, os músculos dos olhos não se contraem na expressão forçada. Seria interessante descobrir relações semelhantes usando informações aprendidas com os dados. "

© 2018 Science X Network