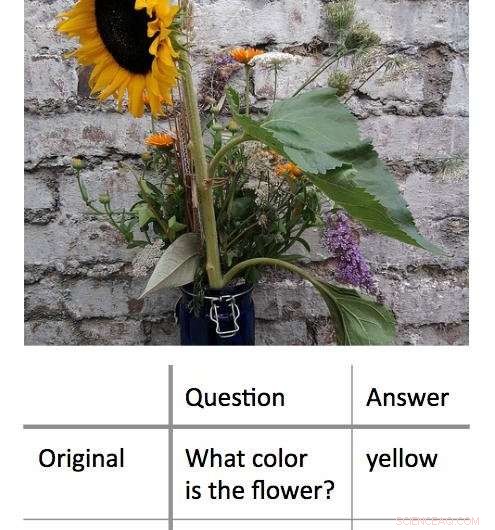

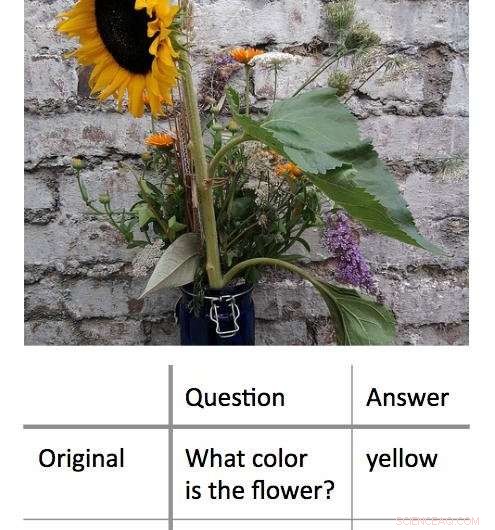

p Um novo método para decodificar os processos de tomada de decisão usados por algoritmos de aprendizado de máquina 'caixa preta' funciona encontrando a entrada mínima que ainda produzirá uma resposta correta. Neste exemplo, os pesquisadores primeiro apresentaram um algoritmo com uma foto de um girassol e perguntaram 'De que cor é a flor?' Isso resultou na resposta correta, 'amarelo.' Os pesquisadores descobriram que poderiam obter a mesma resposta correta, com um grau de confiança igualmente alto, fazendo ao algoritmo uma pergunta de uma única palavra:'Flor?' Crédito:Shi Feng / Universidade de Maryland

p Um novo método para decodificar os processos de tomada de decisão usados por algoritmos de aprendizado de máquina 'caixa preta' funciona encontrando a entrada mínima que ainda produzirá uma resposta correta. Neste exemplo, os pesquisadores primeiro apresentaram um algoritmo com uma foto de um girassol e perguntaram 'De que cor é a flor?' Isso resultou na resposta correta, 'amarelo.' Os pesquisadores descobriram que poderiam obter a mesma resposta correta, com um grau de confiança igualmente alto, fazendo ao algoritmo uma pergunta de uma única palavra:'Flor?' Crédito:Shi Feng / Universidade de Maryland

p Inteligência artificial - especificamente, aprendizado de máquina - faz parte da vida diária dos usuários de computadores e smartphones. Desde a correção automática de erros de digitação até a recomendação de novas músicas, algoritmos de aprendizado de máquina podem ajudar a tornar a vida mais fácil. Eles também podem cometer erros. p Pode ser um desafio para os cientistas da computação descobrir o que deu errado nesses casos. Isso ocorre porque muitos algoritmos de aprendizado de máquina aprendem com as informações e fazem suas previsões dentro de uma "caixa preta virtual", "deixando poucas pistas para os pesquisadores seguirem.

p Um grupo de cientistas da computação da Universidade de Maryland desenvolveu uma nova abordagem promissora para interpretar algoritmos de aprendizado de máquina. Ao contrário dos esforços anteriores, que normalmente buscava "quebrar" os algoritmos removendo palavras-chave das entradas para produzir a resposta errada, o grupo UMD, em vez disso, reduziu as entradas ao mínimo necessário para produzir a resposta correta. Na média, os pesquisadores obtiveram a resposta correta com uma entrada de menos de três palavras.

p Em alguns casos, os algoritmos do modelo dos pesquisadores forneceram a resposta correta com base em uma única palavra. Freqüentemente, a palavra ou frase de entrada parecia ter pouca conexão óbvia com a resposta, revelando insights importantes sobre como alguns algoritmos reagem a uma linguagem específica. Como muitos algoritmos são programados para dar uma resposta de qualquer forma - mesmo quando solicitados por uma entrada sem sentido - os resultados podem ajudar os cientistas da computação a construir algoritmos mais eficazes que podem reconhecer suas próprias limitações.

p Os pesquisadores apresentarão seus trabalhos no dia 4 de novembro, 2018 na Conferência de 2018 sobre Métodos Empíricos em Processamento de Linguagem Natural.

p "Os modelos de caixa preta parecem funcionar melhor do que os modelos mais simples, como árvores de decisão, mas mesmo as pessoas que escreveram o código inicial não podem dizer exatamente o que está acontecendo, "disse Jordan Boyd-Graber, o autor sênior do estudo e professor associado de ciência da computação na UMD. "Quando esses modelos retornam respostas incorretas ou sem sentido, é difícil descobrir por quê. Então, ao invés, tentamos encontrar a entrada mínima que produziria o resultado correto. A entrada média foi de cerca de três palavras, mas poderíamos resumir em uma única palavra em alguns casos. "

p Crédito CC0:domínio público

p Crédito CC0:domínio público

p Em um exemplo, os pesquisadores inseriram uma foto de um girassol e a pergunta baseada em texto, "Qual é a cor da flor?" como entradas em um algoritmo de modelo. Essas entradas produziram a resposta correta de "amarelo". Depois de reformular a pergunta em várias combinações diferentes de palavras mais curtas, os pesquisadores descobriram que poderiam obter a mesma resposta com "flor?" como a única entrada de texto para o algoritmo.

p Noutro, exemplo mais complexo, os pesquisadores usaram o prompt, "Em 1899, John Jacob Astor IV investiu $ 100, 000 para a Tesla desenvolver e produzir um novo sistema de iluminação. Em vez de, Tesla usou o dinheiro para financiar seus experimentos em Colorado Springs. "

p Eles então perguntaram ao algoritmo, "Em que Tesla gastou o dinheiro de Astor?" e recebeu a resposta correta, "Experimentos em Colorado Springs." Reduzir essa entrada à única palavra "did" resultou na mesma resposta correta.

p O trabalho revela importantes insights sobre as regras que os algoritmos de aprendizado de máquina aplicam para a resolução de problemas. Muitos problemas do mundo real com algoritmos ocorrem quando uma entrada que faz sentido para humanos resulta em uma resposta sem sentido. Ao mostrar que o oposto também é possível - que entradas sem sentido também podem resultar corretas, respostas sensatas - Boyd-Graber e seus colegas demonstram a necessidade de algoritmos que possam reconhecer quando respondem a uma pergunta sem sentido com um alto grau de confiança.

p "O ponto principal é que todo esse material sofisticado de aprendizado de máquina pode ser bem estúpido, "disse Boyd-Graber, que também tem co-nomeações no Instituto de Estudos Avançados de Computação da Universidade de Maryland (UMIACS), bem como na Faculdade de Estudos da Informação e Centro de Ciências da Linguagem da UMD. "Quando os cientistas da computação treinam esses modelos, nós normalmente mostramos a eles apenas perguntas reais ou sentenças reais. Não mostramos a eles frases sem sentido ou palavras isoladas. Os modelos não sabem que devem ser confundidos com esses exemplos. "

p A maioria dos algoritmos se forçará a fornecer uma resposta, mesmo com dados insuficientes ou conflitantes, de acordo com Boyd-Graber. Isso pode estar no cerne de algumas das saídas incorretas ou sem sentido geradas por algoritmos de aprendizado de máquina - em algoritmos de modelo usados para pesquisa, bem como algoritmos do mundo real que nos ajudam sinalizando e-mails de spam ou oferecendo rotas alternativas. Saber mais sobre esses erros pode ajudar os cientistas da computação a encontrar soluções e construir algoritmos mais confiáveis.

p “Mostramos que os modelos podem ser treinados para saber que devem ser confundidos, "Boyd-Graber disse." Então eles podem simplesmente vir e dizer, 'Você me mostrou algo que eu não consigo entender.' "