p Crédito:OpenAI

p Crédito:OpenAI

p Nós vamos, tanto para uma suposição que agora parece fácil demais de aceitar - que o magnífico cérebro humano tem tudo sobre uma máquina qualquer dia. Mesmo? Interpretamos o mundo com mais precisão do que uma "rede neural convolucional" pode? p Como Even Ackerman apontou, "quando uma CNN [rede neural convolucional] é apresentada com uma imagem, está olhando para uma grade estática de pixels retangulares. "

p Nós olhamos as imagens e as vemos corretamente, como humanos e animais; As CNNs parecem mais com computadores.

p Uma equipe de pesquisa está levantando questões sobre suposições fáceis, Contudo. Eles estão explorando o que acontece com exemplos adversários em relação aos humanos.

p As entradas para os modelos de aprendizado de máquina projetados para fazer com que os modelos cometam um erro são "exemplos adversários". Exemplos adversários, Como tal, pode ser potencialmente perigoso.

p Simplificando, "Os exemplos adversários são entradas maliciosas projetadas para enganar os modelos de aprendizado de máquina, "de acordo com uma página de pesquisa do Google.

p Como uma postagem de blog no OpenAI explicou, Os invasores podem visar veículos autônomos usando adesivos ou tinta para criar um sinal de parada adversário que o veículo interpretaria como um sinal de 'rendimento' ou outro sinal.

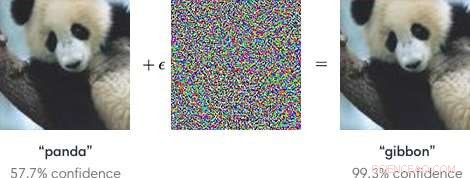

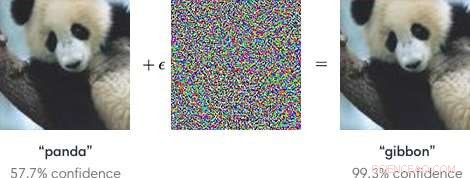

p Os pesquisadores, ao falar sobre modelos de aprendizado de máquina como vulneráveis a exemplos adversários, observou que pequenas mudanças nas imagens podem fazer com que os modelos de visão computacional cometam erros, como identificar um ônibus escolar como um avestruz.

p O blog da OpenAI referiu-se a exemplos adversários como representando um problema concreto na segurança de IA.

p Tendo dito isto, e os exemplos adversários que enganam os humanos? Isso pode acontecer?

p O time, disse Even Ackerman em

Espectro IEEE , "decidimos tentar descobrir se as mesmas técnicas que enganam as redes neurais artificiais também podem enganar as redes neurais biológicas dentro de nossas cabeças."

p O artigo de pesquisa que descreve seu trabalho é "Exemplos Adversários que Enganam a Visão Humana e Computacional, "no arXiv.

p "Aqui, criamos os primeiros exemplos de adversários projetados para enganar os humanos, "eles escreveram. Eles descobriram que" exemplos adversários que se transferem fortemente através de modelos de visão de computador influenciam as classificações feitas por observadores humanos com tempo limitado ". (Ackerman observou que no estudo, as pessoas só tinham entre 60 e 70 milissegundos para olhar para cada imagem e tomar uma decisão.)

p

Espectro IEEE Even Ackerman discutiu o que eles fizeram e apresentou um conjunto de duas imagens do Google Brain para apoiar sua explicação.

p Ackerman mostrou "a foto de um gato à esquerda. À direita, você pode dizer se é uma foto do mesmo gato, ou a foto de um cachorro parecido? A diferença entre as duas imagens é que a da direita foi ajustada um pouco por um algoritmo para tornar difícil para um tipo de modelo de computador chamado rede neural convolucional (CNN) ser capaz de dizer o que realmente é. Nesse caso, a CNN pensa que está olhando para um cachorro ao invés de um gato, mas o que é notável é que a maioria das pessoas pensa a mesma coisa. "

p O que? Como os humanos podem cometer o mesmo erro? Ackerman disse que pode ser possível direcionar o desenvolvimento de uma imagem adversária aos humanos "escolhendo modelos que correspondam o mais próximo possível ao sistema visual humano".

p Mas o que exatamente está atrapalhando a habilidade do humano de estar correto? Ackerman disse que os pesquisadores apontaram que "nossos exemplos adversários são projetados para enganar a percepção humana, portanto, devemos ter cuidado ao usar a percepção humana subjetiva para entender como eles funcionam. "

p Ele disse que estavam dispostos a fazer algumas generalizações "sobre algumas categorias diferentes de modificações, incluindo 'interromper as bordas do objeto, especialmente por modulações de frequência média perpendiculares à borda; aprimorando as bordas aumentando o contraste e criando limites de textura; modificando a textura; e aproveitando as regiões escuras da imagem, onde a magnitude perceptiva de pequenas perturbações pode ser maior. '"

p Como eles testaram:indivíduos com visão normal ou corrigida participaram do experimento.

p "Para cada grupo, uma imagem de adversário de sucesso foi capaz de enganar as pessoas fazendo-as escolher o membro errado do grupo, identificando-o como um cachorro quando na verdade é um gato, ou vice-versa, "Ackerman disse.

p Os sujeitos foram solicitados a classificar as imagens que apareciam na tela pressionando os botões em uma caixa de tempo de resposta, disseram os autores.

p Ackerman escreveu, "O curto período de tempo que a imagem foi mostrada mitigou a diferença entre como as CNNs percebem o mundo e como os humanos o fazem."

p O experimento envolveu três grupos de imagens:animais de estimação (gatos e cachorros), vegetais (repolho e brócolis), e "perigo" (aranhas e cobras).

p O comentário de Ackerman sobre os resultados da pesquisa foi que "há uma sobreposição entre a manipulação perceptiva das CNNs e a manipulação dos humanos. Isso significa que as técnicas de aprendizado de máquina podem ser usadas para alterar sutilmente coisas como fotos ou vídeos de uma forma que pode mudar nossa percepção de (e reação a) sem que percebêssemos o que estava acontecendo. "

p He added that "we'll have to be careful, and keep in mind that just like those computers, sometimes we're far too easy to fool."

p "Adversarial Examples that Fool both Human and Computer Vision" is by Gamaleldin F. Elsayed, Shreya Shankar, Brian Cheung, Nicolas Papernot, Alex Kurakin, Ian Goodfellow, and Jascha Sohl-Dickstein, on arXiv. p © 2018 Tech Xplore